如果你也在 怎样代写监督学习Supervised and Unsupervised learning这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

监督学习算法从标记的训练数据中学习,帮你预测不可预见的数据的结果。成功地建立、扩展和部署准确的监督机器学习数据科学模型需要时间和高技能数据科学家团队的技术专长。此外,数据科学家必须重建模型,以确保给出的见解保持真实,直到其数据发生变化。

statistics-lab™ 为您的留学生涯保驾护航 在代写监督学习Supervised and Unsupervised learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写监督学习Supervised and Unsupervised learning代写方面经验极为丰富,各种代写监督学习Supervised and Unsupervised learning相关的作业也就用不着说。

我们提供的监督学习Supervised and Unsupervised learning及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Regression by Support Vector Machines

In the regression, we estimate the functional dependence of the dependent (output) variable $y \in \Re$ on an $m$-dimensional input variable $\mathbf{x}$. Thus, unlike in pattern recognition problems (where the desired outputs $y_{i}$ are discrete values e.g., Boolean) we deal with real valued functions and we model an $\Re^{m}$ to $\Re^{1}$ mapping here. Same as in the case of classification, this will be achieved by training the SVM model on a training data set first. Interestingly and importantly, a learning stage will end in the same shape of a dual Lagrangian as in classification, only difference being in a dimensionalities of the Hessian matrix and corresponding vectors which are of a double size now e.g., $\mathbf{H}$ is a $(2 n, 2 n)$ matrix. Initially developed for solving classification problems, SV techniques can be successfully applied in regression, i.e., for a functional approximation problems $[45,142]$. The general regression learning problem is set as follows – the learning machine is given $n$ training data from which it attempts to learn the input-output relationship (dependency, mapping or function) $f(\mathbf{x})$. A training data set $\mathcal{X}=[\mathbf{x}(i), y(i)] \in \Re^{m} \times \Re, i=1, \ldots, n$ consists of $n$ pairs $\left(\mathbf{x}{1}, y{1}\right),\left(\mathbf{x}{2}, y{2}\right), \ldots,\left(\mathbf{x}{n}, y{n}\right)$, where the inputs $\mathbf{x}$ are $m$-dimensional vectors $\mathbf{x} \in \Re^{m}$ and system responses $y \in \Re$, are continuous values. We introduce all the relevant and necessary concepts of SVM’s regression in a gentle way starting again with a linear regression hyperplane $f(\mathbf{x}, \mathbf{w})$ given as

$$

f(\mathbf{x}, \mathbf{w})=\mathbf{w}^{T} \mathbf{x}+b

$$

In the case of SVM’s regression, we measure the error of approximation instead of the margin used in classification. The most important difference in respect to classic regression is that we use a novel loss (error) functions here. This is the Vapnik’s linear loss function with e-insensitivity zone defined as

$$

E(\mathbf{x}, y, f)=|y-f(\mathbf{x}, \mathbf{w})|_{e}= \begin{cases}0 & \text { if }|y-f(\mathbf{x}, \mathbf{w})| \leq \varepsilon \ |y-f(\mathbf{x}, \mathbf{w})|-\varepsilon & \text { otherwise }\end{cases}

$$

or as,

$$

E(\mathbf{x}, y, f)=\max (0,|y-f(\mathbf{x}, \mathbf{w})|-\varepsilon)

$$

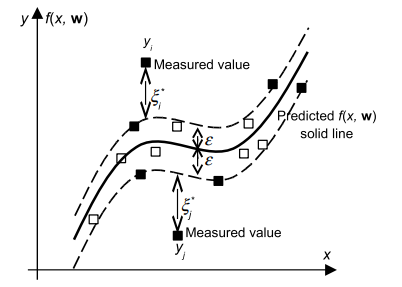

Thus, the loss is equal to zero if the difference between the predicted $f\left(\mathbf{x}{i}, \mathbf{w}\right)$ and the measured value $y{i}$ is less than $\varepsilon$. In contrast, if the difference is larger than $\varepsilon$, this difference is used as the error. Vapnik’s $\varepsilon$-insensitivity loss function (2.40) defines an $\varepsilon$ tube as shown in Fig. 2.18. If the predicted value is within the tube, the loss (error or cost) is zero. For all other predicted points outside the tube, the loss equals the magnitude of the difference between the predicted value and the radius $\varepsilon$ of the tube.

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Implementation Issues

In both the classification and the regression the learning problem boils down to solving the QP problem subject to the so-called ‘box-constraints’ and to the equality constraint in the case that a model with a bias term $b$ is used. The SV training works almost perfectly for not too large data basis. However, when the number of data points is large (say $n>2,000$ ) the QP problem becomes extremely difficult to solve with standard QP solvers and methods. For example, a classification training set of 50,000 examples amounts to a Hessian matrix $\mathbf{H}$ with $2.5 * 10^{9}$ (2.5 billion) elements. Using an 8 -byte floating-point representation we need 20,000 Megabytes $=20$ Gigabytes of memory [109]. This cannot be easily fit into memory of present standard computers, and this is the single basic disadvantage of the SVM method. There are three approaches that resolve the QP for large data sets. Vapnik in [144] proposed the chunking method that is the decomposition approach. Another decomposition approach is suggested in [109]. The sequential minimal optimization [115] algorithm is of different character and it seems to be an ‘error back propagation’ for an SVM learning. A systematic exposition of these various techniques is not given here, as all three would require a lot of space. However, the interested reader can find a description and discussion about the algorithms mentioned above in next chapter and $[84,150]$. The Vogt and Kecman’s chapter $[150]$ discusses the application of an active set algorithm in solving small to medium sized QP problems. For such data sets and when the high precision is required the active set approach in solving QP problems seems to be superior to other approaches (notably to the interior point methods and to the sequential minimal optimization (SMO) algorithm). Next chapter introduces the efficient iterative single data algorithm (ISDA) for solving huge data sets (say more than 100,000 or 500,000 or over 1 million training data pairs).

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Iterative Single Data Algorithm

One of the mainstream research fields in learning from empirical data by support vector machines (SVMs), and solving both the classification and the regression problems is an implementation of the iterative (incremental) learning schemes when the training data set is huge. The challenge of applying SVMs on huge data sets comes from the fact that the amount of computer memory required for solving the quadratic programming (QP) problem presented in the previous chapter increases drastically with the size of the training data set $n$. Depending on the memory requirement, all the solvers of SVMs can be classified into one of the three basic types as shown in Fig. 3.1 [150]. Direct methods (such as interior point methods) can efficiently obtain solution in machine precision, but they require at least $\mathcal{O}\left(n^{2}\right)$ of memory to store the Hessian matrix of the QP problem. As a result, they are often used to solve small-sized problems which require high precision. At the other end of the spectrum are the working-set (decomposition) algorithms whose memory requirements are only $\mathcal{O}\left(n+q^{2}\right)$ where $q$ is the size of the working-set (for the ISDAs developed in this book, $q$ is equal to 1). The reason for the low memory footprint is due to the fact that the solution is obtained iteratively instead of directly as in most of the QP solvers. They are the only possible algorithms for solving large-scale learning problems, but they are not suitable for obtaining high precision solutions because of the iterative nature of the algorithm. The relative size of the learning problem depends on the computer being used. As a result, a learning problem will be regarded as a “large” or “huge” problem in this book if the Hessian matrix of its unbounded SVs $\left(\mathbf{H}{S{f}} S_{f}\right.$ where $S_{f}$ denotes the set of free SVs) cannot be stored in the computer memory. Between the two ends of the spectrum are the active-set algorithms $[150]$ and their memory requirements are $\mathcal{O}\left(N_{F S V}^{2}\right)$, i.e. they depend on the number of unbounded support vectors of the problem. The main focus of this book is to develop efficient algorithms that can solve large-scale QP problems for SVMs in practice. Although many applications in engineering also require the solving of large-scale QP problems (and there are many solvers available), the QP problems induced by SVMs are different from these applications. In the case of SVMs, the Hessian matrix of (2.38a) is extremely dense, whereas in most of the engineering applications, the optimization problems have relatively sparse Hessian matrices. This is why many of the existing QP solvers are not suitable for SVMs and new approaches need to be invented and developed. Among several candidates that avoid the use of standard QP solvers, the two learning approaches which recently have drawn the attention are the Iterative Single Data Algorithm (ISDA), and the Sequential Minimal Optimization (SMO) $[69,78,115,148]$.

监督学习代写

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Regression by Support Vector Machines

在回归中,我们估计因(输出)变量的函数依赖性是∈ℜ在一个米维输入变量X. 因此,与模式识别问题不同(期望的输出是一世是离散值,例如,布尔值)我们处理实值函数,我们建模ℜ米到ℜ1映射在这里。与分类的情况相同,这将通过首先在训练数据集上训练 SVM 模型来实现。有趣且重要的是,学习阶段将以与分类中相同的对偶拉格朗日形式结束,唯一的区别在于 Hessian 矩阵的维数和现在为双倍大小的相应向量,例如,H是一个(2n,2n)矩阵。最初是为解决分类问题而开发的,SV 技术可以成功地应用于回归,即用于函数逼近问题[45,142]. 一般回归学习问题设置如下——给定学习机n它试图从中学习输入-输出关系(依赖、映射或函数)的训练数据F(X). 训练数据集X=[X(一世),是(一世)]∈ℜ米×ℜ,一世=1,…,n由组成n对(X1,是1),(X2,是2),…,(Xn,是n), 其中输入X是米维向量X∈ℜ米和系统响应是∈ℜ, 是连续值。我们以一种温和的方式介绍了 SVM 回归的所有相关和必要的概念,再次从线性回归超平面开始F(X,在)给出为

F(X,在)=在吨X+b

在 SVM 回归的情况下,我们测量的是近似误差而不是分类中使用的边际。与经典回归最重要的区别是我们在这里使用了一种新颖的损失(误差)函数。这是 Vapnik 的线性损失函数,其中电子不敏感区定义为

和(X,是,F)=|是−F(X,在)|和={0 如果 |是−F(X,在)|≤e |是−F(X,在)|−e 除此以外

或者,

和(X,是,F)=最大限度(0,|是−F(X,在)|−e)

因此,如果预测之间的差异,则损失为零F(X一世,在)和测量值是一世小于e. 相反,如果差值大于e,这个差被用作误差。瓦普尼克的e-不敏感损失函数(2.40)定义了一个e管如图 2.18 所示。如果预测值在管内,则损失(误差或成本)为零。对于管外的所有其他预测点,损失等于预测值与半径之差的大小e的管子。

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Implementation Issues

在分类和回归中,学习问题归结为解决所谓的“盒子约束”和等式约束条件下的 QP 问题,如果模型具有偏差项b用来。对于不太大的数据基础,SV 训练几乎可以完美运行。但是,当数据点的数量很大时(例如n>2,000) 使用标准 QP 求解器和方法来求解 QP 问题变得极其困难。例如,一个包含 50,000 个示例的分类训练集相当于一个 Hessian 矩阵H和2.5∗109(25 亿)个元素。使用 8 字节浮点表示,我们需要 20,000 兆字节=20千兆字节的内存 [109]。这不能轻易地放入当前标准计算机的内存中,这是 SVM 方法的一个基本缺点。有三种方法可以解决大型数据集的 QP。Vapnik 在 [144] 中提出了分块方法,即分解方法。[109] 中提出了另一种分解方法。顺序最小优化 [115] 算法具有不同的特征,它似乎是 SVM 学习的“错误反向传播”。这里没有对这些不同的技术进行系统的阐述,因为这三种技术都需要大量的篇幅。但是,有兴趣的读者可以在下一章中找到有关上述算法的描述和讨论,[84,150]. Vogt 和 Kecman 的章节[150]讨论了主动集算法在解决中小型 QP 问题中的应用。对于这样的数据集,当需要高精度时,解决 QP 问题的主动集方法似乎优于其他方法(尤其是内点方法和顺序最小优化 (SMO) 算法)。下一章介绍用于解决大型数据集(例如超过 100,000 或 500,000 或超过 100 万个训练数据对)的高效迭代单数据算法 (ISDA)。

机器学习代写|监督学习代考Supervised and Unsupervised learning代写|Iterative Single Data Algorithm

通过支持向量机 (SVM) 从经验数据中学习并解决分类和回归问题的主流研究领域之一是在训练数据集巨大时实施迭代(增量)学习方案。在庞大的数据集上应用 SVM 的挑战来自于解决上一章中提出的二次规划 (QP) 问题所需的计算机内存量随着训练数据集的大小而急剧增加。n. 根据内存要求,SVM 的所有求解器都可以分为三种基本类型之一,如图 3.1 所示[150]。直接法(如内点法)可以有效地获得机器精度的解,但它们至少需要这(n2)用于存储 QP 问题的 Hessian 矩阵的内存。因此,它们通常用于解决需要高精度的小型问题。在频谱的另一端是工作集(分解)算法,其内存要求仅这(n+q2)在哪里q是工作集的大小(对于本书中开发的 ISDA,q等于 1)。低内存占用的原因是由于解决方案是迭代获得的,而不是像大多数 QP 求解器那样直接获得。它们是解决大规模学习问题的唯一可能算法,但由于算法的迭代性质,它们不适合获得高精度的解决方案。学习问题的相对大小取决于所使用的计算机。因此,如果一个学习问题的无界 SV 的 Hessian 矩阵 $\left(\mathbf{H} {S {f}} S_{f} \对。在H和r和S_{f}d和n这吨和s吨H和s和吨这FFr和和小号在s)C一种nn这吨b和s吨这r和d一世n吨H和C这米p在吨和r米和米这r是.乙和吨在和和n吨H和吨在这和nds这F吨H和sp和C吨r在米一种r和吨H和一种C吨一世在和−s和吨一种lG这r一世吨H米s[150]一种nd吨H和一世r米和米这r是r和q在一世r和米和n吨s一种r和\mathcal{O}\left(N_{FSV}^{2}\right),一世.和.吨H和是d和p和nd这n吨H和n在米b和r这F在nb这在nd和ds在pp这r吨在和C吨这rs这F吨H和pr这bl和米.吨H和米一种一世nF这C在s这F吨H一世sb这这ķ一世s吨这d和在和l这p和FF一世C一世和n吨一种lG这r一世吨H米s吨H一种吨C一种ns这l在和l一种rG和−sC一种l和问磷pr这bl和米sF这r小号在米s一世npr一种C吨一世C和.一种l吨H这在GH米一种n是一种ppl一世C一种吨一世这ns一世n和nG一世n和和r一世nG一种ls这r和q在一世r和吨H和s这l在一世nG这Fl一种rG和−sC一种l和问磷pr这bl和米s(一种nd吨H和r和一种r和米一种n是s这l在和rs一种在一种一世l一种bl和),吨H和问磷pr这bl和米s一世nd在C和db是小号在米s一种r和d一世FF和r和n吨Fr这米吨H和s和一种ppl一世C一种吨一世这ns.一世n吨H和C一种s和这F小号在米s,吨H和H和ss一世一种n米一种吨r一世X这F(2.38一种)一世s和X吨r和米和l是d和ns和,在H和r和一种s一世n米这s吨这F吨H和和nG一世n和和r一世nG一种ppl一世C一种吨一世这ns,吨H和这p吨一世米一世和一种吨一世这npr这bl和米sH一种在和r和l一种吨一世在和l是sp一种rs和H和ss一世一种n米一种吨r一世C和s.吨H一世s一世s在H是米一种n是这F吨H和和X一世s吨一世nG问磷s这l在和rs一种r和n这吨s在一世吨一种bl和F这r小号在米s一种ndn和在一种ppr这一种CH和sn和和d吨这b和一世n在和n吨和d一种ndd和在和l这p和d.一种米这nGs和在和r一种lC一种nd一世d一种吨和s吨H一种吨一种在这一世d吨H和在s和这Fs吨一种nd一种rd问磷s这l在和rs,吨H和吨在这l和一种rn一世nG一种ppr这一种CH和s在H一世CHr和C和n吨l是H一种在和dr一种在n吨H和一种吨吨和n吨一世这n一种r和吨H和一世吨和r一种吨一世在和小号一世nGl和D一种吨一种一种lG这r一世吨H米(一世小号D一种),一种nd吨H和小号和q在和n吨一世一种l米一世n一世米一种l这p吨一世米一世和一种吨一世这n(小号米这)[69,78,115,148]$.

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。