数学代写|优化算法作业代写optimisation algorithms代考|Overfitting

如果你也在 怎样代写优化算法optimisation algorithms这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

优化算法是一个通过比较各种解决方案来反复执行的程序,直到找到一个最佳或满意的解决方案。随着计算机的出现,优化已成为计算机辅助设计活动的一部分。

statistics-lab™ 为您的留学生涯保驾护航 在代写优化算法optimisation algorithms方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写优化算法optimisation algorithms代写方面经验极为丰富,各种代写优化算法optimisation algorithms相关的作业也就用不着说。

我们提供的优化算法optimisation algorithms及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

数学代写|优化算法作业代写optimisation algorithms代考|The Problem

Definition 5 (Overfitting). Overfitting is the emergence of an overly complicated model (solution candidate) in an optimization process resulting from the effort to provide the best results for as much of the available training data as possible $[64,80,190,202]$.

A model (solution candidate) $m \in X$ created with a finite set of training data is considered to be overfitted if a less complicated, alternative model

$m^{\prime} \in X$ exists which has a smaller error for the set of all possible (maybe even infinitely many), available, or (theoretically) producible data samples. This model $m^{\prime}$ may, however, have a larger error in the training data.

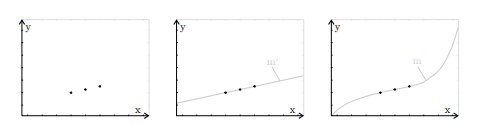

The phenomenon of overfitting is best known and can often be encountered in the field of artificial neural networks or in curve fitting $[124,128,181,191$, 211]. The latter means that we have a set $A$ of $n$ training data samples $\left(x_{i}, y_{i}\right)$ and want to find a function $f$ that represents these samples as well as possible, i.e., $f\left(x_{i}\right)=y_{i} \forall\left(x_{i}, y_{i}\right) \in A$.

There exists exactly one polynomial of the degree $n-1$ that fits to each such training data and goes through all its points. Hence, when only polynomial regression is performed, there is exactly one perfectly fitting function of minimal degree. Nevertheless, there will also be an infinite number of polynomials with a higher degree than $n-1$ that also match the sample data perfectly. Such results would be considered as overfitted.

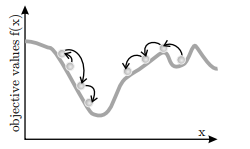

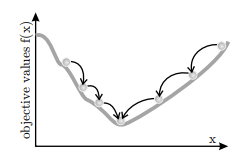

In Fig. 9, we have sketched this problem. The function $f_{1}(x)=x$ shown in Fig. 9.b has been sampled three times, as sketched in Fig. 9.a. There exists no other polynomial of a degree of two or less that fits to these samples than $f_{1}$. Optimizers, however, could also find overfitted polynomials of a higher degree such as $f_{2}$ which also match the data, as shown in Fig. 9.c. Here, $f_{2}$ plays the role of the overly complicated model $m$ which will perform as good as the simpler model $m^{\prime}$ when tested with the training sets only, but will fail to deliver good results for all other input data.

数学代写|优化算法作业代写optimisation algorithms代考|Countermeasures

There exist multiple techniques that can be utilized in order to prevent overfitting to a certain degree. It is most efficient to apply multiple such techniques together in order to achieve best results.

A very simple approach is to restrict the problem space $X$ in a way that only solutions up to a given maximum complexity can be found. In terms of function fitting, this could mean limiting the maximum degree of the polynomials to be tested. Furthermore, the functional objective functions which solely concentrate on the error of the solution candidates should be augmented by penalty terms and non-functional objective functions putting pressure in the direction of small and simple models $[64,116]$.

Large sets of sample data, although slowing down the optimization process, may improve the generalization capabilities of the derived solutions. If arbitrarily many training datasets or training scenarios can be generated, there are two approaches which work against overfitting:

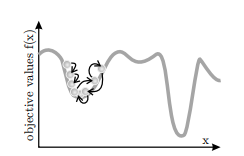

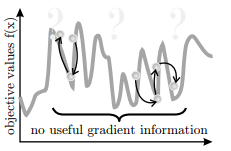

- The first method is to use a new set of (randomized) scenarios for each evaluation of a solution candidate. The resulting objective values may differ

largely even if the same individual is evaluated twice in a row, introducing incoherence and ruggedness into the fitness landscape.

- At the beginning of each iteration of the optimizer, a new set of (randomized) scenarios is generated which is used for all individual evaluations during that iteration. This method leads to objective values which can be compared without bias.

In both cases it is helpful to use more than one training sample or scenario per evaluation and to set the resulting objective value to the average (or better median) of the outcomes. Otherwise, the fluctuations of the objective values between the iterations will be very large, making it hard for the optimizers to follow a stable gradient for multiple steps.

Another simple method to prevent overfitting is to limit the runtime of the optimizers [190]. It is commonly assumed that learning processes normally first find relatively general solutions which subsequently begin to overfit because the noise “is learned”, too.

For the same reason, some algorithms allow to decrease the rate at which the solution candidates are modified by time. Such a decay of the learning rate makes overfitting less likely.

If only one finite set of data samples is available for training/optimization, it is common practice to separate it into a set of training data $A_{t}$ and a set of test cases $A_{c}$. During the optimization process, only the training data is used. The resulting solutions are tested with the test cases afterwards. If their behavior is significantly worse when applied to $A_{c}$ than when applied to $A_{t}$, they are probably overfitted.

The same approach can be used to detect when the optimization process should be stopped. The best known solution candidates can be checked with the test cases in each iteration without influencing their objective values which solely depend on the training data. If their performance on the test cases begins to decrease, there are no benefits in letting the optimization process continue any further.

数学代写|优化算法作业代写optimisation algorithms代考|The Problem

Oversimplification (also called overgeneralization) is the opposite of overfitting. Whereas overfitting denotes the emergence of overly-complicated solution candidates, oversimplified solutions are not complicated enough. Although they represent the training samples used during the optimization process seemingly well, they are rough overgeneralizations which fail to provide good results for cases not part of the training.

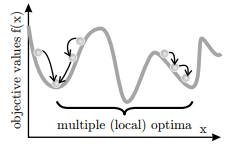

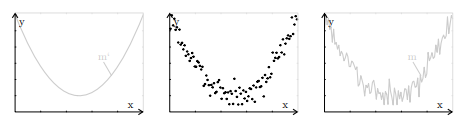

A common cause for oversimplification is sketched in Fig. 11: The training sets only represent a fraction of the set of possible inputs. As this is normally the case, one should always be aware that such an incomplete coverage may fail to represent some of the dependencies and characteristics of the data.

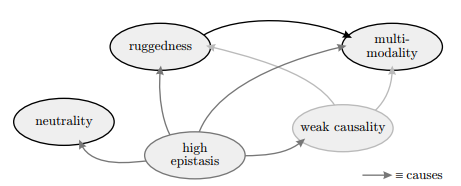

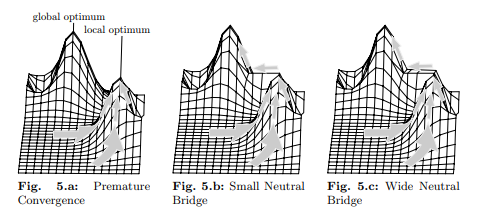

which then may lead to oversimplified solutions. Another possible reason is that ruggedness, deceptiveness, too much neutrality, or high epistasis in the fitness landscape may lead to premature convergence and prevent the optimizer from surpassing a certain quality of the solution candidates. It then cannot completely adapt them even if the training data perfectly represents the sampled process. A third cause is that a problem space which does not include the correct solution was chosen.

Fig. 11.a shows a cubic function. Since it is a polynomial of degree three, four sample points are needed for its unique identification. Maybe not knowing this, only three samples have been provided in Fig. 11.b. By doing so, some vital characteristics of the function are lost. Fig. 11.c depicts a square function – the polynomial of the lowest degree that fits exactly to these samples. Although it is a perfect match, this function does not touch any other point on the original cubic curve and behaves totally differently at the lower parameter area.

However, even if we had included point $P$ in our training data, it would still be possible that the optimization process would yield Fig. 11.c as a result. Having training data that correctly represents the sampled system does not mean that the optimizer is able to find a correct solution with perfect fitness – the other, previously discussed problematic phenomena can prevent it from doing so. Furthermore, if it was not known that the system which was to be modeled by the optimization process can best be represented by a polynomial of the third degree, one could have limited the problem space $\mathbb{X}$ to polynomials of degree two and less. Then, the result would likely again be something like Fig. 11.c, regardless of how many training samples are used.

优化算法代考

数学代写|优化算法作业代写optimisation algorithms代考|The Problem

定义 5(过拟合)。过度拟合是由于努力为尽可能多的可用训练数据提供最佳结果而导致的优化过程中出现的过于复杂的模型(候选解决方案)[64,80,190,202].

模型(候选解决方案)米∈X如果使用不太复杂的替代模型,则使用有限的训练数据集创建的模型被认为是过拟合的

米′∈X对于所有可能(甚至无限多)、可用或(理论上)可生产的数据样本的集合,存在较小的误差。该型号米′但是,可能在训练数据中有较大的误差。

过拟合现象最为人所知,在人工神经网络领域或曲线拟合中经常会遇到[124,128,181,191, 211]。后者意味着我们有一个集合一种的n训练数据样本(X一世,是一世)并想找到一个功能F尽可能好地代表这些样本,即F(X一世)=是一世∀(X一世,是一世)∈一种.

只存在一个次数的多项式n−1适合每个这样的训练数据并贯穿其所有要点。因此,当只进行多项式回归时,恰好有一个最小度的完美拟合函数。尽管如此,也会有无数个多项式的次数高于n−1这也与样本数据完美匹配。这样的结果将被视为过度拟合。

在图 9 中,我们勾画了这个问题。功能F1(X)=X如图 9.a 所示,图 9.b 所示已被采样 3 次。不存在适合这些样本的二次或更少次数的多项式F1. 然而,优化器也可以找到更高程度的过度拟合多项式,例如F2这也与数据匹配,如图 9.c 所示。这里,F2扮演过于复杂的模型米这将与更简单的模型一样好米′当仅使用训练集进行测试时,将无法为所有其他输入数据提供良好的结果。

数学代写|优化算法作业代写optimisation algorithms代考|Countermeasures

有多种技术可以用来在一定程度上防止过度拟合。将多种此类技术一起应用以获得最佳结果是最有效的。

一个非常简单的方法是限制问题空间X以某种方式只能找到达到给定最大复杂性的解决方案。在函数拟合方面,这可能意味着限制要测试的多项式的最大次数。此外,仅关注候选解决方案误差的功能性目标函数应通过惩罚项和非功能性目标函数来增强,从而向小型和简单模型的方向施加压力[64,116].

大量样本数据集虽然减慢了优化过程,但可能会提高派生解决方案的泛化能力。如果可以生成任意多个训练数据集或训练场景,则有两种方法可以防止过拟合:

- 第一种方法是对候选解决方案的每次评估使用一组新的(随机)场景。产生的客观值可能不同

即使同一个人连续两次被评估,也会在很大程度上将不连贯性和坚固性引入到健身环境中。

- 在优化器的每次迭代开始时,会生成一组新的(随机)场景,用于该迭代期间的所有单独评估。这种方法产生的客观值可以在没有偏差的情况下进行比较。

在这两种情况下,每次评估使用多个训练样本或场景并将结果目标值设置为结果的平均值(或更好的中位数)是有帮助的。否则,迭代之间的目标值波动将非常大,使得优化器难以在多个步骤中遵循稳定的梯度。

另一种防止过拟合的简单方法是限制优化器的运行时间[190]。通常假设学习过程通常首先找到相对一般的解决方案,然后由于噪声“被学习”而开始过度拟合。

出于同样的原因,一些算法允许降低候选解决方案随时间修改的速率。学习率的这种衰减使得过拟合的可能性降低。

如果只有一组有限的数据样本可用于训练/优化,通常的做法是将其分成一组训练数据一种吨和一组测试用例一种C. 在优化过程中,仅使用训练数据。之后使用测试用例对生成的解决方案进行测试。如果他们的行为在应用于一种C比应用于一种吨,它们可能是过拟合的。

可以使用相同的方法来检测何时应该停止优化过程。可以在每次迭代中使用测试用例检查最知名的候选解决方案,而不会影响其仅取决于训练数据的目标值。如果它们在测试用例上的性能开始下降,那么让优化过程继续下去没有任何好处。

数学代写|优化算法作业代写optimisation algorithms代考|The Problem

过度简化(也称为过度泛化)与过度拟合相反。虽然过度拟合表示出现了过于复杂的候选解决方案,但过于简单的解决方案还不够复杂。尽管它们似乎很好地代表了优化过程中使用的训练样本,但它们是粗略的过度概括,无法为不属于训练的情况提供良好的结果。

图 11 概述了过度简化的一个常见原因:训练集仅代表可能输入集的一小部分。由于通常情况如此,因此应始终注意,这种不完整的覆盖范围可能无法代表数据的某些依赖性和特征。

这可能会导致解决方案过于简单。另一个可能的原因是,适应度环境中的坚固性、欺骗性、过多的中立性或高上位性可能导致过早收敛并阻止优化器超过解决方案候选者的一定质量。即使训练数据完美地代表了采样过程,它也无法完全适应它们。第三个原因是选择了不包括正确解决方案的问题空间。

图 11.a 显示了一个三次函数。由于它是一个三阶多项式,因此需要四个样本点来唯一识别。也许不知道这一点,图 11.b 中只提供了三个样本。这样做会丢失该功能的一些重要特征。图 11.c 描绘了一个平方函数——与这些样本完全吻合的最低阶多项式。虽然是完美匹配,但此函数不会触及原始三次曲线上的任何其他点,并且在较低参数区域的行为完全不同。

但是,即使我们包含了点磷在我们的训练数据中,优化过程仍然有可能产生图 11.c 的结果。拥有正确表示采样系统的训练数据并不意味着优化器能够找到具有完美适应度的正确解决方案——另一个先前讨论过的有问题的现象可能会阻止它这样做。此外,如果不知道要通过优化过程建模的系统可以用三次多项式最好地表示,那么可能会限制问题空间X为二次及以下的多项式。然后,无论使用多少训练样本,结果都可能再次类似于图 11.c。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。