如果你也在 怎样代写机器学习中的优化理论Optimization for Machine Learningy CSC4512这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。机器学习中的优化理论Optimization for Machine Learningy是致力于解决优化问题的数学分支。 优化问题是我们想要最小化或最大化函数值的数学函数。 这些类型的问题在计算机科学和应用数学中大量存在。

机器学习中的优化理论Optimization for Machine Learningy每个优化问题都包含三个组成部分:目标函数、决策变量和约束。 当人们谈论制定优化问题时,它意味着将“现实世界”问题转化为包含这三个组成部分的数学方程和变量。目标函数,通常表示为 f 或 z,反映要最大化或最小化的单个量。交通领域的例子包括“最小化拥堵”、“最大化安全”、“最大化可达性”、“最小化成本”、“最大化路面质量”、“最小化排放”、“最大化收入”等等。

机器学习中的优化理论Optimization for Machine Learningy代写,免费提交作业要求, 满意后付款,成绩80\%以下全额退款,安全省心无顾虑。专业硕 博写手团队,所有订单可靠准时,保证 100% 原创。最高质量的机器学习中的优化理论Optimization for Machine Learningy作业代写,服务覆盖北美、欧洲、澳洲等 国家。 在代写价格方面,考虑到同学们的经济条件,在保障代写质量的前提下,我们为客户提供最合理的价格。 由于作业种类很多,同时其中的大部分作业在字数上都没有具体要求,因此机器学习中的优化理论Optimization for Machine Learningy作业代写的价格不固定。通常在专家查看完作业要求之后会给出报价。作业难度和截止日期对价格也有很大的影响。

数学代写|机器学习中的优化理论代写OPTIMIZATION FOR MACHINE LEARNING代考|Least Squares

The most important gradient formula is the one of the square loss (3), which can be obtained by expanding the norm

$$

\begin{aligned}

f(x+\varepsilon) &=\frac{1}{2}\left|A x-y+A \varepsilon\left|^2=\frac{1}{2}|A x-y|+\langle A x-y, A \varepsilon\rangle+\frac{1}{2} \mid A \varepsilon\right|^2\right.\

&=f(x)+\left\langle\varepsilon, A^{\top}(A x-y)\right\rangle+o(|\varepsilon|) .

\end{aligned}

$$

Here, we have used the fact that $|\left. A \varepsilon\right|^2=o(|\varepsilon|)$ and use the transpose matrix $A^{\top}$. This matrix is obtained by exchanging the rows and the columns, i.e. $A^{\top}=\left(A_{j, i}\right){i=1, \ldots, n}^{j=1, \ldots}$, but the way it should be remember and used is that it obeys the following swapping rule of the inner product, $$ \forall(u, v) \in \mathbb{R}^p \times \mathbb{R}^n, \quad\langle A u, v\rangle{\mathbb{R}^n}=\left\langle u, A^{\top} v\right\rangle_{\mathbb{R}^p}

$$

Computing gradient for function involving linear operator will necessarily requires such a transposition step. This computation shows that

$$

\nabla f(x)=A^{\top}(A x-y)

$$

This implies that solutions $x^{\star}$ minimizing $f(x)$ satisfies the linear system $\left(A^{\top} A\right) x^{\star}=A^{\top} y$. If $A^{\star} A \in \mathbb{R}^{p \times p}$ is invertible, then $f$ has a single minimizer, namely

$$

x^{\star}=\left(A^{\top} A\right)^{-1} A^{\top} y .

$$

This shows that in this case, $x^{\star}$ depends linearly on the data $y$, and the corresponding linear operator $\left(A^{\top} A\right)^{-1} A^{\star}$ is often called the Moore-Penrose pseudo-inverse of $A$ (which is not invertible in general, since typically $p \neq n$ ). The condition that $A^{\top} A$ is invertible is equivalent to ker $(A)={0}$, since

$$

A^{\top} A x=0 \quad \Longrightarrow \quad \mid A x |^2=\left\langle A^{\top} A x, x\right\rangle=0 \quad \Longrightarrow \quad A x=0 .

$$

In particular, if $n<p$ (under-determined regime, there is too much parameter or too few data) this can never holds. If $n \geqslant p$ and the features $x_i$ are “random” then $\operatorname{ker}(A)={0}$ with probability one. In this overdetermined situation $n \geqslant p, \operatorname{ker}(A)={0}$ only holds if the features $\left{a_i\right}_{i=1}^n$ spans a linear space $\operatorname{Im}\left(A^{\top}\right)$ of dimension strictly smaller than the ambient dimension $p$.

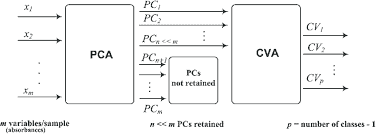

数学代写|机器学习中的优化理论代写OPTIMIZATION FOR MACHINE LEARNING代考|Link with PCA

Let us assume the $\left(a_i\right){i=1}^n$ are centered, i.e. $\sum_i a_i=0$. If this is not the case, one needs to replace $a_i$ by $a_i-m$ where $m \stackrel{\text { def. }}{=} \frac{1}{n} \sum{i=1}^n a_i \in \mathbb{R}^p$ is the empirical mean. In this case, $\frac{C}{n}=A^{\top} A / n \in \mathbb{R}^{p \times p}$ is the empirical covariance of the point cloud $\left(a_i\right)i$, it encodes the covariances between the coordinates of the points. Denoting $a_i=\left(a{i, 1}, \ldots, a_{i, p}\right)^{\top} \in \mathbb{R}^p$ (so that $\left.A=\left(a_{i, j}\right){i, j}\right)$ the coordinates, one has $$ \forall(k, \ell) \in{1, \ldots, p}^2, \quad \frac{C{k, \ell}}{n}=\frac{1}{n} \sum_{i=1}^n a_{i, k} a_{i, \ell}

$$

In particular, $C_{k, k} / n$ is the variance along the axis $k$. More generally, for any unit vector $u \in \mathbb{R}^p,\langle C u, u\rangle / n \geqslant$ 0 is the variance along the axis $u$.

For instance, in dimension $p=2$,

$$

\frac{C}{n}=\frac{1}{n}\left(\sum_{i=1}^n a_{i, 1}^2 \quad \sum_{i=1}^n a_{i, 1} a_{i, 2}\right)

$$

Since $C$ is a symmetric, it diagonalizes in an ortho-basis $U=\left(u_1, \ldots, u_p\right) \in \mathbb{R}^{p \times p}$. Here, the vectors $u_k \in \mathbb{R}^p$ are stored in the columns of the matrix $U$. The diagonalization means that there exist scalars (the eigenvalues) $\left(\lambda_1, \ldots, \lambda_p\right)$ so that $\left(\frac{1}{n} C\right) u_k=\lambda_k u_k$. Since the matrix is orthogononal, $U U^{\top}=U^{\top} U=\mathrm{Id}_p$, and equivalently $U^{-1}=U^{\top}$. The diagonalization property can be conveniently written as $\frac{1}{n} C=U \operatorname{diag}\left(\lambda_k\right) U^{\top}$. One can thus re-write the covariance quadratic form in the basis $U$ as being a separable sum of $p$ squares

$$

\frac{1}{n}\langle C x, x\rangle=\left\langle U \operatorname{diag}\left(\lambda_k\right) U^{\top} x, x\right\rangle=\left\langle\operatorname{diag}\left(\lambda_k\right)\left(U^{\top} x\right),\left(U^{\top} x\right)\right\rangle=\sum_{k=1}^p \lambda_k\left\langle x, u_k\right\rangle^2 .

$$

Here $\left(U^{\top} x\right)_k=\left\langle x, u_k\right\rangle$ is the coordinate $k$ of $x$ in the basis $U$. Since $\langle C x, x\rangle=|A x|^2$, this shows that all the eigenvalues $\lambda_k \geqslant 0$ are positive.

机器学习中的优化理论代考

数学代写|机器学习中的优化理论代写OPTIMIZATION FOR MACHINE LEARNING代考|Least Squares

最重要的梯度公式是平方损失 (3) 中的一个,可以通过扩展范数得到

$$

f(x+\varepsilon)=\frac{1}{2}|A x-y+A \varepsilon|^2=\frac{1}{2}|A x-y|+\langle A x-y, A \varepsilon\rangle+\frac{1}{2}|A \varepsilon|^2 \quad=f(x)+\left\langle\varepsilon, A^{\top}(A x\right.

$$

在这里,我们使用了这样一个事实 $|A \varepsilon|^2=o(|\varepsilon|)$ 并使用转置矩阵 $A^{\top}$. 这个矩阵是通过交换行和列得到的,即 $A^{\top}=\left(A_{j, i}\right) i=1, \ldots, n^{j=1, \cdots}$ ,但它应该被记住和使用的方式是它遵守以下内积交换规则,

$$

\forall(u, v) \in \mathbb{R}^p \times \mathbb{R}^n, \quad\langle A u, v\rangle \mathbb{R}^n=\left\langle u, A^{\top} v\right\rangle_{\mathbb{R}^p}

$$

计算涉及线性算子的函数的梯度必然需要这样的转置步骤。这个计算表明

$$

\nabla f(x)=A^{\top}(A x-y)

$$

这意味着解决方案 $x^{\star}$ 最小化 $f(x)$ 满足线性系统 $\left(A^{\top} A\right) x^{\star}=A^{\top} y$. 如果 $A^{\star} A \in \mathbb{R}^{p \times p}$ 是可逆的,那么 $f$ 有一 个最小化器,即

$$

x^{\star}=\left(A^{\top} A\right)^{-1} A^{\top} y .

$$

这表明在这种情况下, $x^{\star}$ 线性依赖于数据 $y$ ,以及对应的线性算子 $\left(A^{\top} A\right)^{-1} A^{\star}$ 通常称为 Moore-Penrose 伪逆 $A$ (一般来说这是不可逆的,因为通常 $p \neq n$ ). 条件是 $A^{\top} A$ 是可逆的相当于 $\operatorname{ker}(A)=0$ ,自从

$$

A^{\top} A x=0 \quad \Longrightarrow|A x|^2=\left\langle A^{\top} A x, x\right\rangle=0 \quad \Longrightarrow \quad A x=0 .

$$

特别是,如果 $n<p$ (末确定的制度,参数太多或数据太少) 这永远不会成立。如果 $n \geqslant p$ 和功能 $x_i$ 那么是“随 机的” $\operatorname{ker}(A)=0$ 概率为 1 。在这种多定的情况下 $n \geqslant p, \operatorname{ker}(A)=0$ 仅当特征成立 $\backslash$ left{a_ilright}_{i=1}^n 跨 $^{\prime}$ 越线性空间 $\operatorname{Im}\left(A^{\top}\right)$ 尺寸严格小于环境尺寸 $p$.

数学代写|机器学习中的优化理论代写OPTIMIZATION FOR MACHINE LEARNING代考|Link with PCA

让我们假设 $\left(a_i\right) i=1^n$ 居中,即 $\sum_i a_i=0$. 如果不是这种情况,则需要更换 $a_i$ 经过 $a_i-m$ 在哪里 $m \stackrel{\text { def. }}{=} \frac{1}{n} \sum i=1^n a_i \in \mathbb{R}^p$ 是经验平均值。在这种情况下, $\frac{C}{n}=A^{\top} A / n \in \mathbb{R}^{p \times p}$ 是点云的经验协方差 $\left(a_i\right) i$ ,它对点坐标之间的协方差进行编码。表示 $a_i=\left(a i, 1, \ldots, a_{i, p}\right)^{\top} \in \mathbb{R}^p$ (以便 $\left.A=\left(a_{i, j}\right) i, j\right)$ 坐 标,一个有

$$

\forall(k, \ell) \in 1, \ldots, p^2, \quad \frac{C k, \ell}{n}=\frac{1}{n} \sum_{i=1}^n a_{i, k} a_{i, \ell}

$$

尤其是, $C_{k, k} / n$ 是沿轴的方差 $k$. 更一般地,对于任何单位向量 $u \in \mathbb{R}^p,\langle C u, u\rangle / n \geqslant 0$ 是沿轴的方差 $u$. 例如,在维度 $p=2$ ,

$$

\frac{C}{n}=\frac{1}{n}\left(\sum_{i=1}^n a_{i, 1}^2 \quad \sum_{i=1}^n a_{i, 1} a_{i, 2}\right)

$$

自从 $C$ 是对称的,它在正交基上对角化 $U=\left(u_1, \ldots, u_p\right) \in \mathbb{R}^{p \times p}$. 在这里,载体 $u_k \in \mathbb{R}^p$ 存储在矩阵的列中 $U$. 对角化意味着存在标量 (特征值) $\left(\lambda_1, \ldots, \lambda_p\right)$ 以便 $\left(\frac{1}{n} C\right) u_k=\lambda_k u_k$. 由于矩阵是正交的,

$U U^{\top}=U^{\top} U=\operatorname{Id}p$ ,并且等价地 $U^{-1}=U^{\top}$. 对角化属性可以方便地写为 $\frac{1}{n} C=U \operatorname{diag}\left(\lambda_k\right) U^{\top}$. 因此可 以重写基中的协方差二次形式 $U$ 作为一个可分离的总和 $p$ 正方形 $$ \frac{1}{n}\langle C x, x\rangle=\left\langle U \operatorname{diag}\left(\lambda_k\right) U^{\top} x, x\right\rangle=\left\langle\operatorname{diag}\left(\lambda_k\right)\left(U^{\top} x\right),\left(U^{\top} x\right)\right\rangle=\sum{k=1}^p \lambda_k\left\langle x, u_k\right\rangle^2

$$

这里 $\left(U^{\top} x\right)_k=\left\langle x, u_k\right\rangle$ 是坐标 $k$ 的 $x$ 在基础上 $U$. 自从 $\langle C x, x\rangle=|A x|^2$ ,这表明所有的特征值 $\lambda_k \geqslant 0$ 是积极 的。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。