统计代写|统计与机器学习作业代写Statistical and Machine Learning代考|SEC595

如果你也在 怎样代写统计与机器学习Statistical and Machine Learning这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

统计学的目的是在样本的基础上对人群进行推断。机器学习被用来通过在数据中寻找模式来进行可重复的预测。

statistics-lab™ 为您的留学生涯保驾护航 在代写统计与机器学习Statistical and Machine Learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写统计与机器学习Statistical and Machine Learning方面经验极为丰富,各种代写机器学习Statistical and Machine Learning相关的作业也就用不着说。

我们提供的统计与机器学习Statistical and Machine Learning及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|统计与机器学习作业代写Statistical and Machine Learning代考|Modeling Basics

A model is a simplified description, using mathematical tools, of the processes we think that give rise to the observations in a set of data. A model is deterministic if it explains (completely) the dependent variables based on the independent ones. In many real-world scenarios, this is not possible. Instead, statistical (or stochastic) models try to approximate exact solutions by evaluating probabilistic distributions. For this reason, a statistical model is expressed by an equation composed of a systematic (deterministic) and a random part (Stroup 2012) as given in the next equation:

$$

y_i=f\left(x_i\right)+\epsilon_i \text {, for } i=1,2, \ldots, n,

$$

where $y_i$ represents the response variable in individual $i$ and $f\left(\boldsymbol{x}i\right)$ is the systematic part of the model because it is determined by the explanatory variables (predictors). For these reasons, the systematic part of the statistical learning model is also called the deterministic part of the model, which gives rise to an unknown mathematical function $(f)$ of $\boldsymbol{x}_i=x{i 1}, \ldots, x_{i p}$ not subject to random variability. $\epsilon_i$ is the $i$ th random element (error term) which is independent of $\boldsymbol{x}_i$ and has mean zero. The $\epsilon_i$ term tells us that observations are assumed to vary at random about their mean, and it also defines the uniqueness of each individual. In theory (at least in some philosophical domains), if we know the mechanism that gives rise to the uniqueness of each individual, we can write a completely deterministic model. However, this is rarely possible because we use probability distributions to characterize the observations measured in the individuals. Most of the time, the error term $\left(\epsilon_i\right)$ is assumed to follow a normal distribution with mean zero and variance $\sigma^2$ (Stroup 2012).

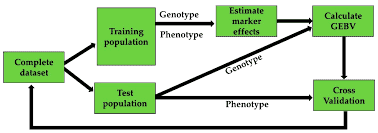

As given in Eq. (1.1), the $f$ function that gives rise to the systematic part of a statistical learning model is not restricted to a unique input variable, but can be a function of many, or even thousands. of input variables. In general, the set of approaches for estimating $f$ is called statistical learning (James et al. 2013). Also, the functions that $f$ can take are very broad due to the huge variety of phenomena we want to predict and due to the fact that there is no universally superior $f$ that can be used for all processes. For this reason, to be able to perform good predictions out of sample data, many times we need to fit many models and then choose the one most likely to succeed with the help of cross-validation techniques. However, due to the fact that models are only a simplified picture of the true complex process that gives rise to the data at hand, many times it is very hard to find a good candidate model. For this reason, statistical machine learning provides a catalog of different models and algorithms from which we try to find the one that best fits our data, since there is no universally best model and because there is evidence that a set of assumptions that works well in one domain may work poorly in another-this is called the no free lunch theorem by Wolpert (1996). All these are in agreement with the famous aphorism, “all models are wrong, but some are useful,” attributed to the British statistician George Box (October 18, 1919-March 28, 2013) who first mentioned this aphorism in his paper “Science and Statistics” published in the Journal of the American Statistical Association (Box 1976). As a result of the no free lunch theorem, we need to evaluate many models, algorithms, and sets of hyperparameters to find the best model in terms of prediction performance, speed of implementation, and degree of complexity. This book is concerned precisely with the appropriate combination of data, models, and algorithms needed to reach the best possible prediction performance.

统计代写|统计与机器学习作业代写Statistical and Machine Learning代考|The Two Cultures of Model Building: Prediction Versus Inference

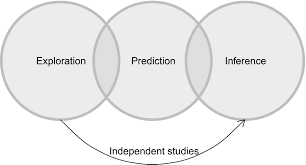

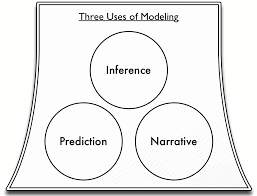

The term “two cultures” in statistical model building was coined by Breiman (2001) to explain the difference between the two goals for estimating $f$ in Eq. (1.1): prediction and inference. These definitions are provided in order to clarify the distinct scientific goals that follow inference and empirical predictions, respectively. A clear understanding and distinction between these two approaches is essential for the progress of scientific knowledge. Inference and predictive modeling reflect the process of using data and statistical (or data mining) methods for inferring or predicting, respectively. The term modeling is intentionally chosen over model to highlight the entire process involved, from goal definition, study design, and data collection to scientific use (Breiman 2001).

Prediction

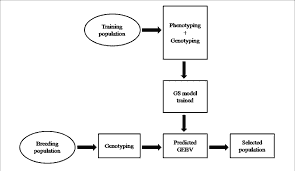

The prediction approach can be defined as the process of applying a statistical machine learning model or algorithm to data for the purpose of predicting new or future observations. For example, in plant breeding a set of inputs (marker information) and the outcome $\mathrm{Y}$ (disease resistance: yes or no) are available for some individuals, but for others only marker information is available. In this case, marker information can be used as a predictor and the disease status should be used as the response variable. When scientists are interested in predicting new plants not used to train the model, they simply want an accurate model to predict the response using the predictors. However, when scientists are interested in understanding the relationship between each individual predictor (marker) and the response variable, what they really want is a model for inference. Another example is when forest scientists are interested in developing models to predict the number of fire hotspots from an accumulated fuel dryness index, by vegetation type and region. In this context, it is obvious that scientists are interested in future predictions to improve decisionmaking in forest fire management. Another example is when an agro-industrial engineer is interested in developing an automated system for classifying mango species based on hundreds of mango images taken with digital cameras, mobile phones, etc. Here again it is clear that the best approach to build this system should be based on prediction modeling since the objective is the prediction of new mango species, not any of those used for training the model.

统计与机器学习代考

统计代写|统计与机器学习作业代写统计与机器学习代考|建模基础

模型是使用数学工具对我们认为在一组数据中产生观察结果的过程的一种简化描述。如果一个模型基于自变量(完全)解释因变量,那么它就是确定性的。在许多现实场景中,这是不可能的。相反,统计(或随机)模型试图通过评估概率分布来近似准确的解。因此,统计模型由一个由系统(确定性)和随机部分(Stroup 2012)组成的方程表示,如下一个方程所示:

$$

y_i=f\left(x_i\right)+\epsilon_i \text {, for } i=1,2, \ldots, n,

$$

,其中$y_i$表示个体$i$中的响应变量,而$f\left(\boldsymbol{x}i\right)$是模型的系统部分,因为它是由解释变量(预测器)决定的。由于这些原因,统计学习模型的系统部分也被称为模型的确定性部分,它产生了不受随机可变性影响的未知数学函数$(f)$或$\boldsymbol{x}i=x{i 1}, \ldots, x{i p}$。$\epsilon_i$是$i$的第一个随机元素(误差项),它独立于$\boldsymbol{x}_i$,其均值为零。$\epsilon_i$这个术语告诉我们,观察结果的平均值是随机变化的,它还定义了每个个体的唯一性。在理论上(至少在某些哲学领域),如果我们知道导致每个个体独特性的机制,我们就可以编写一个完全确定的模型。然而,这几乎是不可能的,因为我们使用概率分布来描述在个体中测量到的观察。大多数情况下,误差项$\left(\epsilon_i\right)$被假设遵循均值为零和方差为$\sigma^2$的正态分布(Stroup 2012)

如Eq.(1.1)所示,引起统计学习模型系统部分的$f$函数并不局限于一个唯一的输入变量,它可以是多个甚至数千个的函数。输入变量的。一般来说,估计$f$的一组方法被称为统计学习(James et al. 2013)。此外,由于我们想要预测的现象种类繁多,以及由于不存在可以用于所有过程的普遍优于$f$的事实,$f$可以承担的功能非常广泛。出于这个原因,为了能够在样本数据之外执行良好的预测,很多时候我们需要拟合许多模型,然后在交叉验证技术的帮助下选择最可能成功的一个。然而,由于模型只是产生手头数据的真正复杂过程的简化图像,因此很多时候很难找到一个好的候选模型。由于这个原因,统计机器学习提供了一系列不同的模型和算法,我们试图从中找到最适合我们的数据的模型和算法,因为不存在普遍的最佳模型,因为有证据表明一组假设在一个领域很好,但在另一个领域可能不太好——这被Wolpert(1996)称为“没有免费的午餐”定理。这与英国统计学家George Box(1919年10月18日- 2013年3月28日)在《美国统计协会杂志》(the Journal of the American Statistical Association, Box 1976)上发表的论文《科学与统计》(Science and Statistics)中首次提到的著名格言“所有的模型都是错误的,但有一些是有用的”是一致的。由于没有免费的午餐定理,我们需要评估许多模型、算法和超参数集,以找到在预测性能、实现速度和复杂性程度方面的最佳模型。本书精确地关注数据、模型和算法的适当组合,以达到可能的最佳预测性能

统计代写|统计与机器学习作业代写统计和机器学习代考|模型构建的两种文化:预测与推理

.

统计模型构建中的术语“两种文化”是由Breiman(2001)创造出来的,用来解释公式(1.1)中估计$f$的两个目标之间的差异:预测和推断。提供这些定义是为了分别阐明推理和经验预测之后的不同科学目标。对这两种方法的清楚理解和区分对于科学知识的进步是至关重要的。推理和预测建模分别反映了使用数据和统计(或数据挖掘)方法进行推理或预测的过程。从目标定义、研究设计、数据收集到科学使用(Breiman 2001),有意选择术语建模而不是模型,以突出涉及的整个过程。预测方法可以定义为将统计机器学习模型或算法应用于数据的过程,目的是预测新的或未来的观察结果。例如,在植物育种中,对一些个体可以获得一组输入(标记信息)和结果$\mathrm{Y}$(抗病:是或否),但对另一些个体则只能获得标记信息。在这种情况下,标记信息可作为预测因子,疾病状态应作为反应变量。当科学家们对预测新植物感兴趣而不是用来训练模型时,他们只是想要一个精确的模型来预测使用预测器的反应。然而,当科学家们对理解每个个体预测因子(标记)和反应变量之间的关系感兴趣时,他们真正想要的是一个推理模型。另一个例子是,当森林科学家有兴趣开发模型,根据植被类型和地区,根据累积的燃料干燥指数预测火灾热点的数量时。在这种背景下,很明显,科学家们对未来的预测很感兴趣,以改善森林火灾管理的决策。另一个例子是,一位农业工业工程师有兴趣开发一种自动系统,根据数码相机、手机等拍摄的数百张芒果图像对芒果进行分类。在这里,很明显,构建该系统的最佳方法应该基于预测建模,因为目标是预测新芒果物种,而不是用于训练模型的任何东西

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。统计代写|python代写代考

随机过程代考

在概率论概念中,随机过程是随机变量的集合。 若一随机系统的样本点是随机函数,则称此函数为样本函数,这一随机系统全部样本函数的集合是一个随机过程。 实际应用中,样本函数的一般定义在时间域或者空间域。 随机过程的实例如股票和汇率的波动、语音信号、视频信号、体温的变化,随机运动如布朗运动、随机徘徊等等。

贝叶斯方法代考

贝叶斯统计概念及数据分析表示使用概率陈述回答有关未知参数的研究问题以及统计范式。后验分布包括关于参数的先验分布,和基于观测数据提供关于参数的信息似然模型。根据选择的先验分布和似然模型,后验分布可以解析或近似,例如,马尔科夫链蒙特卡罗 (MCMC) 方法之一。贝叶斯统计概念及数据分析使用后验分布来形成模型参数的各种摘要,包括点估计,如后验平均值、中位数、百分位数和称为可信区间的区间估计。此外,所有关于模型参数的统计检验都可以表示为基于估计后验分布的概率报表。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

statistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

机器学习代写

随着AI的大潮到来,Machine Learning逐渐成为一个新的学习热点。同时与传统CS相比,Machine Learning在其他领域也有着广泛的应用,因此这门学科成为不仅折磨CS专业同学的“小恶魔”,也是折磨生物、化学、统计等其他学科留学生的“大魔王”。学习Machine learning的一大绊脚石在于使用语言众多,跨学科范围广,所以学习起来尤其困难。但是不管你在学习Machine Learning时遇到任何难题,StudyGate专业导师团队都能为你轻松解决。

多元统计分析代考

基础数据: $N$ 个样本, $P$ 个变量数的单样本,组成的横列的数据表

变量定性: 分类和顺序;变量定量:数值

数学公式的角度分为: 因变量与自变量

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。