商科代写|商业分析作业代写Statistical Modelling for Business代考|MNGT5232

如果你也在 怎样代写商业分析Statistical Modelling for Business这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

商业分析就是利用数据分析和统计的方法,来分析企业之前的商业表现,从而通过分析结果来对未来的商业战略进行预测和指导 。

statistics-lab™ 为您的留学生涯保驾护航 在代写商业分析Statistical Modelling for Business方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写商业分析Statistical Modelling for Business方面经验极为丰富,各种代写商业分析Statistical Modelling for Business相关的作业也就用不着说。

我们提供的商业分析Statistical Modelling for Business及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

商科代写|商业分析作业代写Statistical Modelling for Business代考|The Data Component

A common starting point for a discussion about data is that they are facts. There is a huge philosophical literature on what is a fact. As noted by Mulligan and Correia (2020), a fact is the opposite of theories and values and “are to be distinguished from things, in particular from complex objects, complexes and wholes, and from relations.” Without getting into this philosophy of facts, I will hold that a fact is a checkable or provable entity and, therefore, true. For example, it is true that Washington D.C. is the capital of the United States: it is easily checkable and can be shown to be true. It is also a fact that $1+1=2$. This is checkable by simply counting one finger on your left hand and one finger on your right hand. ${ }^3$

You could have a lot of facts on a topic but they are of little value if they are not

- organized,

- subsetted,

- manipulated, and

- interpreted

in a meaningfully way to provide insight for a recommendation for an action, the action being the problem solution. Otherwise, the facts are just a collection of valueless things. Their value stems from what you can do with them.

Organizing data, or facts, is a first step in any analytical process and the drive for information. This could involve arranging them in chronological order (e.g., by date and time of a transaction), spatial order (e.g., countries in the Northern and Southern Hemispheres), alphanumeric order, size order, and so on in an infinite number of ways. Transactions data, for example, are facts about units sold of a series of products including what products, who bought them, when they were sold, the amount sold, and prices. They are typically maintained in a file without a discernible order: just product, date, and units. There is no insight or intelligence from this data. In fact, it is somewhat randomly organized based on when orders were placed. ${ }^4$ If sorted by product and date, however, then they are organized and useful, but not much. The best organization is the one most applicable for a practical problem.

In Data Science, statistics, econometrics, machine learning, and other quantitative areas, a common organizational form is a rectangular array consisting of rows and columns: The rows are typically objects and the columns variables or features. An object can be a person (e.g., a customer) or an event (e.g., a transaction). The words object, case, individual, event, observation, and instance are often used interchangeably and I will certainly do this. For the methods considered in this book, each row is an individual case, one case per row and each case is in its own row.

商科代写|商业分析作业代写Statistical Modelling for Business代考|The Extractor Component

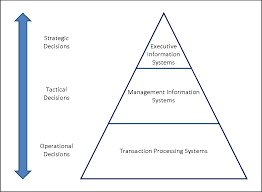

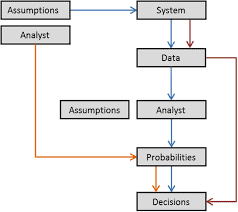

Finally, you have to apply some methods or procedures to your DataFrame to extract information. Refer back to Fig. $1.2$ for the role and position of an Extractor function in the information chain. This whole book is concerned with these methods. The interpretation of the results to give meaning to the information will be illustrated as I develop and discuss the methods, but the final interpretation is up to you based on your problem, your domain knowledge, and your expertise.

Due to the size and complexity of modern business data sets, the amount and type of information hidden inside them is large, to say the least. There is no one piece of information-no one size fits all-for all business problems. The same data set can be used for multiple problems and can yield multiple types of information. The possibilities are endless. The information content, however, is a function of the size and complexity of the DataFrame you eventually work with. The size is the number of data elements. Since a DataFrame is a rectangular array, the size is #rows $\times$ #columns elements and is given by its shape attribute. Shape is expressed as a tuple written as (rows, columns). For example, it could be $(5,2)$ for a DataFrame with 5 rows and 2 columns and 10 elements. The complexity is the types of data in the DataFrame and is difficult to quantify except to count types. They could be floating point numbers (or, simply, floats), integers (or ints), Booleans, text strings (referred to as objects), datetime values, and more. The larger and more complex the DataFrame, the more information you can extract. Let $I=I$ fformation, $S=$ size and $C=$ complexity. Then Information $=f(S, C)$ with $\partial I / \partial S>0$ and $\partial I / \partial C>0$. For a very large, complex DataFrame, there is a very large amount of information.

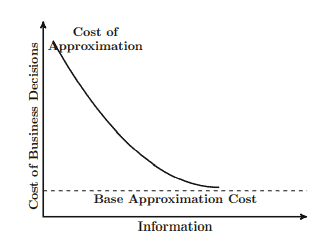

The cost of extracting information directly increases with the DataFrame’s size and complexity of the data. If I have 10 sales values, then my data set is small and simple. Minimal information, such as the mean, standard deviation, and range, can be extracted. The cost of extraction is low; just a hand-held calculator is needed. If I have $10 \mathrm{~GB}$ of data, then more can be done but at a greater cost. For data sizes approaching exabytes, the costs are monumental.

There could be an infinite amount of information, even contradictory information, in a large and complex DataFrame. So, when something is extracted, you have to check for its accuracy. For example, suppose you extract information that classifies customers by risk of default on extended credit. This particular classification may not be a good or correct one; that is, the predictive classifier $(P C)$ may not be the best one for determining whether someone is a credit risk or not. Predictive Error Analysis $(P E A)$ is needed to determine how well the $P C$ worked. I discuss this in Chap. 11. In that discussion, I will use a distinction between a training data set and a testing data set for building the classifier and testing it. This means the entire DataFrame will not, and should not, be used for a particular problem. It should be divided into the two parts although that division is not always clear, or even feasible. I will discuss the split into training and testing data sets in Chap.9.

The complexity of the DataFrame is, as I mentioned above, dependent on the types of data. Generally speaking, there are two forms: text and numeric. Other forms such as images and audio are possible but I will restrict myself to these two forms. I have to discuss these data types so that you know the possibilities and their importance and implications. How the two are handled within a DataFrame and with what statistical, econometric, and machine learning tools for the extraction of information is my focus in this book and so I will deal with them in depth in succeeding chapters. I will first discuss text data and then numeric data in the next two subsections.

商业分析代写

商科代写|商业分析作业代写Statistical Modelling for Business代考|The Data Component

讨论数据的一个共同出发点是它们是事实。关于什么是事实,有大量的哲学文献。正如 Mulligan 和 Correia(2020 年)所指出的,事实是理论和价值的对立面,并且“要与事物区分开来,特别是与复杂的对象、复合物和整体以及关系区分开来。” 在不进入这种事实哲学的情况下,我会认为事实是可检查或可证明的实体,因此是真实的。例如,华盛顿特区是美国的首都是真实的:它很容易验证并且可以被证明是真实的。这也是事实1+1=2. 这可以通过简单地计算左手的一根手指和右手的一根手指来检查。3

你可能有很多关于某个主题的事实,但如果不是,它们就没有什么价值

- 有组织的,

- 子集,

- 操纵,和

- 以有意义的方式进行解释

,以提供对行动建议的洞察力,行动就是问题的解决方案。否则,事实只是一堆毫无价值的东西。它们的价值源于您可以用它们做什么。

组织数据或事实是任何分析过程和信息驱动的第一步。这可能涉及按时间顺序(例如,按交易的日期和时间)、空间顺序(例如,北半球和南半球的国家/地区)、字母数字顺序、大小顺序等以无数种方式排列它们。例如,交易数据是关于一系列产品的销售单位的事实,包括产品种类、购买者、销售时间、销售量和价格。它们通常保存在一个没有明显顺序的文件中:只有产品、日期和单位。这些数据没有任何洞察力或情报。事实上,它是根据下订单的时间随机组织的。4然而,如果按产品和日期排序,那么它们是有条理和有用的,但并不多。最好的组织是最适用于实际问题的组织。

在数据科学、统计学、计量经济学、机器学习和其他定量领域,一种常见的组织形式是由行和列组成的矩形数组:行通常是对象,列通常是变量或特征。对象可以是人(例如,客户)或事件(例如,交易)。对象、案例、个体、事件、观察和实例这些词经常互换使用,我当然会这样做。对于本书中考虑的方法,每一行都是一个个案,每行一个案例,每个案例都在它自己的行中。

商科代写|商业分析作业代写Statistical Modelling for Business代考|The Extractor Component

最后,您必须对 DataFrame 应用一些方法或过程来提取信息。回头再看图1.2Extractor函数在信息链中的作用和位置。整本书都与这些方法有关。在我开发和讨论这些方法时,将说明对结果赋予信息意义的解释,但最终解释取决于你根据你的问题、你的领域知识和你的专业知识。

由于现代商业数据集的规模和复杂性,至少可以说,隐藏在其中的信息量和类型都很大。没有一种信息可以解决所有业务问题,没有一种方法可以解决所有问题。同一数据集可用于多个问题,并可产生多种类型的信息。可能性是无止境。然而,信息内容是您最终使用的 DataFrame 的大小和复杂性的函数。大小是数据元素的数量。由于 DataFrame 是一个矩形数组,因此大小为 #rows×#columns 元素并由其 shape 属性给出。形状表示为一个元组,写为(行,列)。例如,它可能是(5,2)对于具有 5 行和 2 列以及 10 个元素的 DataFrame。复杂性在于 DataFrame 中的数据类型,除了统计类型外很难量化。它们可以是浮点数(或简称为浮点数)、整数(或整数)、布尔值、文本字符串(称为对象)、日期时间值等。DataFrame 越大越复杂,您可以提取的信息就越多。让我=我形成,小号=大小和C=复杂。然后信息=F(小号,C)和∂我/∂小号>0和∂我/∂C>0. 对于一个非常庞大、复杂的DataFrame,信息量非常大。

提取信息的成本直接随着 DataFrame 的大小和数据的复杂性而增加。如果我有 10 个销售值,那么我的数据集很小而且很简单。可以提取最少的信息,例如均值、标准差和范围。开采成本低;只需要一个手持式计算器。如果我有10 G乙的数据,那么可以做更多的事情,但成本更高。对于接近 EB 的数据大小,成本是巨大的。

在一个庞大而复杂的 DataFrame 中,可能存在无限量的信息,甚至是相互矛盾的信息。因此,当提取某些内容时,您必须检查其准确性。例如,假设您提取按延期信贷违约风险对客户进行分类的信息。这个特定的分类可能不是一个好的或正确的分类;也就是说,预测分类器(PC)可能不是确定某人是否存在信用风险的最佳方法。预测误差分析(P和一个)需要确定如何以及PC工作了。我在第 1 章讨论这个问题。11. 在那次讨论中,我将使用训练数据集和测试数据集之间的区别来构建分类器和测试它。这意味着整个 DataFrame 不会也不应该用于解决特定问题。它应该分为两部分,尽管这种划分并不总是很清楚,甚至不可行。我将在第 9 章讨论训练和测试数据集的拆分。

正如我上面提到的,DataFrame 的复杂性取决于数据的类型。一般来说,有两种形式:文本和数字。图像和音频等其他形式也是可能的,但我将限制自己使用这两种形式。我必须讨论这些数据类型,以便您了解可能性及其重要性和含义。如何在 DataFrame 中处理这两者以及使用哪些统计、计量经济学和机器学习工具来提取信息是本书的重点,因此我将在后续章节中深入讨论它们。在接下来的两小节中,我将首先讨论文本数据,然后再讨论数字数据。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。统计代写|python代写代考

随机过程代考

在概率论概念中,随机过程是随机变量的集合。 若一随机系统的样本点是随机函数,则称此函数为样本函数,这一随机系统全部样本函数的集合是一个随机过程。 实际应用中,样本函数的一般定义在时间域或者空间域。 随机过程的实例如股票和汇率的波动、语音信号、视频信号、体温的变化,随机运动如布朗运动、随机徘徊等等。

贝叶斯方法代考

贝叶斯统计概念及数据分析表示使用概率陈述回答有关未知参数的研究问题以及统计范式。后验分布包括关于参数的先验分布,和基于观测数据提供关于参数的信息似然模型。根据选择的先验分布和似然模型,后验分布可以解析或近似,例如,马尔科夫链蒙特卡罗 (MCMC) 方法之一。贝叶斯统计概念及数据分析使用后验分布来形成模型参数的各种摘要,包括点估计,如后验平均值、中位数、百分位数和称为可信区间的区间估计。此外,所有关于模型参数的统计检验都可以表示为基于估计后验分布的概率报表。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

statistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

机器学习代写

随着AI的大潮到来,Machine Learning逐渐成为一个新的学习热点。同时与传统CS相比,Machine Learning在其他领域也有着广泛的应用,因此这门学科成为不仅折磨CS专业同学的“小恶魔”,也是折磨生物、化学、统计等其他学科留学生的“大魔王”。学习Machine learning的一大绊脚石在于使用语言众多,跨学科范围广,所以学习起来尤其困难。但是不管你在学习Machine Learning时遇到任何难题,StudyGate专业导师团队都能为你轻松解决。

多元统计分析代考

基础数据: $N$ 个样本, $P$ 个变量数的单样本,组成的横列的数据表

变量定性: 分类和顺序;变量定量:数值

数学公式的角度分为: 因变量与自变量

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。