数学代写|信息论代写information theory代考|ECET602

如果你也在 怎样代写信息论information theory 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。信息论information theory回答了通信理论中的两个基本问题:什么是最终的数据压缩(答案:熵$H$),什么是通信的最终传输速率(答案:信道容量$C$)。由于这个原因,一些人认为信息论是通信理论的一个子集。我们认为它远不止于此。

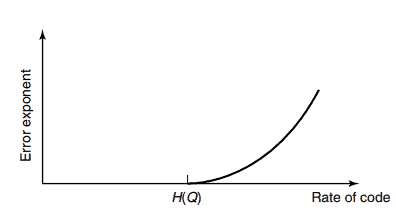

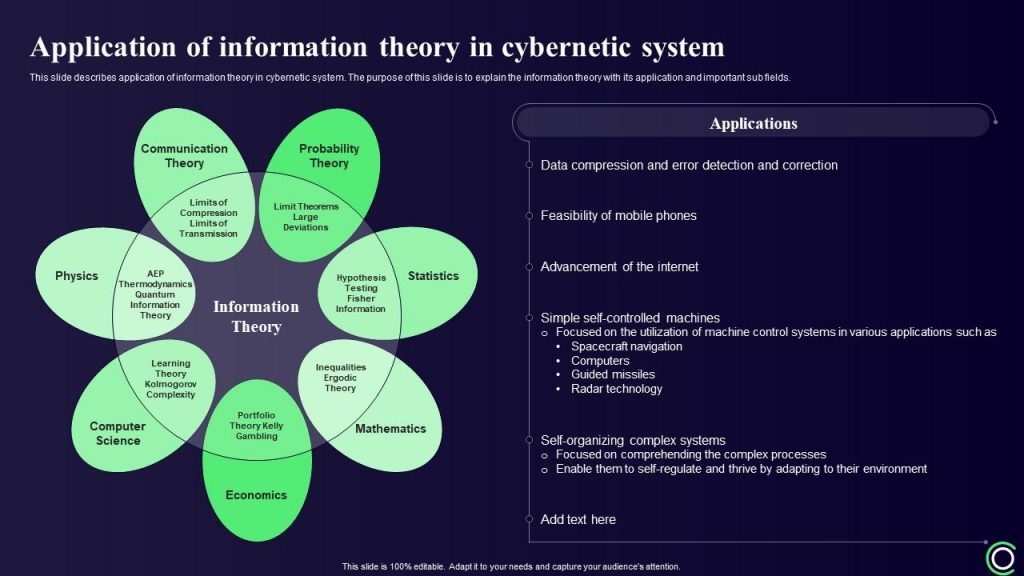

信息论information theory在统计物理学(热力学)、计算机科学(柯尔莫哥洛夫复杂性或算法复杂性)、统计推断(奥卡姆剃刀:“最简单的解释是最好的”)以及概率和统计学(最优假设检验和估计的误差指数)方面都做出了根本性的贡献。

statistics-lab™ 为您的留学生涯保驾护航 在代写信息论information theory方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写信息论information theory代写方面经验极为丰富,各种代写信息论information theory相关的作业也就用不着说。

数学代写|信息论代写information theory代考|KOLMOGOROV SUFFICIENT STATISTIC

Suppose that we are given a sample sequence from a $\operatorname{Bernoulli}(\theta)$ process. What are the regularities or deviations from randomness in this sequence? One way to address the question is to find the Kolmogorov complexity $K\left(x^n \mid n\right)$, which we discover to be roughly $n H_0(\theta)+\log n+c$. Since, for $\theta \neq \frac{1}{2}$, this is much less than $n$, we conclude that $x^n$ has structure and is not randomly drawn Bernoulli $\left(\frac{1}{2}\right)$. But what is the structure? The first attempt to find the structure is to investigate the shortest program $p^$ for $x^n$. But the shortest description of $p^$ is about as long as $p^$ itself; otherwise, we could further compress the description of $x^n$, contradicting the minimality of $p^$. So this attempt is fruitless.

A hint at a good approach comes from an examination of the way in which $p^*$ describes $x^n$. The program “The sequence has $k 1$ ‘s; of such sequences, it is the $i$ th” is optimal to first order for $\operatorname{Bernoulli}(\theta)$ sequences. We note that it is a two-stage description, and all of the structure of the sequence is captured in the first stage. Moreover, $x^n$ is maximally complex given the first stage of the description. The first stage, the description of $k$, requires $\log (n+1)$ bits and defines a set $S=\left{x \in{0,1}^n: \sum x_i=k\right}$. The second stage requires $\log |S|=\log \left(\begin{array}{l}n \ k\end{array}\right) \approx n H_0\left(\bar{x}_n\right) \approx n H_0(\theta)$ bits and reveals nothing extraordinary about $x^n$.

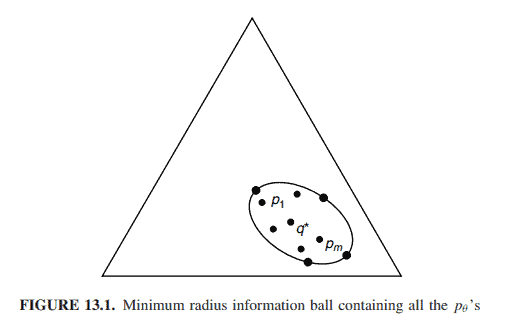

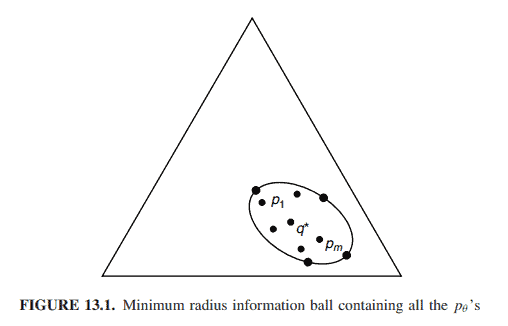

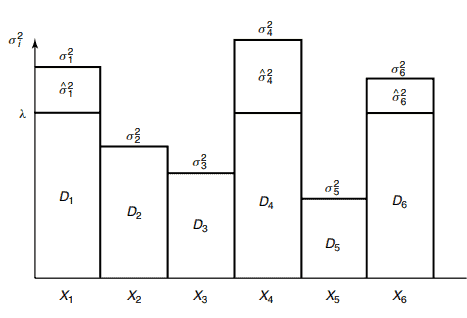

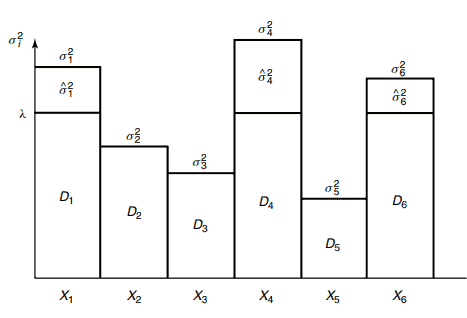

We mimic this process for general sequences by looking for a simple set $S$ that contains $x^n$. We then follow it with a brute-force description of $x^n$ in $S$ using $\log |S|$ bits. We begin with a definition of the smallest set containing $x^n$ that is describable in no more than $k$ bits.

Definition The Kolmogorov structure function $K_k\left(x^n \mid n\right)$ of a binary string $x \in{0,1}^n$ is defined as

$$

K_k\left(x^n \mid n\right)=\min _{p: l(p) \leq k} \log |S| .

$$

The set $S$ is the smallest set that can be described with no more than $k$ bits and which includes $x^n$. By $\mathcal{U}(p, n)=S$, we mean that running the program $p$ with data $n$ on the universal computer $\mathcal{U}$ will print out the indicator function of the set $S$.

数学代写|信息论代写information theory代考|MINIMUM DESCRIPTION LENGTH PRINCIPLE

A natural extension of Occam’s razor occurs when we need to describe data drawn from an unknown distribution. Let $X_1, X_2, \ldots, X_n$ be drawn i.i.d. according to probability mass function $p(x)$. We assume that we do not know $p(x)$, but know that $p(x) \in \mathcal{P}$, a class of probability mass functions. Given the data, we can estimate the probability mass function in $\mathcal{P}$ that best fits the data. For simple classes $\mathcal{P}$ (e.g., if $\mathcal{P}$ has only finitely many distributions), the problem is straightforward, and the maximum likelihood procedure [i.e., find $\hat{p} \in \mathcal{P}$ that maximizes $\hat{p}\left(X_1, X_2, \ldots, X_n\right)$ ] works well. However, if the class $\mathcal{P}$ is rich enough, there is a problem of overfitting the data. For example, if $X_1, X_2, \ldots, X_n$ are continuous random variables, and if $\mathcal{P}$ is the set of all probability distributions, the maximum likelihood estimator given $X_1, X_2, \ldots, X_n$ is a distribution that places a single mass point of weight $\frac{1}{n}$ at each observed value. Clearly, this estimate is too closely tied to actual observed data and does not capture any of the structure of the underlying distribution.

To get around this problem, various methods have been applied. In the simplest case, the data are assumed to come from some parametric distribution (e.g., the normal distribution), and the parameters of the distribution are estimated from the data. To validate this method, the data should be tested to check whether the distribution “looks” normal, and if the data pass the test, we could use this description of the data. A more general procedure is to take the maximum likelihood estimate and smooth it out to obtain a smooth density. With enough data, and appropriate smoothness conditions, it is possible to make good estimates of the original density. This process is called kernel density estimation.

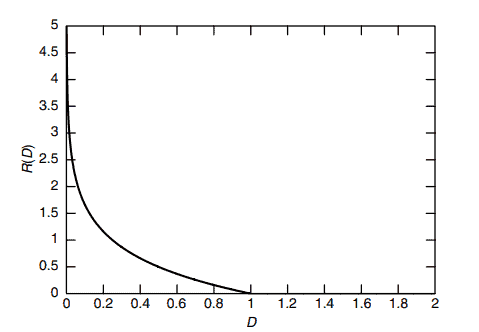

However, the theory of Kolmogorov complexity (or the Kolmogorov sufficient statistic) suggests a different procedure: Find the $p \in \mathcal{P}$ that minimizes

$$

L_p\left(X_1, X_2, \ldots, X_n\right)=K(p)+\log \frac{1}{p\left(X_1, X_2, \ldots, X_n\right)} .

$$

This is the length of a two-stage description of the data, where we first describe the distribution $p$ and then, given the distribution, construct the Shannon code and describe the data using $\log \frac{1}{p\left(X_1, X_2, \ldots, X_n\right)}$ bits. This procedure is a special case of what is termed the minimum description length (MDL) principle: Given data and a choice of models, choose the model such that the description of the model plus the conditional description of the data is as short as possible.

信息论代写

数学代写|信息论代写information theory代考|KOLMOGOROV SUFFICIENT STATISTIC

假设我们得到一个来自$\operatorname{Bernoulli}(\theta)$过程的样本序列。在这个序列中有什么规律或偏离随机性?解决这个问题的一种方法是找到柯尔莫哥洛夫复杂度$K\left(x^n \mid n\right)$,我们发现它大致为$n H_0(\theta)+\log n+c$。因为,对于$\theta \neq \frac{1}{2}$,这比$n$小得多,我们得出结论,$x^n$具有结构,不是随机绘制的伯努利$\left(\frac{1}{2}\right)$。但是它的结构是什么呢?要找到这个结构,首先要研究$x^n$的最短程序$p^$。但对$p^$的最短描述大约和$p^$本身一样长;否则,我们可以进一步压缩$x^n$的描述,与$p^$的最小化相矛盾。所以这种尝试是徒劳的。

从对$p^*$描述$x^n$的方式的考察中可以看出这是一种好的方法。程序“序列有$k 1$’s;在这些序列中,对于$\operatorname{Bernoulli}(\theta)$序列,最优的是$i$ th”。我们注意到这是一个两阶段的描述,序列的所有结构都在第一个阶段被捕获。此外,在描述的第一阶段,$x^n$是最复杂的。第一阶段,描述$k$,需要$\log (n+1)$位,并定义一个集$S=\left{x \in{0,1}^n: \sum x_i=k\right}$。第二阶段需要$\log |S|=\log \left(\begin{array}{l}n \ k\end{array}\right) \approx n H_0\left(\bar{x}_n\right) \approx n H_0(\theta)$位,并没有显示出$x^n$的特别之处。

我们通过查找包含$x^n$的简单集合$S$来模拟一般序列的此过程。然后,我们使用$\log |S|$位对$S$中的$x^n$进行强力描述。我们从包含$x^n$的最小集合的定义开始,该集合可以用不超过$k$位来描述。

定义二进制字符串$x \in{0,1}^n$的Kolmogorov结构函数$K_k\left(x^n \mid n\right)$定义为

$$

K_k\left(x^n \mid n\right)=\min _{p: l(p) \leq k} \log |S| .

$$

集合$S$是可以用不超过$k$位描述的最小集合,其中包括$x^n$。通过$\mathcal{U}(p, n)=S$,我们的意思是在通用计算机$\mathcal{U}$上运行带有数据$n$的程序$p$,将打印出集合$S$的指示函数。

数学代写|信息论代写information theory代考|MINIMUM DESCRIPTION LENGTH PRINCIPLE

当我们需要描述从未知分布中提取的数据时,奥卡姆剃刀的自然扩展就出现了。设$X_1, X_2, \ldots, X_n$根据概率质量函数$p(x)$绘制i.i.d。我们假设不知道$p(x)$,但知道$p(x) \in \mathcal{P}$,一类概率质量函数。给定数据,我们可以估计$\mathcal{P}$中最适合数据的概率质量函数。对于简单的类$\mathcal{P}$(例如,如果$\mathcal{P}$只有有限多个分布),问题很简单,最大似然过程[即,找到使$\hat{p}\left(X_1, X_2, \ldots, X_n\right)$最大化的$\hat{p} \in \mathcal{P}$]工作得很好。但是,如果类$\mathcal{P}$足够丰富,就会出现数据过拟合的问题。例如,如果$X_1, X_2, \ldots, X_n$是连续随机变量,如果$\mathcal{P}$是所有概率分布的集合,则给定$X_1, X_2, \ldots, X_n$的最大似然估计量是在每个观测值处放置单个质量点$\frac{1}{n}$的分布。显然,这一估计与实际观察到的数据过于紧密地联系在一起,并没有捕捉到潜在分布的任何结构。

为了解决这个问题,人们采用了各种方法。在最简单的情况下,假设数据来自某些参数分布(例如,正态分布),并且从数据中估计分布的参数。为了验证这种方法,应该对数据进行测试,以检查分布是否“看起来”正态,如果数据通过了测试,我们可以使用数据的这种描述。更一般的方法是取最大似然估计并将其平滑以获得平滑密度。有了足够的数据和适当的平滑条件,就可以很好地估计原始密度。这个过程称为核密度估计。

然而,Kolmogorov复杂性理论(或Kolmogorov充分统计量)提出了一个不同的过程:找到最小化的$p \in \mathcal{P}$

$$

L_p\left(X_1, X_2, \ldots, X_n\right)=K(p)+\log \frac{1}{p\left(X_1, X_2, \ldots, X_n\right)} .

$$

这是数据的两阶段描述的长度,其中我们首先描述分布$p$,然后在给定分布的情况下,构造香农代码并使用$\log \frac{1}{p\left(X_1, X_2, \ldots, X_n\right)}$位描述数据。这个过程是所谓最小描述长度(MDL)原则的一种特殊情况:给定数据和模型的选择,选择模型,使模型的描述加上数据的条件描述尽可能短。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。