统计代写|经济统计代写Economic Statistics代考|ECO380

如果你也在 怎样代写经济统计Economic Statistics这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

经济统计是应用统计学和应用经济学的一个主题,涉及经济数据的收集、处理、汇编、传播和分析。它与商业统计和计量经济学密切相关。

statistics-lab™ 为您的留学生涯保驾护航 在代写经济统计Economic Statistics方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写经济统计Economic Statistics代写方面经验极为丰富,各种代写经济统计Economic Statistics相关的作业也就用不着说。

我们提供的经济统计Economic Statistics及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|经济统计代写Economic Statistics代考|Forecasting with a Random Forest Algorithm

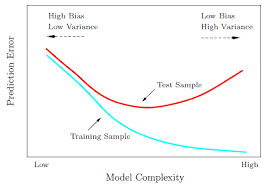

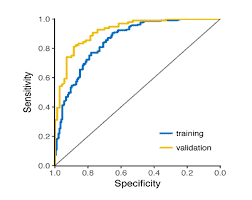

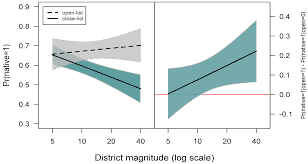

We leverage a random forest algorithm to evaluate whether Yelp measures can provide gains in nowcasting CBP measures before the release of official statistics. We are interested in the ability of Yelp to predict changes in overall CBP establishments and restaurants over and above the prediction power generated by lagged CBP data. Consequently, we begin our prediction task by regressing the change in CBP establishments on the two lags of changes in CBP establishments and zip code and year fixed effects. We then work with the residual quantity. Given the two lags of the CBP, our sample spans years 2012 to 2015 . We use a relatively simple first stage regression because we have a limited number of years, and because modest increases in complexity add little predictive power.

We assign the last year of our dataset (2015) to the test set, which represents 25 percent of our sample, and the rest to the training set. We then examine the ability of lagged and contemporaneous Yelp data to predict residual changes in CBP number of establishments in a given zip code and year. We include the following Yelp measures in the feature set: contemporaneous and lagged changes in, and absolute count of, the total number of open, opened, and closed businesses; aggregate review counts; and the average rating of businesses, all in terms of total numbers and broken down by lowest and highest price level, along with the year and total number of businesses that closed within one year. The number of trees in the forest is set to 300 , and the gains to increasing this number are marginal, yielding very similar results. Using an off-the-shelf random forest algorithm on models with limited feature sets, our analyses represent basic exercises to evaluate the usefulness of Yelp data, rather than to provide the most precise forecasts.

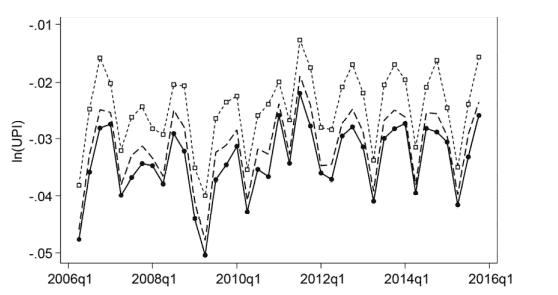

Table $9.4$ shows the prediction results. The first column shows our results for CBP establishments overall, while the second column shows the results for restaurants. We evaluate the predictive power of our model in two ways. Using the 2012-2014 data, we use an “out-of-bag” estimate of the prediction accuracy. We also use the 2015 data as a distinct testing sample.

The first row shows that the model has an $R^2$ of $0.29$ for predicting the 2014-2015 CBP openings for all businesses and an $R^2$ of $0.26$ for restaurants. Since the baseline data were already orthogonalized with respect to year, this implies that the Yelp-based model can explain between one-quarter and one-third of the variation across zip codes in the residualized CBP data.

The second row shows the out-of-bag estimates of $R^2$, based on the training data. In this case, the $R^2$ is $0.21$ for both data samples. The lower $R^2$ is not surprising given that out-of-bag estimates can often understate the predictive power of models. Nonetheless, it is useful to know that the fit of the model is not particular to anything about 2015.

There appears to be a wide range of predictive ability-but on average bounded within approximately half a standard deviation for businesses, with $8.0$ mean absolute error (MAE) and $3.9$ median absolute error, compared to a mean of $3.4$ and a standard deviation of 15.1. The mean and median absolute errors for restaurants are substantially smaller than for businesses, at $1.7$ and 1.1, respectively, but the mean and standard deviation for restaurant growth are also substantially lower than for businesses, at $0.54$ and $2.9$, respectively.

Yelp’s predictive power is far from perfect, but it does provide significant improvement in our knowledge about the path of local economies. Adding Yelp data can help marginally improve predictions compared to using only prior CBP data.

统计代写|经济统计代写Economic Statistics代考|Interactions with Area Attributes

Table $9.5$ shows results from regressions where changes in Yelp’s open business numbers are interacted with indicators for geographic characteristics. We use indicator variables that take on a value of one if the area has greater than the median level of population density, income, and education, and zero otherwise. Population density estimates are from the 2010 Census, while measures of median household income and percentage with a bachelor’s degree are from the 2015 American Community Survey five-year estimates. We present results just for total establishments and begin with the simple specification of regression (2) in table 9.2.

In this first regression, we find that all three interaction terms are positive and statistically significant. The interaction with high population density is $0.14$, while the interaction with high income is $0.30$, and the interaction with high education is $0.09$. Together, these interactions imply that the coeffi-cient on contemporaneous Yelp openings is $0.2$ in a low-density, low-income and low-education zip code, and $0.73$ in a high-density, high-income, and high-education zip code. This is an extremely large shift in coefficient size, perhaps best explained by far greater usage of Yelp in places with higher density, higher income, and higher education. If higher usage leads to more accuracy, this should cause the attenuation bias to fall and the estimated coefficient to increase.

In the second regression, we also add lagged Yelp openings. In this case,the baseline coefficient is negative, but again all three interactions are positive. Consequently, the estimated coefficient on lagged Yelp openings is $-0.1$ in low-density, low-income, and low-education locales, but $0.24$ in highdensity, high-income, and high-education areas. Again, decreased attenuation bias is one possible interpretation of this change. The third regression includes changes in Yelp closings and the number of Yelp reviews.

These interactions suggest that the predictive power of Yelp is likely to be higher in places with more density, education, and income. However, it is not true that adding interactions significantly improves the overall $R^2$. There is also little increase in $R^2$ from adding the lag of Yelp openings or the other Yelp variables, just as in table 9.2. While contemporaneous Yelp openings is the primary source of explanatory power, if policy makers want to use Yelp openings to predict changes in establishments, they should recognize that the mapping between contemporaneous Yelp openings and CBP openings is different in different places.

经济统计代考

统计代写|经济统计代写Economic Statistics代考|Forecasting with a Random Forest Algorithm

我们利用随机森林算法来评估 Yelp 措施是否可以在发布官方统计数据之前提供临近 CBP 措施的收益。我们感兴趣的是 Yelp 预测整体 CBP 机构和餐馆变化的能力超过滞后的 CBP 数据产生的预测能力。因此,我们通过对 CBP 机构的变化对 CBP 机构和邮政编码以及年份固定效应的两个滞后变化进行回归来开始我们的预测任务。然后我们处理剩余数量。鉴于 CBP 的两个滞后,我们的样本跨度为 2012 年至 2015 年。我们使用相对简单的第一阶段回归,因为我们的年数有限,而且复杂性的适度增加几乎没有增加预测能力。

我们将数据集的最后一年(2015 年)分配给测试集,占样本的 25%,其余分配给训练集。然后,我们检查滞后和同期的 Yelp 数据预测给定邮政编码和年份中 CBP 企业数量剩余变化的能力。我们在功能集中包括以下 Yelp 度量:同时和滞后的变化,以及打开、打开和关闭的业务总数的绝对计数;汇总评论数;以及企业的平均评级,全部以总数表示,并按最低和最高价格水平细分,以及年份和一年内关闭的企业总数。森林中的树木数量设置为 300 ,增加这个数量的收益很小,产生非常相似的结果。

桌子9.4显示预测结果。第一列显示了我们对 CBP 机构的整体结果,而第二列显示了餐馆的结果。我们以两种方式评估我们模型的预测能力。使用 2012-2014 年的数据,我们使用了预测准确度的“袋外”估计。我们还使用 2015 年的数据作为不同的测试样本。

第一行显示模型有一个R2的0.29用于预测 2014-2015 年 CBP 对所有企业的开放以及R2的0.26餐厅。由于基线数据已经相对于年份进行了正交化处理,这意味着基于 Yelp 的模型可以解释残留 CBP 数据中四分之一到三分之一的邮政编码差异。

第二行显示袋外估计R2, 基于训练数据。在这种情况下,R2是0.21对于两个数据样本。较低的R2考虑到袋外估计通常会低估模型的预测能力,这并不奇怪。尽管如此,了解该模型的拟合并非特定于 2015 年的任何事情还是很有用的。

似乎有广泛的预测能力——但平均而言,企业的预测能力在大约一半的标准偏差范围内,8.0平均绝对误差 (MAE) 和3.9中位数绝对误差,与平均值相比3.4标准偏差为 15.1。餐馆的平均和中位数绝对误差远小于企业,在1.7和 1.1,但餐厅增长的均值和标准差也大大低于企业,在0.54和2.9, 分别。

Yelp 的预测能力远非完美,但它确实大大提高了我们对当地经济发展路径的了解。与仅使用之前的 CBP 数据相比,添加 Yelp 数据有助于略微改进预测。

统计代写|经济统计代写Economic Statistics代考|Interactions with Area Attributes

桌子9.5显示回归结果,其中 Yelp 开放业务数量的变化与地理特征指标相互作用。我们使用指标变量,如果该地区的人口密度、收入和教育水平高于中位数水平,则其值为 1,否则为 0。人口密度估计来自 2010 年人口普查,而家庭收入中位数和拥有学士学位的百分比来自 2015 年美国社区调查的五年估计。我们只提供总机构的结果,并从表 9.2 中回归 (2) 的简单说明开始。

在第一个回归中,我们发现所有三个交互项都是正的并且具有统计显着性。与高人口密度的相互作用是0.14, 而与高收入的交互作用是0.30,与高等教育的互动是0.09. 总之,这些相互作用意味着同期 Yelp 开口的系数是0.2在低密度、低收入和低教育的邮政编码中,以及0.73在高密度、高收入和高教育的邮政编码中。这是系数大小的极大变化,最好的解释可能是 Yelp 在人口密度更高、收入更高和受教育程度更高的地方的使用率大大提高。如果更高的使用率导致更高的准确性,这应该会导致衰减偏差下降和估计系数增加。

在第二个回归中,我们还添加了滞后的 Yelp 开口。在这种情况下,基线系数为负,但所有三种交互作用均为正。因此,滞后的 Yelp 开口的估计系数是−0.1在低密度、低收入和低教育的地区,但0.24在高密度、高收入和高教育地区。同样,减少衰减偏差是对这种变化的一种可能解释。第三个回归包括 Yelp 关闭和 Yelp 评论数量的变化。

这些相互作用表明,Yelp 的预测能力在人口密度、教育和收入更高的地方可能更高。然而,添加交互显着改善整体效果并不是真的R2. 涨幅也不小R2从添加 Yelp 开口或其他 Yelp 变量的滞后,就像在表 9.2 中一样。虽然同时期的 Yelp 开放是解释力的主要来源,但如果政策制定者想使用 Yelp 开放来预测机构的变化,他们应该认识到同时期的 Yelp 开放和 CBP 开放之间的映射在不同的地方是不同的。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。