数学代写|信息论代写information theory代考|TELE9754

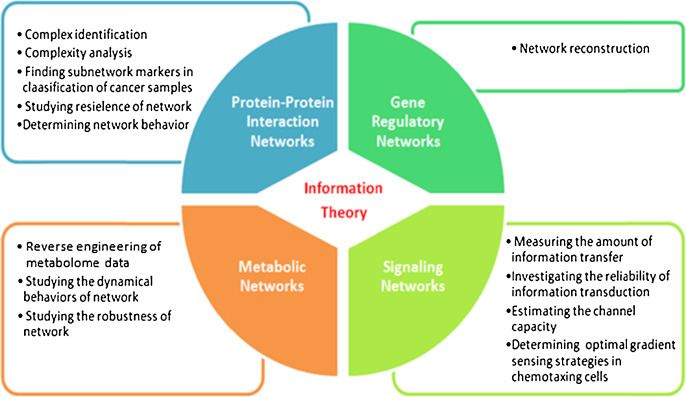

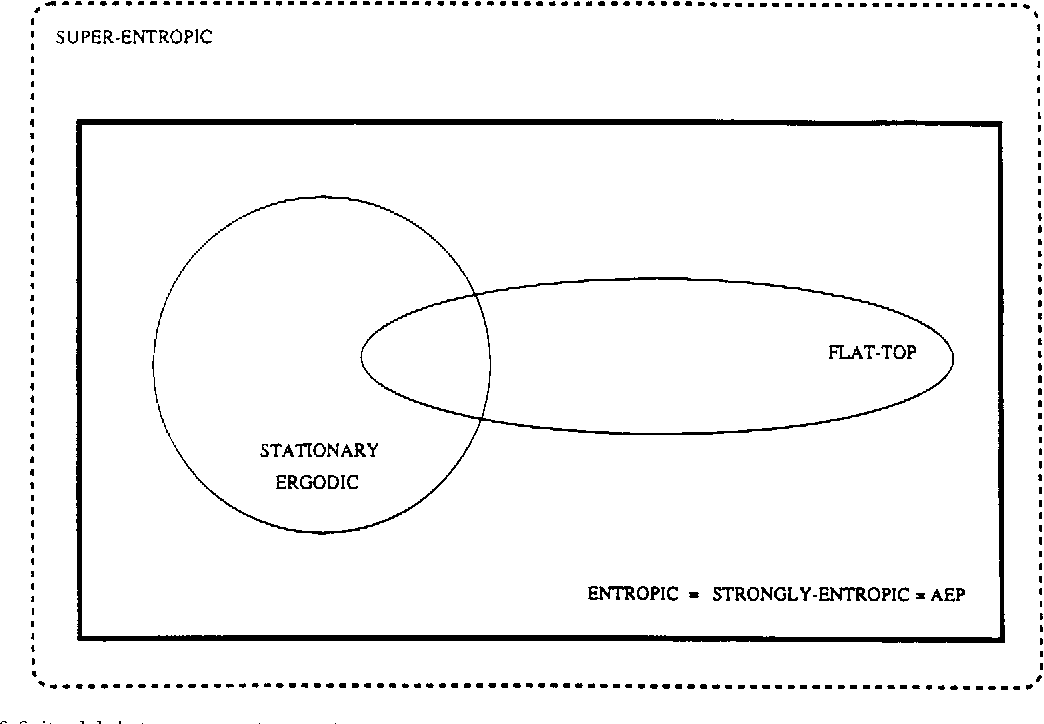

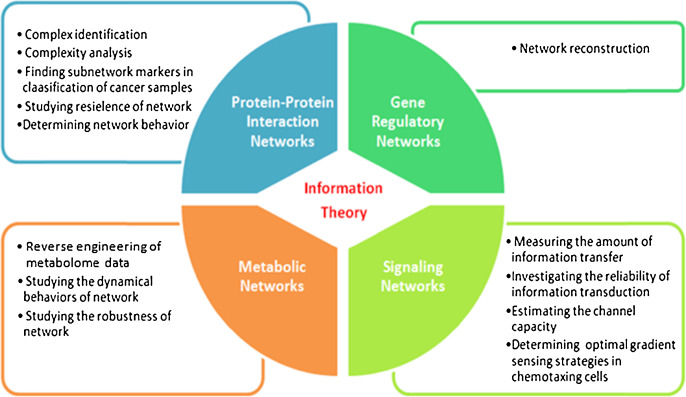

如果你也在 怎样代写信息论information theory 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。信息论information theory回答了通信理论中的两个基本问题:什么是最终的数据压缩(答案:熵$H$),什么是通信的最终传输速率(答案:信道容量$C$)。由于这个原因,一些人认为信息论是通信理论的一个子集。我们认为它远不止于此。

信息论information theory在统计物理学(热力学)、计算机科学(柯尔莫哥洛夫复杂性或算法复杂性)、统计推断(奥卡姆剃刀:“最简单的解释是最好的”)以及概率和统计学(最优假设检验和估计的误差指数)方面都做出了根本性的贡献。

statistics-lab™ 为您的留学生涯保驾护航 在代写信息论information theory方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写信息论information theory代写方面经验极为丰富,各种代写信息论information theory相关的作业也就用不着说。

数学代写|信息论代写information theory代考|$p_i$ is not a measure of information, and $-\log p_i$ is not measured in bits

In numerous textbooks on IT, as well as in popular science books one can find a description of $-\log p_i$ as a measure of information associated with the event $i$, hence, the SMI $=-\sum p_i \log p_i$ is interpreted as an average information. This erroneous misinterpretation of SMI is discussed further in Ben-Naim [1]. Here, we focus only on the single term $-\log p_i$, which is sometimes referred to as “self-information,” or the amount of information you get when you know that the event $i$ occurs. Some even assign to this the term a value in units of bits.

Here is how “self-information” is introduced in Wikipedia:

Definition: Claude Shannon’s definition of self-information was chosen to meet several axioms:

If two independent events are measured separately, the total amount of information is the sum of the self-information of the individual events…given an event $\mathrm{x}$ with probability $\mathrm{P}$, the information content is defined as follows:

$$

I_X(x)=-\log \left(P_X(x)\right)

$$

This whole quotation is not only untrue; it is misleading as well. First of all, Shannon never defined self-information, (neither in the original article, Shannon [2], nor in Shannon and Weaver [4], and, of course, this was never chosen to meet “several axioms.”

Shannon searched for a measure of information based on the whole distribution and not for a single event. His conditions (as in Shannon [2]: “it is reasonable to require of it the following properties”), were entirely different from the conditions or requirements stated in abovementioned quotation.

If an event with a probability 1 occurs, it is not surprising, it is very much expected, but it is not true that it yields no information. When I hear that an event $x$ with probability $100 \%$ occurred, I obtained the information that ” $x$ occurred”.

If an event with lower probability occurred, I am more surprised. This it is true. But it is not true that I obtained more information!

Suppose that we have four dice with different probability distributions, say

$$

\begin{aligned}

& \text { die } \mathrm{A}: p_1=1, p_2=p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{B}: p_1=0.9, p_2=0.1, p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{C}: p_1=0.8, p_2=0.2, p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{D}: p_1=0.7, p_2=0.3, p_3=p_4=p_5=p_6=0

\end{aligned}

$$

数学代写|信息论代写information theory代考|SMI is not a probability

In the beginning of this section we claimed that probability in general, may not be interpreted as SMI. It is true that in a special case when all $p_i=p_0=\frac{1}{n}$, then $-\log p_0$ may be interpreted as SMI. However, in general $-\log p_i$ is not SMI. From this particular example, one cannot conclude that SMI is, in general, probability.

The association of SMI with probability is probably due to Brillouin [6]. On page 120 of his book “Science and Information Theory,” we find:

The probability has a natural tendency to increase, and so does entropy. The exact relation is given by the famous Boltzmann-Planck formula:

$$

S=k \ln P

$$

It is difficult to overestimate the amount of misinformation that is packed in these two sentences. Probability has no natural tendency to increase! Probability does not behave as entropy! There is no exact relationship between entropy and probability! The quoted formula is not the Boltzmann-Planck formula.

The correct Boltzmann-Planck relationship for the entropy is $S=k \ln W$, where $W$ is the total number of accessible microstates in the system. This relationship is a special case SMI for the case when all the events have equal probabilities. As we showed above, in general, probability is not SMI (except when $p_i=p_0=\frac{1}{n}$ ).

Here, we claim that entropy (being a special case of SMI) is never related to probability by an equation $S=k \ln P$.

The simplest reason for my claim is that probability is a positive number between 0 to 1 . Therefore, $\ln P$ varies between minus infinity to 0 . Entropy, as well as SMI is always a positive number greater or equal to 0. More on this in Ben-Naim [7].

信息论代写

数学代写|信息论代写information theory代考|$p_i$ is not a measure of information, and $-\log p_i$ is not measured in bits

在许多关于IT的教科书以及通俗科学书籍中,人们可以找到$-\log p_i$作为与事件$i$相关的信息度量的描述,因此,SMI $=-\sum p_i \log p_i$被解释为平均信息。Ben-Naim[1]进一步讨论了这种对重度精神分裂症的错误误解。在这里,我们只关注单个术语$-\log p_i$,它有时被称为“自我信息”,或者当您知道事件$i$发生时所获得的信息量。有些人甚至给这个术语赋以比特为单位的值。

维基百科是这样介绍“自我信息”的:

定义:选择克劳德·香农对自我信息的定义来满足几个公理:

如果分别测量两个独立事件,则信息总量为单个事件的自信息之和,给定一个概率为$\mathrm{P}$的事件$\mathrm{x}$,则信息内容定义如下:

$$

I_X(x)=-\log \left(P_X(x)\right)

$$

这整句话不仅不真实;这也具有误导性。首先,香农从未定义过自我信息,(无论是在原文香农[2]中,还是在香农和韦弗[4]中),当然,这也从未被选择来满足“几个公理”。

香农寻找的是一种基于整个分布而不是单一事件的信息度量。他的条件(如香农[2]:“合理地要求它具有下列性质”)与上述引文中所述的条件或要求完全不同。

如果一个概率为1的事件发生了,这并不奇怪,它是非常值得期待的,但它不产生任何信息并不是真的。当我听到发生了一个概率为$100 \%$的事件$x$时,我得到的信息是“$x$发生了”。

如果发生概率较低的事件,我会更惊讶。这是真的。但我获得更多的信息是不真实的!

假设我们有四个概率分布不同的骰子

$$

\begin{aligned}

& \text { die } \mathrm{A}: p_1=1, p_2=p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{B}: p_1=0.9, p_2=0.1, p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{C}: p_1=0.8, p_2=0.2, p_3=p_4=p_5=p_6=0 \

& \text { die } \mathrm{D}: p_1=0.7, p_2=0.3, p_3=p_4=p_5=p_6=0

\end{aligned}

$$

数学代写|信息论代写information theory代考|SMI is not a probability

在本节的开始,我们声称概率一般不能被解释为SMI。的确,在特殊情况下,当所有$p_i=p_0=\frac{1}{n}$,那么$-\log p_0$都可以被解释为SMI。然而,一般来说$-\log p_i$不是重度精神分裂症。从这个特殊的例子中,我们不能得出SMI通常是概率性的结论。

SMI与概率的关联可能是由于布里渊[6]。在他的书《科学与信息论》的第120页,我们发现:

概率有增加的自然趋势,熵也是如此。精确的关系由著名的玻尔兹曼-普朗克公式给出:

$$

S=k \ln P

$$

很难高估这两句话中包含的错误信息的数量。概率没有自然增加的趋势!概率不代表熵!熵和概率之间没有确切的关系!引用的公式不是玻尔兹曼-普朗克公式。

正确的玻尔兹曼-普朗克熵的关系是$S=k \ln W$,其中$W$是系统中可达到的微观状态的总数。当所有事件的概率相等时,这种关系是一种特殊情况SMI。如上所示,一般来说,概率不是SMI(除非$p_i=p_0=\frac{1}{n}$)。

在这里,我们声称熵(作为SMI的一个特例)永远不会通过一个方程$S=k \ln P$与概率相关。

我的说法最简单的原因是概率是0到1之间的正数。因此,$\ln P$在负无穷到0之间变化。熵和SMI总是一个大于或等于0的正数。Ben-Naim[7]对此有更详细的介绍。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。