数学代写|数值分析代写numerical analysis代考|Inequality Constrained Optimization

如果你也在 怎样代写数值分析numerical analysis这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

数值分析是数学的一个分支,使用数字近似法解决连续问题。它涉及到设计能给出近似但精确的数字解决方案的方法,这在精确解决方案不可能或计算成本过高的情况下很有用。

statistics-lab™ 为您的留学生涯保驾护航 在代写数值分析numerical analysis方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写数值分析numerical analysis代写方面经验极为丰富,各种代写数值分析numerical analysis相关的作业也就用不着说。

我们提供的数值分析numerical analysis及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

数学代写|数值分析代写numerical analysis代考|Inequality Constrained Optimization

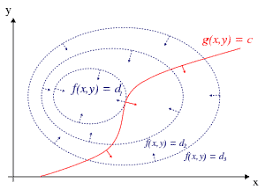

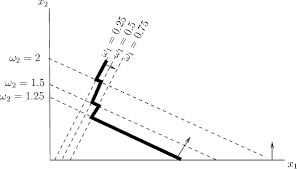

Inequality constrained optimization is more complex, both in theory and practice. The theorem giving necessary conditions for inequality constrained optimization was only discovered in the middle of the twentieth century, while Lagrange used Lagrange multipliers in his Mécanique Analytique 151. The necessary conditions for inequality constrained optimization are called Kuhn-Tucker or Karush-Kuhn-Tucker conditions. The first journal publication with these conditions was a paper by Kuhn and Tucker in 149, although the essence of these conditions was contained in an unpublished Master’s thesis of Karush 139.

The work of Kuhn and Tucker was intended to build on the work of G. Dantzig and others [69] on linear programming:

$\min x c^T x \quad$ (8.6.7) subject to $$ A \boldsymbol{x} \geq \boldsymbol{b} $$ where ” $\boldsymbol{a} \geq \boldsymbol{b}$ ” is understood to mean ” $a_i \geq b_i$ for all $i$ “. It was Dantzig who created the simplex algorithm in 1946 [69], being the first general-purpose and efficient algorithm for solving linear programs (8.6.7, 8.6.8). The simplex method can be considered an example of an active set method as it tracks which of the inequalities $(A x)_i \geq b_i$ is actually an equality as it updates the candidate optimizer $\boldsymbol{x}$. Since then there has been a great deal of work on alternative methods, most notably interior point methods that typically minimize a sequence of penalized problems such as $$ c^T \boldsymbol{x}-\alpha \sum{i=1}^m \ln \left((A x)_i-b_i\right)

$$

where $\alpha>0$ is a parameter that is reduced to zero in the limit. The first published interior point method was due to Karmarkar 138. Another approach is the ellipsoidal method of Khachiyan 120, which at each step $k$ minimizes $\boldsymbol{c}^T \boldsymbol{x}$ over $\boldsymbol{x}$ lying inside an ellipsoid centered at $\boldsymbol{x}_k$ that is guaranteed to be inside the feasible set ${\boldsymbol{x} \mid A x \geq \boldsymbol{b}}$. Khachiyan’s ellipsoidal method built on previous ideas of N.Z. Shor but was the first guaranteed polynomial time algorithm for linear programming. Karmarkar’s algorithm also guaranteed polynomial time, but was much faster in practice than Khachiyan’s method and the first algorithm to have a better time than the simplex method on average.

数学代写|数值分析代写numerical analysis代考|Proving the Karush–Kuhn–Tucker Conditions

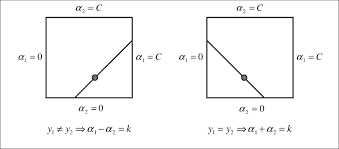

To prove the Karush-Kuhn-Tucker conditions we need a constraint qualification to ensure that

$$

T_{\Omega}(\boldsymbol{x})=\left{\boldsymbol{d} \mid \nabla g_i(\boldsymbol{x})^T \boldsymbol{d}=0 \text { for all } i \in \mathcal{E},\right.

$$

(8.6.9) $\nabla g_i(\boldsymbol{x})^T \boldsymbol{d} \geq 0$ for all $i \in \mathcal{I}$ where $\left.g_i(\boldsymbol{x})=0\right}=C_{\Omega}(\boldsymbol{x})$.

A constraint $g_i(\boldsymbol{x}) \geq 0$ is called active at $\boldsymbol{x}$ if $g_i(\boldsymbol{x})=0$ and inactive at $\boldsymbol{x}$ if $g_i(\boldsymbol{x})>0$. Inactive inequality constraints at $x$ do not affect the shape of the feasible set $\Omega$ near to $\boldsymbol{x}$. We designate the set of active constraints by

$$

\mathcal{A}(\boldsymbol{x})=\left{i \mid i \in \mathcal{E} \cup \mathcal{I} \text { and } g_i(\boldsymbol{x})=0\right} .

$$

The equivalence (8.6.9) holds under a number of constraint qualifications, the most used of which is the Linear Independence Constraint Qualification (LICQ) for inequality constrained optimization:

(8.6.11) $\quad\left{\nabla g_i(\boldsymbol{x}) \mid i \in \mathcal{A}(\boldsymbol{x})\right}$ is a linearly independent set.

Weaker constraint qualifications that guarantee (8.6.9) include the MangasarianFromowitz constraint qualification (MFCQ):

$\left{\nabla g_i(\boldsymbol{x}) \mid i \in \mathcal{E}\right}$ is a linearly independent set, and there is $\boldsymbol{d}$ where $\nabla g_i(\boldsymbol{x})^T \boldsymbol{d}=0$ for all $i \in \mathcal{E}$, and

$$

\nabla g_i(\boldsymbol{x})^T \boldsymbol{d}>0 \text { for all } i \in \mathcal{I} \cap \mathcal{A}(\boldsymbol{x}) .

$$

With a suitable constraint qualification, we can prove the existence of Lagrange multipliers satisfying the Karush-Kuhn-Tucker conditions.

数值分析代考

数学代写|数值分析代写numerical analysis代考|Inequality Constrained Optimization

不等式约束优化在理论上和实践上都更为复杂。给出不等式约束优化必要条件的定理直到二十世纪中叶 才被发现,而拉格朗日在他的《力学分析》151中使用了拉格朗日乘数。不等式约束优化的必要条件称为 Kuhn-Tucker 或 Karush-Kuhn-Tucker 条件。第一篇具有这些条件的期刊出版物是 Kuhn 和 Tucker 在 149发表的一篇论文,尽管这些条件的本质包含在 Karush 139末发表的硕士论文中。

Kuhn 和 Tucker 的工作旨在建立在 G. Dantzig 和其他人 [69] 关于线性规划的工作之上: $\min x c^T x \quad(8.6 .7)$ 受制于

$$

A \boldsymbol{x} \geq \boldsymbol{b}

$$

于求解线性规划的通用且高效的算法 (8.6.7,8.6.8)。单纯形法可以被认为是活动集方法的一个例子,因为 它跟踪哪些不等式 $(A x)_i \geq b_i$ 实际上是一个等式,因为它更新了候选优化器 $\boldsymbol{x}$. 从那时起,就替代方法 进行了大量工作,最著名的是内点方法,它通常最大限度地减少一系列惩恩问题,例如

$$

c^T \boldsymbol{x}-\alpha \sum i=1^m \ln \left((A x)_i-b_i\right)

$$

在哪里 $\alpha>0$ 是一个参数,在极限中减少到零。第一个发布的内点方法是由于 Karmarkar 138。另一种 方法是 Khachiyan 120的椭圆方法,它在每一步 $k$ 最小化 $\boldsymbol{c}^T \boldsymbol{x}$ 超过 $\boldsymbol{x}$ 位于以 为中心的椭圆体内 $\boldsymbol{x}_k$ 保证在 可行集内 $\boldsymbol{x} \mid A \boldsymbol{x} \geq \boldsymbol{b}$. Khachiyan 的椭圆体方法建立在 NZ Shor 之前的思想之上,但却是线性规划的第 一个保证多项式时间算法。Karmarkar 的算法也保证多项式时间,但在实践中比 Khachiyan 的方法快得 多,并且是第一个平均时间比单纯形法有更好时间的算法。

数学代写|数值分析代写numerical analysis代考|Proving the Karush–Kuhn–Tucker Conditions

为了证明 Karush-Kuhn-Tucker 条件,我们需要一个约束条件来确保

$$

T_{\Omega}(\boldsymbol{x})=\left{\boldsymbol{d} \mid \nabla g_i(\boldsymbol{x})^T \boldsymbol{d}=0 \text { for all } i \在 \mathcal{E} 中,\对。

$$

(8.6.9) $\nabla g_i(\boldsymbol{x})^T \boldsymbol{d} \geq 0$ 对于所有 $i \in \mathcal{I}$ 其中 $\left.g_i(\boldsymbol{x })=0\right}=C_{\Omega}(\boldsymbol{x})$。

如果 $g_i(\boldsymbol{x})=0$,约束 $g_i(\boldsymbol{x}) \geq 0$ 被称为在 $\boldsymbol{x}$ 处于活动状态,如果 $\boldsymbol{x}$ 处于非活动状态,则$g_i(\boldsymbol{x})>0$。 $x$ 处的非活动不等式约束不会影响 $\boldsymbol{x}$ 附近可行集 $\Omega$ 的形状。我们通过以下方式指定一组活动约束

$$

\mathcal{A}(\boldsymbol{x})=\left{i \mid i \in \mathcal{E} \cup \mathcal{I} \text { and } g_i(\boldsymbol{x})=0\正确的} 。

$$

等价 (8.6.9) 在许多约束条件下成立,其中最常用的是用于不等式约束优化的线性独立约束条件 (LICQ):

(8.6.11) $\quad\left{\nabla g_i(\boldsymbol{x}) \mid i \in \mathcal{A}(\boldsymbol{x})\right}$ 是线性独立集。

保证 (8.6.9) 的较弱约束条件包括 MangasarianFromowitz 约束条件 (MFCQ):

$\left{\nabla g_i(\boldsymbol{x}) \mid i \in \mathcal{E}\right}$ 是线性独立集,有 $\boldsymbol{d}$ 其中 $\nabla g_i( \boldsymbol{x})^T \boldsymbol{d}=0$ 对于所有 $i \in \mathcal{E}$,并且

$$

\nabla g_i(\boldsymbol{x})^T \boldsymbol{d}>0 \text { for all } i \in \mathcal{I} \cap \mathcal{A}(\boldsymbol{x}) 。

$$

通过适当的约束条件,我们可以证明满足 Karush-Kuhn-Tucker 条件的拉格朗日乘子的存在性

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。