统计代写|统计模型作业代写Statistical Modelling代考|Small Sample Refinement: Saddlepoint Approximations

如果你也在 怎样代写统计模型Statistical Modelling这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

统计建模是使用数学模型和统计假设来生成样本数据并对现实世界进行预测。统计模型是一组实验的所有可能结果的概率分布的集合。

statistics-lab™ 为您的留学生涯保驾护航 在代写统计模型Statistical Modelling方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写统计模型Statistical Modelling代写方面经验极为丰富,各种代写统计模型Statistical Modelling相关的作业也就用不着说。

我们提供的统计模型Statistical Modelling及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|统计模型作业代写Statistical Modelling代考|Small Sample Refinement: Saddlepoint Approximations

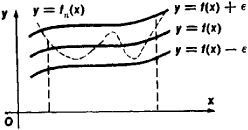

Saddlepoint approximation is a technique for refined approximation of densities and distribution functions when the normal (or $\chi^{2}$ ) approximation is too crude. The method is typically used on distributions for

- Sums of random variables.

- ML estimators.

- Likelihood ratio test statistics,

and for approximating structure functions. These approximations often have surprisingly small errors, and in some remarkable cases they yield exact results. We confine ourselves to the basics, and consider only density approximation for canonical statistics $t$ (which involves the structure function $g(t)$ ), and for the MLE in any parameterization of the exponential family.

The saddlepoint approximation for probability densities (continuous distribution case) is due to Daniels (1954). Approximations for distribution functions, being of particular interest for test statistics (for example the so-called Lugannani-Rice formula for the signed log-likelihood ratio), is a more complicated topic, because it will require approximation of integrals of densities instead of just densities, see for example Jensen (1995).

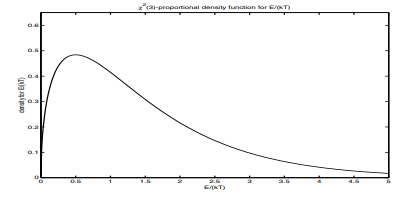

Suppose we have a regular exponential family, with canonical statistic $\boldsymbol{t}$ (no index $n$ here) and canonical parameter $\theta$. If the family is not regular, we restrict $\boldsymbol{\theta}$ to the interior of $\Theta$. Usually $t=t(y)$ has some sort of a sum form, even though the number of terms may be small. We shall derive an approximation for the density $f\left(t ; \theta_{0}\right)$ of $t$, for some specified $\theta=\theta_{0}$. One reason for wanting such an approximation in a given exponential family is the presence of the structure function $g(t)$ in $f\left(t ; \theta_{0}\right)$, which is the factor, often complicated, by which $f\left(t ; \boldsymbol{\theta}{0}\right)$ differs from $f\left(\boldsymbol{y} ; \boldsymbol{\theta}{0}\right)$. Another reason is that we might want the distribution of the ML estimator, and $t=\hat{\boldsymbol{\mu}}_{t}$ is one such MLE.

统计代写|统计模型作业代写Statistical Modelling代考|Extensions and further refinements.

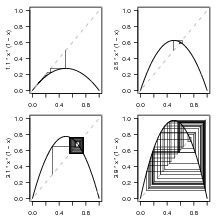

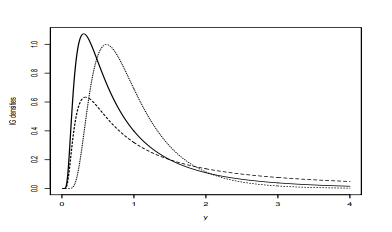

The same technique can at least in principle be used outside exponential families to approximate a density $f(t)$. The idea is to embed $f(t)$ in an exponential family by exponential tilting, see Example $2.12$ with $f(t)$ in the role of its $f_{0}(y)$, For practical use, $f$ must have an explicit and manageable Laplace transform, since the norming constant $C(\boldsymbol{\theta})$ will be the Laplace transform of the density $f$, cf. (3.9).

For iid samples of size $n$ one might guess the error is expressed by a factor of magnitude $1+O(1 / \sqrt{n})$. It is in fact a magnitude better, $1+O(1 / n)$, and this holds uniformly on compact subsets of $\Theta$. The error factor can be further refined by using a more elaborate Edgeworth expansion instead of the simple normal density in the second line of (4.6). An Edgeworth expansion is typically excellent in the centre of the distribution, where it would be used here (for $\boldsymbol{\theta}=\hat{\theta}(t))$. On the other hand, it can be terribly bad in the tails and is generally not advisable for a direct approximation of $f\left(t ; \boldsymbol{\theta}_{0}\right)$. See for example Jensen (1995, Ch. 2) for details and proofs. Such a refinement of the saddlepoint approximation was used by Martin-Löf to prove Boltzmann’s theorem, see Chapter $6 .$

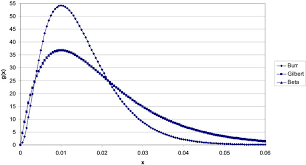

Further refinement is possible, at least in principle, through multiplication by a norming factor such that the density approximation becomes a proper probability density. Note, this factor will typically depend on $\theta_{0}$. Even if the relative approximation error is often remarkably small, it generally depends on the argument $\boldsymbol{t}$. For the distribution of the sample mean it is constant only for three univariate densities of continuous distributions: the normal density, the gamma density, and the inverse Gaussian density (Exercise 4.6). The representation is exact for the normal, see Exercise 4.4, and the inverse Gaussian. For the gamma density the error factor is close to 1, representing the Stirling’s formula approximation of $n$ ! (Section B.2.2). Correction by a norming factor, as mentioned in the previous item, would of course eliminate such a constant relative error, but be pointless in this particular case.

$\Delta$

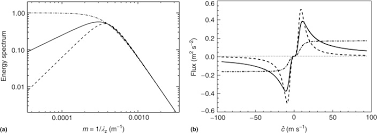

统计代写|统计模型作业代写Statistical Modelling代考|Saddlepoint approximation for the MLE

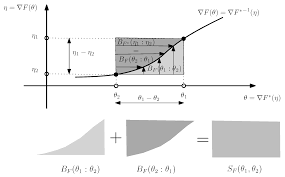

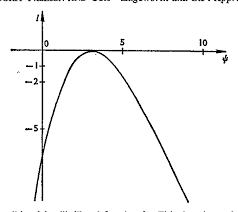

The saddlepoint approximation for the density $f\left(\hat{\psi} ; \psi_{0}\right)$ of the $M L$ estimator $\hat{\psi}=\hat{\psi}(t)$ in any smooth parameterization of a regular exponential family is

$$

f\left(\hat{\psi} ; \psi_{0}\right) \approx \frac{\sqrt{\operatorname{det} I(\hat{\psi})}}{(2 \pi)^{k / 2}} \frac{L\left(\psi_{0}\right)}{L(\hat{\psi})}

$$

Here $I(\hat{\psi})$ is the Fisher information for the chosen parameter $\psi$, with inserted $\hat{\psi}$.

Proof We transform from the density for $t=\hat{\mu}{t}$ to the density for $\hat{\psi}(t)$. To achieve this we only have to see the effect of a variable transformation on 4.2 Small Sample Refinement: Saddlepoint Approximations 73 the density. When we replace the variable $\hat{\mu}$, by $\hat{\psi}$, we must also multiply by the Jacobian determinant for the transformation that has Jacobian matrix $\left(\frac{\partial \hat{\mu}{t}}{\partial \bar{\phi}}\right)$. However, this is also precisely what is needed to change the square root of $\operatorname{det} I\left(\mu_{t}\right)=\operatorname{det} V_{t}^{-1}=1 / \operatorname{det} V_{t}$ to take account of the reparameterization, see the Reparameterization lemma, Proposition 3.14. Hence the form of formula (4.9) is invariant under reparameterizations.

Proposition $4.7$ works even much more generally, as shown by BarndorffNielsen and others, and the formula is usually named Barndorff-Nielsen’s formula, or the $p^{*}$ ( ‘ $p$-star’) formula, see Reid (1988) and Barndorff-Nielsen and Cox (1994). Pawitan (2001, Sec. 9.8) refers to it as the ‘magical formula’. The formula holds also after conditioning on distribution-constant (= ancillary) statistics (see Proposition $7.5$ and Remark 7.6), and it holds exactly in transformation models, given the ancillary configuration statistic. It is more complicated to derive outside the exponential families, however, because we cannot then start from (4.7) with the canonical parameter $\boldsymbol{\theta}$ as the parameter of interest.

By analogy with the third item of Remark 4.6 about approximation (4.7), we may here refine (4.9) by replacing the approximate normalization constant $1 / \sqrt{2 \pi}$ by the exact one, that makes the density integrate to 1 .

统计模型代考

统计代写|统计模型作业代写Statistical Modelling代考|Small Sample Refinement: Saddlepoint Approximations

鞍点近似是一种在正态(或χ2) 近似太粗略。该方法通常用于分布

- 随机变量的总和。

- 机器学习估计器。

- 似然比检验统计量,

用于近似结构函数。这些近似值通常具有令人惊讶的小误差,并且在某些非凡的情况下,它们会产生精确的结果。我们仅限于基础知识,仅考虑规范统计的密度近似吨(其中涉及结构函数G(吨)),对于指数族的任何参数化中的 MLE。

概率密度的鞍点近似(连续分布情况)归功于 Daniels (1954)。分布函数的近似值,对检验统计特别感兴趣(例如所谓的有符号对数似然比的 Lugannani-Rice 公式),是一个更复杂的主题,因为它需要密度积分的近似值,而不仅仅是密度,例如参见 Jensen (1995)。

假设我们有一个正则指数族,具有典型统计量吨(无索引n这里)和规范参数θ. 如果家庭不规律,我们限制θ到内部θ. 通常吨=吨(是)具有某种求和形式,即使项的数量可能很少。我们将推导出密度的近似值F(吨;θ0)的吨, 对于一些指定的θ=θ0. 在给定的指数族中需要这种近似的一个原因是结构函数的存在G(吨)在F(吨;θ0),这是一个因素,通常很复杂,通过它F(吨;θ0)不同于F(是;θ0). 另一个原因是我们可能想要 ML 估计器的分布,并且吨=μ^吨就是这样一种 MLE。

统计代写|统计模型作业代写Statistical Modelling代考|Extensions and further refinements.

至少原则上可以在指数族之外使用相同的技术来近似密度F(吨). 这个想法是嵌入F(吨)通过指数倾斜在指数族中,请参见示例2.12和F(吨)在其作用F0(是), 为了实际使用,F必须有一个显式且可管理的拉普拉斯变换,因为规范常数C(θ)将是密度的拉普拉斯变换F,参见。(3.9)。

对于大小的 iid 样本n有人可能会猜测误差是由一个数量级表示的1+这(1/n). 它实际上是一个数量级更好,1+这(1/n), 这在θ. 误差因子可以通过使用更精细的 Edgeworth 展开而不是 (4.6) 第二行中的简单正态密度来进一步细化。Edgeworth 展开通常在分布的中心非常出色,这里将使用它(例如θ=θ^(吨)). 另一方面,尾部可能非常糟糕,通常不建议直接近似F(吨;θ0). 有关详细信息和证明,请参见 Jensen (1995, Ch. 2)。Martin-Löf 使用鞍点近似的这种改进来证明玻尔兹曼定理,参见第6.

至少在原则上,进一步的细化是可能的,通过乘以一个规范因子,使得密度近似成为一个适当的概率密度。请注意,此因素通常取决于θ0. 即使相对近似误差通常非常小,它通常也取决于参数吨. 对于样本均值的分布,它仅对连续分布的三个单变量密度是恒定的:正态密度、伽马密度和逆高斯密度(练习 4.6)。表示法是精确的,见习题 4.4,和逆高斯。对于伽马密度,误差因子接近 1,表示斯特林公式近似n!(第 B.2.2 节)。如上一项所述,通过规范因子进行校正当然会消除这种恒定的相对误差,但在这种特殊情况下毫无意义。

Δ

统计代写|统计模型作业代写Statistical Modelling代考|Saddlepoint approximation for the MLE

密度的鞍点近似F(ψ^;ψ0)的米大号估计器ψ^=ψ^(吨)在正则指数族的任何平滑参数化中

F(ψ^;ψ0)≈这一世(ψ^)(2圆周率)ķ/2大号(ψ0)大号(ψ^)

这里一世(ψ^)是所选参数的 Fisher 信息ψ, 插入ψ^.

证明 我们从密度变换为吨=μ^吨密度为ψ^(吨). 为了实现这一点,我们只需要查看变量变换对 4.2 小样本改进:鞍点近似 73 密度的影响。当我们替换变量时μ^, 经过ψ^,我们还必须乘以雅可比行列式来进行具有雅可比矩阵的变换(∂μ^吨∂φ¯). 然而,这也正是改变平方根所需要的这一世(μ吨)=这在吨−1=1/这在吨要考虑重新参数化,请参见重新参数化引理,命题 3.14。因此,公式(4.9)的形式在重新参数化下是不变的。

主张4.7正如 BarndorffNielsen 和其他人所展示的那样,它的工作原理更加普遍,并且该公式通常被命名为 Barndorff-Nielsen 公式,或者p∗ ( ‘ p-star’) 公式,参见 Reid (1988) 和 Barndorff-Nielsen 和 Cox (1994)。Pawitan (2001, Sec. 9.8) 将其称为“神奇公式”。该公式在以分布常数(=辅助)统计为条件后也成立(见命题7.5和备注 7.6),并且在给定辅助配置统计的情况下,它完全适用于转换模型。然而,在指数族之外推导更复杂,因为我们不能从 (4.7) 开始使用规范参数θ作为感兴趣的参数。

类推 4.6 中关于近似 (4.7) 的第三项,我们可以在这里通过替换近似归一化常数来细化 (4.9)1/2圆周率由确切的一个,这使得密度积分为 1 。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。