机器学习代写|自然语言处理代写NLP代考|JAPANESE GRAMMAR

如果你也在 怎样代写自然语言处理NLP这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

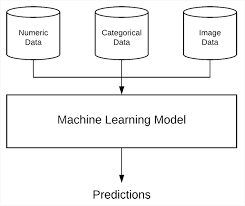

自然语言处理(NLP)是指计算机程序理解人类语言的能力,因为它是口头和书面的,被称为自然语言。它是人工智能(AI)的一个组成部分。

statistics-lab™ 为您的留学生涯保驾护航 在代写自然语言处理NLP方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写自然语言处理NLP代写方面经验极为丰富,各种代写自然语言处理NLP相关的作业也就用不着说。

我们提供的自然语言处理NLP及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

机器学习代写|自然语言处理代写NLP代考|Japanese Postpositions

Instead of prepositions, Japanese uses postpositions (which can occur multiple times in a sentence). Here are some common Japanese postpositions that are written in Romanji:

- Ka (a marker for a question)

- Wa (the topic of a sentence)

- Ga (the subject of a sentence)

- $\mathrm{O}$ (direct object)

- To (can mean “for” and “and”)

- Ni (physical motion toward something)

- E (toward something)

The particle $k a$ at the end of a sentence in Japanese indicates a question. A simple example of $k a$ is the Romanji sentence Nan desu ka, which means “What is it?”

An example of wa is the following sentence: Watashi wa Nihon jin desu, which means “As for me, I’m Japanese.” By contrast, the sentence Watashi ga Nihon jin desu, which means “It is I (not somebody else) who is Japanese.”

As you can see, Japanese makes a distinction between the topic of a sentence (with $w a$ ) versus the subject of a sentence (with $g a$ ). A Japanese sentence can contain both particles $w a$ and $g a$, with the following twist: if a negative fact is expressed about the noun that precedes $g a$, then $g a$ is replaced with $w a$ and the main verb is written in the negative form. For example, the Romanji sentence “I still have not studied Kanji” is translated into Hiragana as follows:

Watashi wa kanji wa mada benkyou shite imasen.

机器学习代写|自然语言处理代写NLP代考|Ambiguity in Japanese Sentences

Since Japanese does not pluralize nouns, the same word is used for singular as well as plural, which requires contextual information to determine the exact meaning of a Japanese sentence. As a simple illustration, which is discussed

in more detail later in this chapter under the topic of tokenization, here is a Japanese sentence written in Romanji, followed by Hiragana and Kanji (the second and third sentences are from Google Translate):

Watashi wa tomodachi ni hon o agemashita

$\mathrm{~ क た L ~ क ~ と も た ゙ ち ~ に ~ ほ h ~ お}$

友迲に本をかげた

The preceding sentence can mean any of the following, and the correct interpretation depends on the context of a conversation:

- I gave a book to a friend.

- I gave a book to friends.

- I gave books to a friend.

- I gave books to friends.

Moreover, the context for the words “friend” and “friends” in the Japanese sentence is also ambiguous: they do not indicate whose friends (mine, yours, his, or hers). In fact, the following Japanese sentence is also grammatically correct and ambiguous:

Tomodachi ni hon o agemashita

The preceding sentence does not specify who gave a book (or books) to a friend (or friends), but its context will be clear during a conversation. Incidentally, Japanese people often omit the subject pronoun (unless the sentence becomes ambiguous), so it’s more common to see the second sentence (i.e., without Watashi wa) instead of the first Romanji sentence.

Contrast the earlier Japanese sentence with its counterpart in the romance languages Italian, Spanish, French, Portuguese, and German (some accent marks are missing for some words):

- Italian: Ho dato un libro a mio amico.

- Spanish: [Yo] Le di un libro a mi amigo.

- Portuguese: Eu dei um livro para meu amigo.

- French: Jai donne un livre au mon ami.

- German. Ich habe ein Buch dem Freund gegeben.

Notice that the Italian and French sentences use a compound verb whose two parts are consecutive (adjacent), whereas German uses a compound verb in which the second part (the past participle) is at the end of the sentence. However, the Spanish and Portuguese sentences use the simple past (the preterit) form of the verb “to give.”

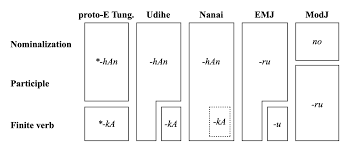

机器学习代写|自然语言处理代写NLP代考|Japanese Nominalization

Nominalizers convert verbs (or even entire sentences) into a noun. Nominalizers resemble a “that” clause in English, and they are useful when speaking about an action as a noun. Japanese has two nominalizers: no and koto ga.

The nominalizer $O$ (no) is required with verbs of perception, such as 見 (to see) and 閆 $<$ (to listen). For example, the following sentence mean “I love listening to music”, written in Romanji in the first sentence, followed by a second sentence that contains a mixture of Kanji and Hiragana:

Watashi wa ongaku o kiku no ga daisuki desu

The next three sentences all mean “He loves reading a newspaper,” written in Romanji and then Hiragana and Kanji:

Kare wa shimbun o yomu no ga daisuki desu

$\mathrm{~ カ ั 丸 は 新 間 を 読}$

彼才 $\mathrm{LmS} ん \mathrm{~ क 読 む の か}$

The koto ga nominalizer, which is the other Japanese nominalizer, is used sentences of the form “have you ever …” For example, the following sentence means “Have you (ever) been in Japan?”

日本にレ) $=<\neq \approx-\frac{5}{2} \Rightarrow$

NLP代考

机器学习代写|自然语言处理代写NLP代考|Japanese Postpositions

日语不使用介词,而是使用后置词(可以在一个句子中出现多次)。以下是一些用罗马字书写的常见日语后置词:

- Ka(问题的标记)

- Wa(一个句子的主题)

- 嘎(句子的主语)

- ○(直接宾语)

- To(可以表示“for”和“and”)

- Ni(朝向某物的物理运动)

- E(朝向某物)

粒子ķ一个日语句末表示疑问。一个简单的例子ķ一个是罗马字句 Nan desu ka,意思是“它是什么?”

以下句子是 wa 的一个示例:Watashi wa Nihon jin desu,意思是“至于我,我是日本人”。相比之下,Watashi ga Nihon jin desu 这句话的意思是“我(而不是其他人)是日本人”。

如您所见,日语区分句子的主题(与在一个) 与句子的主语 (withG一个)。一个日语句子可以包含两个粒子在一个和G一个,有以下扭曲:如果对前面的名词表达了否定事实G一个, 然后G一个被替换为在一个主要动词写成否定形式。例如,罗马字句子“我还没有学过汉字”被翻译成平假名如下:

Watashi wa kanji wa mada benkyou shite imasen。

机器学习代写|自然语言处理代写NLP代考|Ambiguity in Japanese Sentences

由于日语不复数名词,因此单数和复数都使用同一个词,这需要上下文信息来确定日语句子的确切含义。作为一个简单的说明,讨论

在本章后面的标记化主题下更详细,这里是用罗马字写的日语句子,后面是平假名和汉字(第二和第三句来自谷歌翻译):

Watashi wa tomodachi ni hon oagemashita

कたकともだちにほお ķ稻田大号 ķ 什么时候和稻田゙血液 至 何H 哦

前面的

句子可以表示以下任何一种,正确的解释取决于对话的上下文:

- 我给了朋友一本书。

- 我给了朋友一本书。

- 我把书送给了一个朋友。

- 我把书送给了朋友。

此外,日语句子中“朋友”和“朋友”这两个词的上下文也是模棱两可的:它们不表示谁的朋友(我的、你的、他的或她的)。事实上,下面的日语句子在语法上也是正确的和模棱两可的:

Tomodachi ni hon oagemashita

前面的句子没有具体说明谁把一本书(或几本书)送给了一个朋友(或几个朋友),但它的上下文在对话中会很清楚. 顺便说一句,日本人经常省略主语代词(除非句子变得模棱两可),因此更常见的是看到第二个句子(即没有 Watashi wa)而不是第一个罗马字句子。

将较早的日语句子与浪漫语言意大利语、西班牙语、法语、葡萄牙语和德语中的对应句进行对比(某些单词缺少一些重音符号):

- 意大利人:我给了我朋友一本书。

- Chinese: [我] 给了我的朋友一本书。

- Chinese: 我给了我朋友一本书。

- Chinese: 我给了我朋友一本书。

- 德语。Ich habe ein Buch dem Freund gegeben。

请注意,意大利语和法语句子使用复合动词,其两个部分是连续的(相邻),而德语使用复合动词,其中第二部分(过去分词)位于句子的末尾。然而,西班牙语和葡萄牙语的句子使用动词“to give”的简单过去(preterit)形式。

机器学习代写|自然语言处理代写NLP代考|Japanese Nominalization

名词化器将动词(甚至整个句子)转换为名词。名词化器类似于英语中的“that”从句,在将动作作为名词来谈论时它们很有用。日语有两个名词化词:no 和 koto ga。

名词化器○(no) 用于知觉动词,如见 (to see) 和 阎<(听)。例如,以下句子的意思是“我喜欢听音乐”,第一句用罗马字书写,然后是包含汉字和平假名混合的第二句:

Watashi wa ongaku o kiku no ga daisuki desu

接下来的三句都是“他喜欢看报纸”的意思,用罗马字,然后是平假名和汉字:

Kare wa shimbun o yomu no ga daisuki desu

カั丸は新間を読 力量○丸牙齿新間的阅读

彼才 んक読むのか大号米小号唔 ķ阅读没有什么的蚊子

koto ga 名词化器是另一个日语名词化器,用于“你曾经……”形式的句子例如,下面的句子表示“你(曾经)去过日本吗?”

日本にレ)=<≠≈−52⇒

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。