计算机代写|机器学习代写machine learning代考|COMP3308

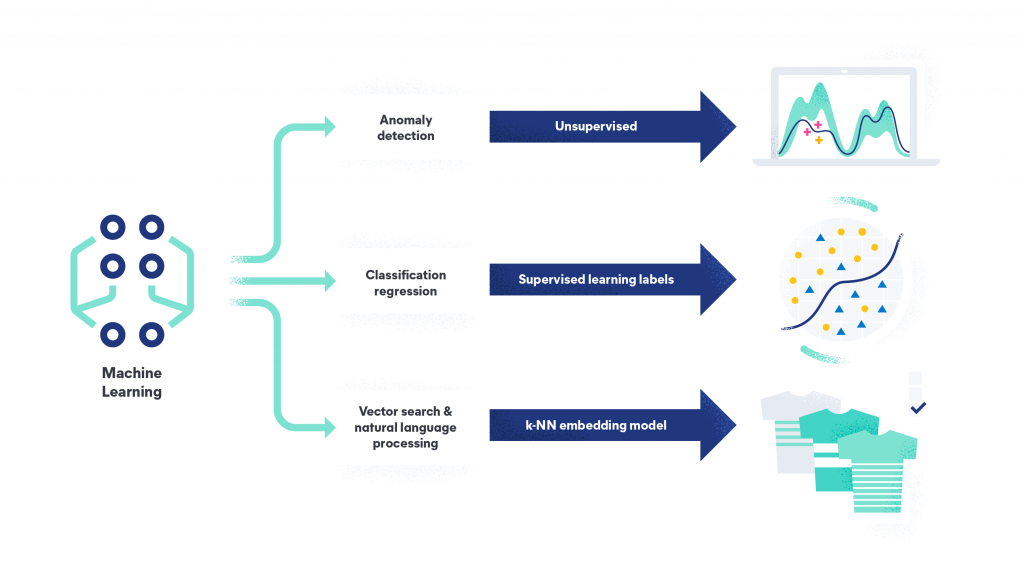

如果你也在 怎样代写机器学习Machine Learning 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。机器学习Machine Learning令人兴奋。这是有趣的,具有挑战性的,创造性的,和智力刺激。它还为公司赚钱,自主处理大量任务,并从那些宁愿做其他事情的人那里消除单调工作的繁重任务。

机器学习Machine Learning也非常复杂。从数千种算法、数百种开放源码包,以及需要具备从数据工程(DE)到高级统计分析和可视化等各种技能的专业实践者,ML专业实践者所需的工作确实令人生畏。增加这种复杂性的是,需要能够与广泛的专家、主题专家(sme)和业务单元组进行跨功能工作——就正在解决的问题的性质和ml支持的解决方案的输出进行沟通和协作。

statistics-lab™ 为您的留学生涯保驾护航 在代写机器学习 machine learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写机器学习 machine learning代写方面经验极为丰富,各种代写机器学习 machine learning相关的作业也就用不着说。

计算机代写|机器学习代写machine learning代考|Bias and Variance Analysis

Bias and variance analysis plays an important role in ensemble classification research due to the framework it provides for classifier prediction error decomposition.

Initially, Geman has decomposed prediction error into bias and variance terms under the regression setting using squared-error loss [10]. This decomposition brings about the fact that a decrease/increase in the prediction error rate is caused by a decrease/increase in bias, or in variance, or in both. Extensions of the analysis have been carried out on the classification setting, and later applied on different ensemble classifiers in order to analyse the reason behind their success over single classifiers. It has been shown that the reason for most of the ensembles to have lower prediction error rates is due to the reductions they offer in sense of both bias and variance.

However, the extension of the original theoretical analysis on regression has been done in various ways by different researchers for classification; and there is no standard definition accepted. Therefore, the results of the analyses also differ from each other slightly. Some of the definitions/frameworks that have gained interest within the research field are given by Breiman [3], Kohavi and Wolpert [15], Dietterich and Kong [16], Friedman [9], Wolpert [25], Heskes [11], Tibshirani [19], Domingos [6] and James [13].

Although there are dissimilarities in-between the frameworks, the main intuitions behind each are similar. Consider a training set $T$ with patterns $\left(x_i, l_i\right)$, where $x$ represents the feature vector and $l$ the corresponding label. Given a test pattern, an optimal classifier model predicts a decision label by assuring the lowest expected loss over all possible target label values. This classifier, which is actually the Bayes classifier when used with the zero-one loss function, is supposed to know and use the underlying likelihood probability distribution for the input dataset patterns/classes. If we call the decision of the optimal classifier as the optimal decision $(O D)$, then for a given test pattern $\left(x_i, l_i\right), O D=\operatorname{argmin}_\alpha E_t[L(t, \alpha)]$ where $L$ denotes the loss function used, and $l$ the possible target label values.

The estimator, on the other hand, is actually an averaged classifier model. It predicts a decision label by assuring the lowest expected loss over all labels that are created by classifiers trained on different training sets. The intrinsic parameters of these classifiers are usually the same, and the only difference is the training sets that they are trained on. In this case, instead of minimizing the loss over the target labels using the known underlying probability distribution as happens in the optimal classifier case, the minimization of the loss is carried out for the set of labels which are created by the classifiers trained on various training sets. If the decision of the estimator is named as the expected estimator decision $(E E D)$; then for a given test pattern $\left(x_i, l_i\right), E E D=\operatorname{argmin}_\alpha E_l[L(l, \alpha)]$ where $L$ denotes the loss function used, and $l$ the label values obtained from the classifiers used. For regression under the squared-error loss setting, the $O D$ is the mean of the target labels while the EED is the mean of the classifier decisions obtained via different training sets.

计算机代写|机器学习代写machine learning代考|Bias and Variance Analysis of James

James [13] extends the prediction error decomposition, which is initially proposed by Geman et al [10] for squared error under regression setting, for all symmetric loss functions. Therefore, his definition also covers zero-one loss under classification setting, which we use in the experiments.

In his decomposition, the terms systematic effect (SE) and variance effect (VE) satisfy the additive decomposition for all symmetric loss functions, and for both real valued and categorical predictors. They actually indicate the effect of bias and variance on the prediction error. For example, a negative $V E$ would mean that variance actually helps reduce the prediction error. On the other hand, the bias term is defined to show the average distance between the response and the predictor; and the variance term refers to the variability of the predictor. As a result, both the meanings and the additive characteristics of the bias and variance concepts of the original setup have been preserved. Following is a summary of the bias-variance derivations of James:

For any symmetric loss function $L$, where $L(a, b)=L(b, a)$ :

$$

\begin{aligned}

E_{Y, \tilde{Y}}[L(Y, \tilde{Y})]= & E_Y[L(Y, S Y)]+E_Y[L(Y, S \tilde{Y})-L(Y, S Y)] \

& +E_{Y, \tilde{Y}}[L(Y, \tilde{Y})-L(Y, S \tilde{Y})] \

\text { predictionerror }= & \operatorname{Var}(Y)+S E(\tilde{Y}, Y)+\operatorname{VE}(\tilde{Y}, Y)

\end{aligned}

$$

where $L(a, b)$ is the loss when $b$ is used in predicting $a, Y$ is the response and $\tilde{Y}$ is the predictor. $S Y=\operatorname{argmin}\mu E_Y[L(Y, \mu)]$ and $S \tilde{Y}=\operatorname{argmin}\mu E_Y[L(\tilde{Y}, \mu)]$. We see here that prediction error is composed of the variance of the response (irreducible noise), $S E$ and $V E$.

Using the same terminology, the bias and variance for the predictor are defined as follows:

$$

\begin{aligned}

\operatorname{Bias}(\tilde{Y}) & =L(S Y, S \tilde{Y}) \

\operatorname{Var}(\tilde{Y}) & =E_{\tilde{Y}}[L(\tilde{Y}, S \tilde{Y})]

\end{aligned}

$$

When the specific case of classification problems with zero-one loss function is considered, we end up with the following formulations:

$L(a, b)=I(a \neq b), Y \varepsilon{1,2,3 . . N}$ for an $N$ class problem, $P_i^Y=P_Y(Y=i), P_i^{\tilde{Y}}=$ $P_{\tilde{Y}}(\tilde{Y}=i), S T=\operatorname{argmin}i E_Y[I(Y \neq i)]=\operatorname{argmax}_i P_i^Y$ Therefore, $$ \begin{aligned} \operatorname{Var}(Y) & =P_Y(Y \neq S Y)=1-\max _i P_i^Y \ \operatorname{Var}(\tilde{Y}) & =P{\tilde{Y}}(\tilde{Y} \neq S \tilde{Y})=1-\max i P_i^{\tilde{Y}} \ \operatorname{Bias}(\tilde{Y}) & =I(S \tilde{Y} \neq S Y) \ \operatorname{VE}(\tilde{Y}, Y) & =P(Y \neq \tilde{Y})-P_Y(Y \neq S \tilde{Y})=P{S \tilde{Y}}^Y-\sum_i P_i^Y P_i^{\tilde{Y}} \

S E(\tilde{Y}, Y) & =P_Y(Y \neq S \tilde{Y})-P_Y(Y \neq S Y)=P_{S Y}^Y-P_{S \tilde{Y}}^Y

\end{aligned}

$$

where $I(q)$ is 1 if $q$ is a true argument and 0 otherwise.

机器学习代考

计算机代写|机器学习代写machine learning代考|Bias and Variance Analysis

偏差和方差分析为分类器预测误差分解提供了框架,在集成分类研究中起着重要的作用。

最初,german使用误差平方损失将回归设置下的预测误差分解为偏差项和方差项[10]。这种分解带来的事实是,预测错误率的减少/增加是由偏差或方差的减少/增加引起的,或者两者兼而有之。本文对分类设置进行了扩展分析,随后将其应用于不同的集成分类器,以分析它们优于单一分类器的原因。已经表明,大多数集成具有较低的预测错误率的原因是由于它们在偏差和方差的意义上提供了减少。

然而,不同的研究人员以不同的方式对回归的原始理论分析进行了扩展,用于分类;目前还没有公认的标准定义。因此,分析结果也略有不同。Breiman[3]、Kohavi and Wolpert[15]、Dietterich and Kong[16]、Friedman[9]、Wolpert[25]、Heskes[11]、Tibshirani[19]、Domingos[6]和James[13]给出了一些在研究领域引起兴趣的定义/框架。

尽管框架之间存在差异,但每个框架背后的主要直觉是相似的。考虑一个模式为$\left(x_i, l_i\right)$的训练集$T$,其中$x$表示特征向量,$l$表示相应的标签。给定一个测试模式,最优分类器模型通过确保所有可能的目标标签值的最低预期损失来预测决策标签。当与0 – 1损失函数一起使用时,这个分类器实际上是贝叶斯分类器,它应该知道并使用输入数据集模式/类的潜在可能性概率分布。如果我们将最优分类器的决策称为最优决策$(O D)$,那么对于给定的测试模式$\left(x_i, l_i\right), O D=\operatorname{argmin}_\alpha E_t[L(t, \alpha)]$,其中$L$表示使用的损失函数,$l$表示可能的目标标签值。

另一方面,估计器实际上是一个平均分类器模型。它通过确保在不同训练集上训练的分类器创建的所有标签上的最低预期损失来预测决策标签。这些分类器的内在参数通常是相同的,唯一的区别是它们所训练的训练集。在这种情况下,与在最优分类器情况下使用已知的潜在概率分布最小化目标标签上的损失不同,对由在各种训练集上训练的分类器创建的标签集进行最小化损失。如果估计器的决策被命名为预期估计器决策$(E E D)$;然后对于给定的测试模式$\left(x_i, l_i\right), E E D=\operatorname{argmin}_\alpha E_l[L(l, \alpha)]$,其中$L$表示使用的损失函数,$l$表示从使用的分类器获得的标签值。对于平方误差损失设置下的回归,$O D$为目标标签的均值,EED为通过不同训练集得到的分类器决策的均值。

计算机代写|机器学习代写machine learning代考|Bias and Variance Analysis of James

James[13]将Geman等[10]最初针对回归设置下的平方误差提出的预测误差分解扩展到所有对称损失函数。因此,他的定义也涵盖了我们在实验中使用的分类设置下的0 – 1损失。

在他的分解中,系统效应(SE)和方差效应(VE)两项满足所有对称损失函数的加性分解,对于实值和分类预测器都是如此。它们实际上表明了偏差和方差对预测误差的影响。例如,负值$V E$意味着方差实际上有助于减少预测误差。另一方面,定义偏差项来表示响应和预测器之间的平均距离;方差项指的是预测器的可变性。结果,保留了原始设置的偏差和方差概念的含义和可加性特征。下面是James的偏方差推导的总结:

对于任意对称损失函数$L$,其中$L(a, b)=L(b, a)$:

$$

\begin{aligned}

E_{Y, \tilde{Y}}[L(Y, \tilde{Y})]= & E_Y[L(Y, S Y)]+E_Y[L(Y, S \tilde{Y})-L(Y, S Y)] \

& +E_{Y, \tilde{Y}}[L(Y, \tilde{Y})-L(Y, S \tilde{Y})] \

\text { predictionerror }= & \operatorname{Var}(Y)+S E(\tilde{Y}, Y)+\operatorname{VE}(\tilde{Y}, Y)

\end{aligned}

$$

当$b$用于预测时,$L(a, b)$是损失$a, Y$是响应,$\tilde{Y}$是预测者。$S Y=\operatorname{argmin}\mu E_Y[L(Y, \mu)]$和$S \tilde{Y}=\operatorname{argmin}\mu E_Y[L(\tilde{Y}, \mu)]$。我们在这里看到,预测误差由响应的方差(不可约噪声),$S E$和$V E$组成。

使用相同的术语,预测器的偏差和方差定义如下:

$$

\begin{aligned}

\operatorname{Bias}(\tilde{Y}) & =L(S Y, S \tilde{Y}) \

\operatorname{Var}(\tilde{Y}) & =E_{\tilde{Y}}[L(\tilde{Y}, S \tilde{Y})]

\end{aligned}

$$

当考虑具有0 – 1损失函数的分类问题的具体情况时,我们得到如下公式:

$L(a, b)=I(a \neq b), Y \varepsilon{1,2,3 . . N}$为$N$类问题,$P_i^Y=P_Y(Y=i), P_i^{\tilde{Y}}=$$P_{\tilde{Y}}(\tilde{Y}=i), S T=\operatorname{argmin}i E_Y[I(Y \neq i)]=\operatorname{argmax}i P_i^Y$因此,$$ \begin{aligned} \operatorname{Var}(Y) & =P_Y(Y \neq S Y)=1-\max _i P_i^Y \ \operatorname{Var}(\tilde{Y}) & =P{\tilde{Y}}(\tilde{Y} \neq S \tilde{Y})=1-\max i P_i^{\tilde{Y}} \ \operatorname{Bias}(\tilde{Y}) & =I(S \tilde{Y} \neq S Y) \ \operatorname{VE}(\tilde{Y}, Y) & =P(Y \neq \tilde{Y})-P_Y(Y \neq S \tilde{Y})=P{S \tilde{Y}}^Y-\sum_i P_i^Y P_i^{\tilde{Y}} \ S E(\tilde{Y}, Y) & =P_Y(Y \neq S \tilde{Y})-P_Y(Y \neq S Y)=P{S Y}^Y-P_{S \tilde{Y}}^Y

\end{aligned}

$$

如果$q$为真参数,$I(q)$为1,否则为0。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。