澳洲代写|PHYC30018|Quantum Physics量子计算 墨尔本大学

statistics-labTM为您提供墨尔本大学(The University of Melbourne,简称UniMelb,中文简称“墨大”)Quantum Physics量子计算澳洲代写代考和辅导服务!

课程介绍:

Quantum mechanics plays a central role in our understanding of fundamental phenomena, primarily in the microscopic domain. It lays the foundation for an understanding of atomic, molecular, condensed matter, nuclear and particle physics.

Quantum Physics量子计算问题集

(a) Suppose that the resistivity matrix is given by the classical result

$$

\rho=\left(\begin{array}{cc}

\rho_0 & -\rho_H \

\rho_H & \rho_0

\end{array}\right)

$$

where $\rho_H=B /$ nec is the Hall resistivity and $\rho_0$ is the usual Ohmic resistivity. Find the conductivity matrix, $\sigma=\rho^{-1}$. Write it in the form:

$$

\sigma=\left(\begin{array}{cc}

\sigma_0 & \sigma_H \

-\sigma_H & \sigma_0

\end{array}\right) .

$$

What are $\sigma_0$ and $\sigma_H$ ?

(b) Suppose $B=0$, so the Hall resistivity is zero. Notice that the Ohmic conductivity, $\sigma_0$, is just $1 / \rho_0$. In particular, note that $\sigma_0 \rightarrow \infty$ as $\rho_0 \rightarrow 0$. Now suppose $\rho_H \neq 0$. Show that $\sigma_0 \rightarrow 0$ as $\rho_0 \rightarrow 0$, so it is possible to have both $\sigma_0$ and $\rho_0$ equal to zero

This problem asks you to give a complete presentation of a calculation that is almost the same as one you saw in lecture.

Consider a constant electric field, $\vec{E}=\left(0, E_0, 0\right)$ and a constant magnetic field, $\vec{B}=\left(0,0, B_0\right)$.

(a) Choose an electrostatic potential $\phi$ and a vector potential $\vec{A}$ which describe the $\vec{E}$ and $\vec{B}$ fields, and write the Hamiltonian for a charged particle of mass $m$ and charge $q$ in these fields. Assume that the particle is restricted to move in the $x y$-plane.

(b) What are the allowed energies as a function of $B_0$ and $E_0$ ? Draw a figure to show how the Landau levels (energy levels when $E_0=0$ ) change as $E_0$ increases.

You will see the “standard presentation” of the Aharonov-Bohm effect in lecture, on the day that this problem set is due. The standard presentation has its advantages, and in particular is more general than the presentation you will work through in this problem. However, students often come away from the standard presentation of the Aharonov-Bohm effect thinking that the only way to detect this effect is to do an interference experiment. This is not true, and the purpose of this problem is to disabuse you of this misimpression before you form it.

As Griffiths explains on pages 385-387 (344-345 in 1st Ed.), the Aharonov-Bohm effect modifies the energy eigenvalues of suitably chosen quantum mechanical systems. In this problem, I ask you to work through the same physical example that Griffiths uses, but in a different fashion which makes more use of gauge invariance.

Imagine a particle constrained to move on a circle of radius $b$ (a bead on a wire ring, if you like.) Along the axis of the circle runs a solenoid of radius $a<b$, carrying a magnetic field $\vec{B}=\left(0,0, B_0\right)$. The field inside the solenoid is uniform

and the field outside the solenoid is zero. The setup is depicted in Griffiths’ Fig. 10.10. (10.12 in 1st Ed.)

(a) Construct a vector potential $\vec{A}$ which describes the magnetic field (both inside and outside the solenoid) and which has the form $A_r=A_z=0$ and $A_\phi=\alpha(r)$ for some function $\alpha(r)$. I am using cylindrical coordinates $z, r$, $\phi$.

(b) Since $\vec{\nabla} \times \vec{A}=0$ for $r>a$, it must be possible to write $\vec{A}=\vec{\nabla} f$ in any simply connected region in $r>a$. [This is a theorem in vector calculus.] Show that if we find such an $f$ in the region

$$

r>a \text { and }-\pi+\epsilon<\phi<\pi-\epsilon,

$$

then

$$

f(r, \pi-\epsilon)-f(r,-\pi+\epsilon) \rightarrow \Phi \text { as } \epsilon \rightarrow 0 .

$$

Here, the total magnetic flux is $\Phi=\pi a^2 B_0$. Now find an explicit form for $f$, which is a function only of $\phi$.

(c) Now consider the motion of a “bead on a ring”: write the Schrödinger equation for the particle constrained to move on the circle $r=b$, using the $\vec{A}$ you found in (a). Hint: the answer is given in Griffiths.

(d) Use the $f(\phi)$ found in (b) to gauge transform the Schrödinger equation for $\psi(\phi)$ within the angular region $-\pi+\epsilon<\phi<\pi-\epsilon$ to a Schrödinger equation for a free particle within this angular region. Call the original wave function $\psi(\phi)$ and the gauge-transformed wave function $\psi^{\prime}(\phi)$.

(e) The original wave function $\psi$ must be single-valued for all $\phi$, in particular at $\phi=\pi$. That is, $\psi(\pi-\epsilon)-\psi(-\pi+\epsilon) \rightarrow 0$ and $\frac{\partial \psi}{\partial \phi}(\pi-\epsilon)-\frac{\partial \psi}{\partial \phi}(-\pi+\epsilon) \rightarrow 0$ as $\epsilon \rightarrow 0$. What does this say about the gauge-transformed wave function? I.e., how must $\psi^{\prime}(\pi-\epsilon)$ and $\psi^{\prime}(-\pi+\epsilon)$ be related as $\epsilon \rightarrow 0$ ?

[Hint: because the $f(\phi)$ is not single valued at $\phi=\pi$, the gauge transformed wave function $\psi^{\prime}(\phi)$ is not single valued there either.]

(f) Solve the Schrödinger equation for $\psi^{\prime}$, and find energy eigenstates which satisfy the boundary conditions you derived in (e). What are the allowed energy eigenvalues?

(g) Undo the gauge transformation, and find the energy eigenstates $\psi(\phi)$ in the original gauge. Do the energy eigenvalues in the two gauges differ?

(h) Plot the energy eigenvalues as a function of the enclosed flux, $\Phi$. Show that the energy eigenvalues are periodic functions of $\Phi$ with period $\Phi_0$, where you must determine $\Phi_0$. For what values of $\Phi$ does the enclosed magnetic field have no effect on the spectrum of a particle on a ring? Show that the

Aharonov-Bohm effect can only be used to determine the fractional part of $\Phi / \Phi_0$.

[Note: you have shown that even though the bead on a ring is everywhere in a region in which $\vec{B}=0$, the presence of a nonzero $\vec{A}$ affects the energy eigenvalue spectrum. However, the effect on the energy eigenvalues is determined by $\Phi$, and is therefore gauge invariant. To confirm the gauge invariance of your result, you can compare your answer for the energy eigenvalues to Griffiths’ result, obtained using a different gauge.]

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

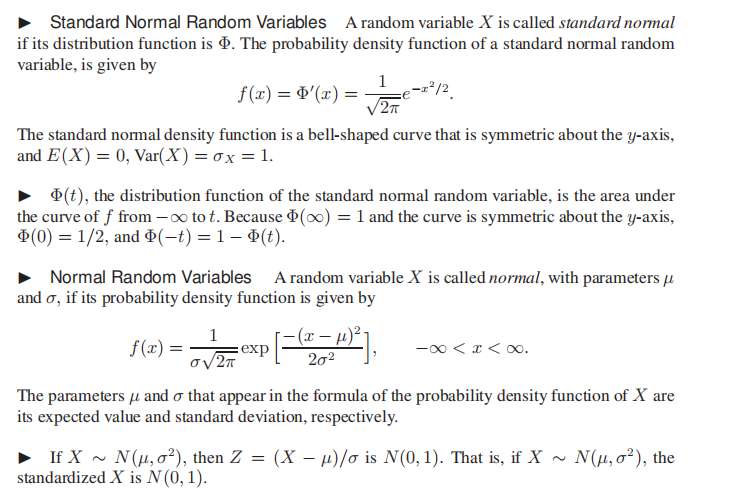

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。