数学代写|信息论代写information theory代考|FEO3350

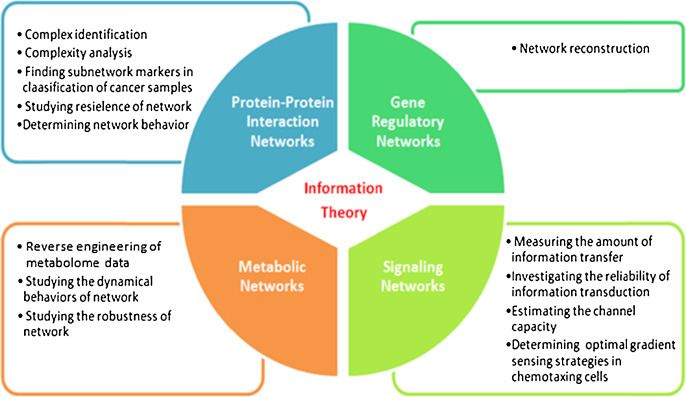

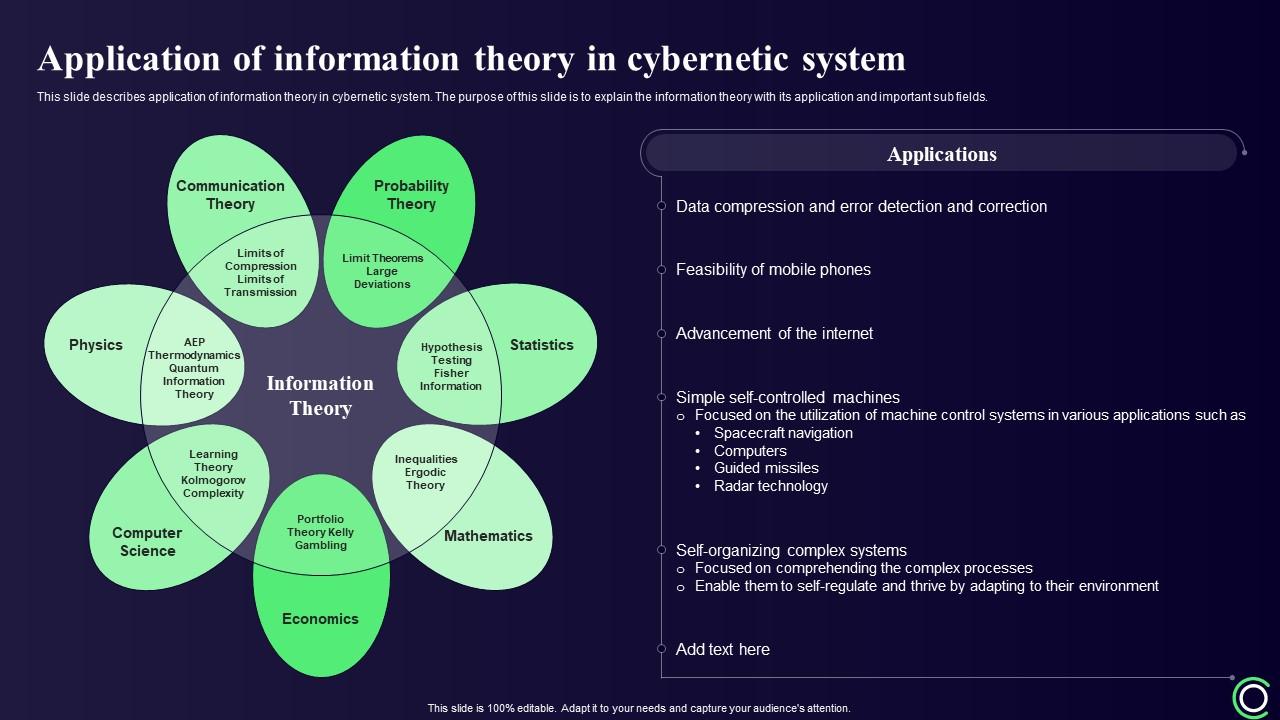

如果你也在 怎样代写信息论information theory 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。信息论information theory回答了通信理论中的两个基本问题:什么是最终的数据压缩(答案:熵$H$),什么是通信的最终传输速率(答案:信道容量$C$)。由于这个原因,一些人认为信息论是通信理论的一个子集。我们认为它远不止于此。

信息论information theory在统计物理学(热力学)、计算机科学(柯尔莫哥洛夫复杂性或算法复杂性)、统计推断(奥卡姆剃刀:“最简单的解释是最好的”)以及概率和统计学(最优假设检验和估计的误差指数)方面都做出了根本性的贡献。

statistics-lab™ 为您的留学生涯保驾护航 在代写信息论information theory方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写信息论information theory代写方面经验极为丰富,各种代写信息论information theory相关的作业也就用不着说。

数学代写|信息论代写information theory代考|The SMI of a System of Interacting Particles in Pairs Only

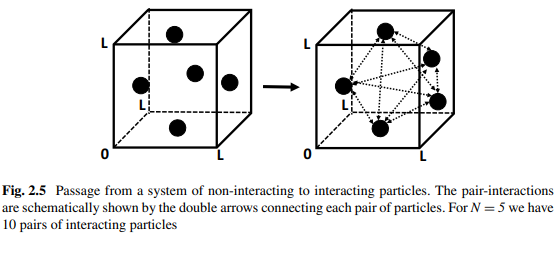

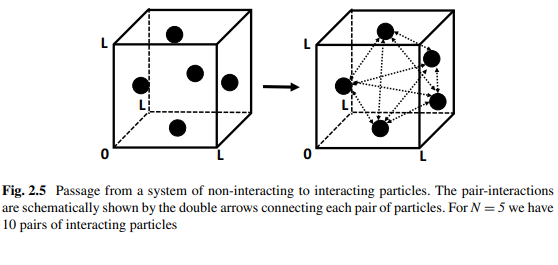

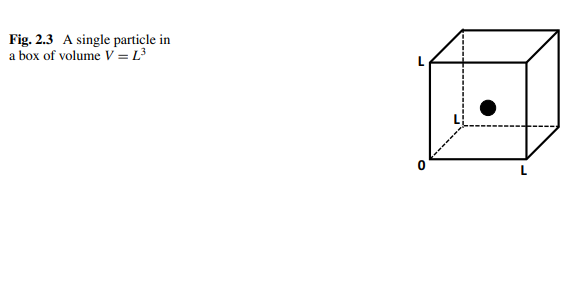

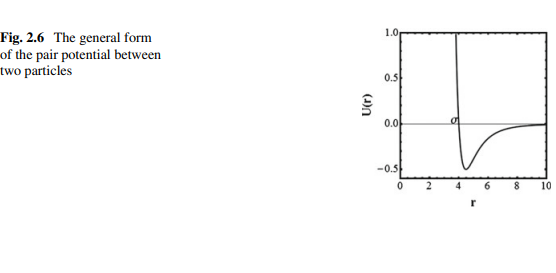

In this section we consider a special case of a system of interacting particles. We start with an ideal gas-i.e. system for which we can neglect all intermolecular interactions. Strictly speaking, such a system does not exist. However, if the gas is very dilute such that the average intermolecular distance is very large the system behaves as if there are no interactions among the particle.

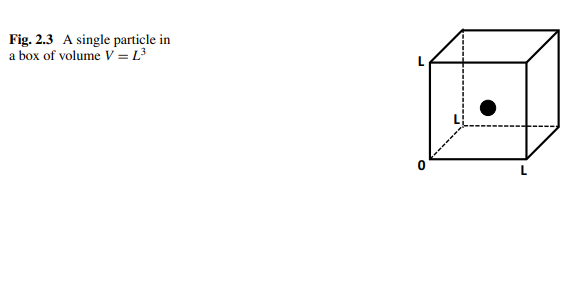

Next, we increase the density of the particles. At first we shall find that pairinteractions affect the thermodynamics of the system. Increasing further the density, triplets, quadruplets, and so on interactions, will also affect the behavior of the system. In the following we provide a very brief description of the first order deviation from ideal gas; systems for which one must take into account pair-interactions but neglect triplet and higher order interactions. The reader who is not interested in the details of the derivation can go directly to the result in Eq. (2.51) and the following analysis of the MI.

We start with the general configurational PF of the system, Eq. (2.31) which we rewrite in the form:

$$

Z_N=\int d R^N \prod_{i<j} \exp \left[-\beta U_{i j}\right]

$$

where $U_{i j}$ is the pair potential between particles $i$ and $j$. It is assumed that the total potential energy is pairwise additive.

Define the so-called Mayer $f$-function, by:

$$

f_{i j}=\exp \left(-\beta U_{i j}\right)-1

$$

We can rewrite $Z_N$ as:

$$

Z_N=\int d R^N \prod_{i<j}\left(f_{i j}+1\right)=\int d R^N\left[1+\sum_{i<j} f_{i j}+\sum f_{i j} f_{j k}+\cdots\right]

$$

Neglecting all terms beyond the first sum, we obtain:

$$

Z_N=V^N+\frac{N(N-1)}{2} \int f_{12} d R^N=V^N+\frac{N(N-1)}{2} V^{N-2} \int f_{12} d R_1 d R_2

$$

数学代写|信息论代写information theory代考|Entropy-Change in Phase Transition

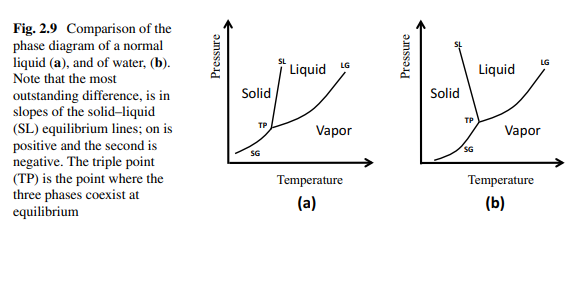

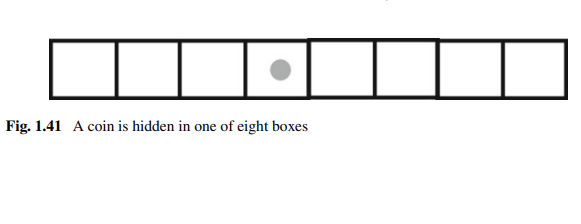

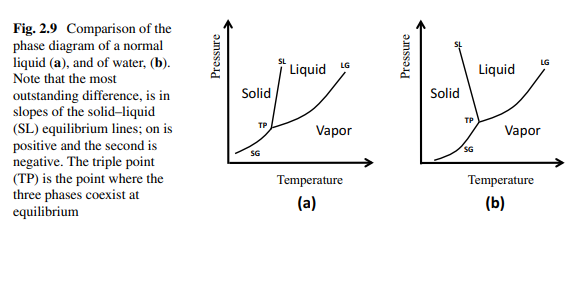

In this section, we shall discuss the entropy-changes associated with phase transitions. Here, by entropy we mean thermodynamic entropy, the units of which are cal/(deg $\mathrm{mol}$ ). However, as we have seen in Chap. 5 of Ben-Naim [1]. The entropy is up to a multiplicative constant an SMI defined on the distribution of locations and velocities (or momenta) of all particles in the system at equilibrium. To convert from entropy to SMI one has to divide the entropy by the factor $k_B \log _e 2$, where $k_B$ is the Boltzmann constant, and $\log _e 2$ is the natural $\log$ arithm of 2 , which we denote by $\ln 2$. Once we do this conversion from entropy to SMI we obtain the SMI in units of bits. In this section we shall discuss mainly the transitions between gases, liquids and solids. Figure 2.9 shows a typical phase diagram of a one-component system. For more details on phase diagrams, see Ben-Naim and Casadei [8].

It is well-known that solid has a lower entropy than liquid, and liquid has a lower entropy of a gas. These facts are usually interpreted in terms of order-disorder. This interpretation of entropy is invalid; more on this in Ben-Naim [6]. Although, it is true that a solid is viewed as more ordered than liquid, it is difficult to argue that a liquid is more ordered or less ordered than a gas.

In the following we shall interpret entropy as an SMI, and different entropies in terms of different MI due to different intermolecular interactions. We shall discuss changes of phases at constant temperature. Therefore, all changes in SMI (hence, in entropy) will be due to locational distributions; no changes in the momenta distribution.

The line SG in Fig. 2.9 is the line along in which solid and gas coexist. The slope of this curve is given by:

$$

\left(\frac{d P}{d T}\right)_{e q}=\frac{\Delta S_s}{\Delta V_s}

$$

In the process of sublimation ( $s$, the entropy-change and the volume change for both are always positive. We denoted by $\Delta V_s$ the change in the volume of one mole of the substance, when it is transferred from the solid to the gaseous phase. This volume change is always positive. The reason is that a mole of the substance occupies a much larger volume in the gaseous phase than in the liquid phase (at the same temperature and pressure).

The entropy-change $\Delta S_s$ is also positive. This entropy-change is traditionally interpreted in terms of transition from an ordered phase (solid) to a disordered (gaseous) phase. However, the more correct interpretation is that the entropy-change is due to two factors; the huge increase in the accessible volume available to each particle and the decrease in the extent of the intermolecular interaction. Note that the slope of the SG curve is quite small (but positive) due to the large $\Delta V_s$.

信息论代写

数学代写|信息论代写information theory代考|The SMI of a System of Interacting Particles in Pairs Only

在本节中,我们考虑一个相互作用粒子系统的特殊情况。我们从理想气体开始,即。我们可以忽略所有分子间相互作用的系统。严格来说,这样的制度是不存在的。然而,如果气体非常稀,使得平均分子间距离非常大,则系统表现得好像粒子之间没有相互作用。

接下来,我们增加粒子的密度。首先,我们将发现对相互作用影响系统的热力学。进一步增加密度,三联体、四联体等相互作用,也会影响系统的行为。下面我们对理想气体的一阶偏差作一个非常简短的描述;必须考虑成对相互作用而忽略三重态和高阶相互作用的系统。对推导细节不感兴趣的读者可以直接查看公式(2.51)中的结果和下面对MI的分析。

我们从系统的一般构型PF方程(2.31)开始,将其改写为:

$$

Z_N=\int d R^N \prod_{i<j} \exp \left[-\beta U_{i j}\right]

$$

其中$U_{i j}$是粒子$i$和$j$之间的对势。假定总势能是两两相加的。

定义所谓的Mayer $f$ -函数:

$$

f_{i j}=\exp \left(-\beta U_{i j}\right)-1

$$

我们可以把$Z_N$写成:

$$

Z_N=\int d R^N \prod_{i<j}\left(f_{i j}+1\right)=\int d R^N\left[1+\sum_{i<j} f_{i j}+\sum f_{i j} f_{j k}+\cdots\right]

$$

忽略第一个和以外的所有项,我们得到:

$$

Z_N=V^N+\frac{N(N-1)}{2} \int f_{12} d R^N=V^N+\frac{N(N-1)}{2} V^{N-2} \int f_{12} d R_1 d R_2

$$

数学代写|信息论代写information theory代考|Entropy-Change in Phase Transition

在本节中,我们将讨论与相变有关的熵变。这里,熵指的是热力学熵,单位是卡/(度$\mathrm{mol}$)。然而,正如我们在Ben-Naim[1]的第五章中所看到的。熵是一个乘法常数和SMI,定义在平衡状态下系统中所有粒子的位置和速度(或动量)的分布。要将熵转换为SMI,必须将熵除以因子$k_B \log _e 2$,其中$k_B$是玻尔兹曼常数,$\log _e 2$是2的自然$\log$算法,我们用$\ln 2$表示。一旦我们完成了从熵到SMI的转换,我们就得到了以比特为单位的SMI。在本节中,我们将主要讨论气体、液体和固体之间的转变。图2.9为单组分系统的典型相图。有关相图的更多细节,请参见Ben-Naim和Casadei[8]。

众所周知,固体的熵比液体小,而液体的熵比气体小。这些事实通常用有序-无序来解释。这种对熵的解释是无效的;Ben-Naim[6]对此有更详细的介绍。虽然固体确实被认为比液体更有序,但很难说液体比气体更有序还是更无序。

在下文中,我们将熵解释为SMI,不同的熵解释为由于不同的分子间相互作用而产生的不同的MI。我们将讨论恒温下相的变化。因此,SMI的所有变化(也就是熵的变化)都是由位置分布引起的;动量分布没有变化。

图2.9中SG线为固气共存线。曲线的斜率为:

$$

\left(\frac{d P}{d T}\right)_{e q}=\frac{\Delta S_s}{\Delta V_s}

$$

在升华过程中($s$),两者的熵变和体积变都是正的。我们用$\Delta V_s$表示一摩尔物质从固相变为气相时体积的变化。体积变化总是正的。原因是一摩尔的物质在气相中比在液相中(在相同的温度和压力下)占有更大的体积。

熵变$\Delta S_s$也是正的。这种熵变传统上被解释为从有序相(固体)到无序相(气体)的转变。然而,更正确的解释是,熵的变化是由于两个因素;每个粒子可用的可接近体积的巨大增加和分子间相互作用程度的减少。请注意,由于$\Delta V_s$较大,SG曲线的斜率相当小(但为正)。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。