如果你也在 怎样代写强化学习reinforence learning这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

强化学习是一种基于奖励期望行为和/或惩罚不期望行为的机器学习训练方法。一般来说,强化学习代理能够感知和解释其环境,采取行动并通过试验和错误学习。

statistics-lab™ 为您的留学生涯保驾护航 在代写强化学习reinforence learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写强化学习reinforence learning代写方面经验极为丰富,各种代写强化学习reinforence learning相关的作业也就用不着说。

我们提供的强化学习reinforence learning及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

机器学习代写|强化学习project代写reinforence learning代考|The Problem of Naive Exploration

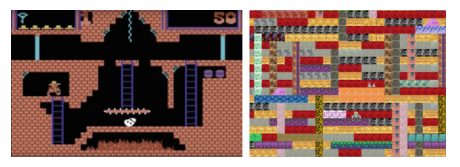

In practice the “exploration-exploitation dilemma” is frequently addressed naively by dithering $[27,48,49]$. In continuous action spaces Gaussian noise is added to actions, while in discrete action spaces actions are chosen $\epsilon$-greedily, meaning that optimal actions are chosen with probability $1-\epsilon$ and random actions with probability $\epsilon$. These two approaches work in environments where random sequences of actions are likely to cause positive rewards or to “do the right thing”. Since rewards in sparse domains are infrequent, getting a random positive reward can become very unlikely, resulting in a worst case sample complexity exponential in the amount of states and actions $[20,33,34,56]$. For example, Fig. 1 shows a case where random exploration suffers from exponential sample complexity.

Empirically, this shortcoming can be observed in numerous benchmarks environments, such as the Arcade Learning Environment [5]. Games like Montezuma’s Revenge or Pitfall have sparse reward signals and consequently agents with ditheringbased exploration learn almost nothing [27, 48]. While Montezuma’s Revenge has become the standard benchmark for hard exploration problems, it is important to stress that successfully solving it may not always be a good indicator of intelligent exploration strategies.

This bad exploration behaviour is in partly due to the lack of a prior assumption about the world and its behaviour. As pointed out by [10], in a randomized version of Montezuma’s Revenge (Fig.3) humans perform significantly worse because their prior knowledge is diminished by the randomization, while for RL agents there is no difference due to the lack of prior in the first place. Augmenting an RL agent with prior knowledge could provide a more guided exploration. Yet, we can vastly improve over random exploration even without making use of prior.

A good exploration algorithm should be able to solve hard exploration problems with sparse rewards in large state-action spaces while remaining computationally tractable. According to [33] it is necessary that such an algorithm performs “deep exploration” rather than “myopic exploration”. An agent doing deep exploration will take several coherent actions to explore instead of just locally choosing the most interesting states independently. This is analogous to the general goal of the agent: maximizing the future expected reward rather than the reward of the next timestep.

机器学习代写|强化学习project代写reinforence learning代考|Optimism in the Face of Uncertainty

Many of the provably efficient algorithms are based on optimism in the face of uncertainty (OFU) [24] in which the agent acts greedily w.r.t. action values that are optimistic by including an exploration bonus. Either the agent then experiences a high reward and the action was indeed optimal or the agent experiences a low reward and learns that the action was not optimal. After visiting a state-action pair, the exploration bonus is reduced. This approach is superior to naive approaches in that it avoids actions where low value and low information gain are possible. Generally, under the assumption that the agent can visit every state-action pair infinitely many times, the overestimation will decrease and almost optimal behaviour is obtained. Optimal behaviour cannot be obtained due to the bias introduced by the exploration bonus. Most of the algorithms are optimal up to polynomial in the amount of states, actions or the horizon length. The literature provides many variations of these algorithms which use bounds with varying efficacy or different simplifying assumptions, e.g. $[3,6,9,19,20,22]$.

The bounds are often expressed in a framework called probably approximately correct $(\mathrm{PAC})$ learning. Formally, the PAC bound is expressed by a confidence parameter $\delta$ and an accuracy parameter $\epsilon$ w.r.t. which the algorithms are shown to be $\epsilon$ optimal with probability $1-\delta$ after a polynomial amount of timesteps in $\frac{1}{\sigma}, \frac{1}{\epsilon}$ and some factors depending on the MDP at hand.

机器学习代写|强化学习project代写reinforence learning代考|Intrinsic Rewards

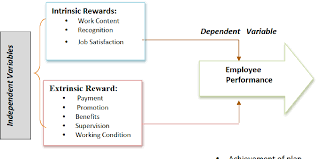

A large body of work deals with efficient exploration through intrinsic motivation. This takes inspiration from the psychology literature [45] which divides human motivation into extrinsic and intrinsic. Extrinsic motivation describes doing an activity to attain a reward or avoid punishment, while intrinsic rewards describe doing an activity for the sake of curiosity or doing the activity itself. Analogously, we can define the environments reward signal $e_{t}$ at timestep $t$ to be extrinsic and augment it with an intrinsic reward signal $i_{t}$. The agent then tries to maximize $r_{t}=e_{t}+i_{t}$. In the context of a sparse reward problem, the intrinsic reward can fill the gaps between the sparse extrinsic rewards, possibly giving the agent quality feedback at every timestep. In non-tabular MDPs theoretical guarantees are not provided, though, and therefore there is no agreement on an optimal definition of the best intrinsic reward. Intuitively, the intrinsic reward should guide the agent towards optimal behaviour.

An upside of intrinsic reward methods are their straightforward implementation and application. Intrinsic rewards can be used in conjunction with any RL algorithm by just providing the modified reward signal to the learning algorithm $[4,7,57]$. When the calculation of the intrinsic reward and the learning algorithm itself both scale to high dimensional states and actions, the resulting combination is applicable to large state-action spaces as well. However, increased performance is not guaranteed [4]. In the following sections, we will present different formulations of intrinsic rewards.

强化学习代写

机器学习代写|强化学习project代写reinforence learning代考|The Problem of Naive Exploration

在实践中,“探索-开发困境”经常被天真地通过抖动来解决[27,48,49]. 在连续动作空间中,将高斯噪声添加到动作中,而在离散动作空间中选择动作ε-贪婪,意味着以概率选择最优动作1−ε和有概率的随机动作ε. 这两种方法适用于随机动作序列可能会带来积极回报或“做正确的事”的环境。由于稀疏域中的奖励很少,因此获得随机正奖励的可能性很小,从而导致最坏情况下的样本复杂度在状态和动作的数量上呈指数增长[20,33,34,56]. 例如,图 1 显示了随机探索受到指数样本复杂度影响的情况。

根据经验,这个缺点可以在许多基准测试环境中观察到,例如街机学习环境 [5]。像 Montezuma’s Revenge 或 Pitfall 这样的游戏具有稀疏的奖励信号,因此具有基于抖动的探索的代理几乎什么都没学到 [27, 48]。虽然蒙特祖玛的复仇已成为困难勘探问题的标准基准,但需要强调的是,成功解决它可能并不总是智能勘探策略的良好指标。

这种糟糕的探索行为部分是由于缺乏对世界及其行为的先验假设。正如 [10] 所指出的,在蒙特祖玛的复仇(图 3)的随机版本中,人类的表现明显更差,因为他们的先验知识因随机化而减少,而对于 RL 代理,由于缺乏先验知识,因此没有差异。第一名。使用先验知识增强 RL 代理可以提供更有指导性的探索。然而,即使不使用先验,我们也可以大大改进随机探索。

一个好的探索算法应该能够解决在大型状态动作空间中具有稀疏奖励的困难探索问题,同时保持计算上的可处理性。根据[33],这样的算法有必要执行“深度探索”而不是“短视探索”。进行深度探索的代理将采取几个连贯的动作来探索,而不是仅仅在本地独立地选择最有趣的状态。这类似于智能体的一般目标:最大化未来的预期奖励,而不是下一个时间步的奖励。

机器学习代写|强化学习project代写reinforence learning代考|Optimism in the Face of Uncertainty

许多可证明有效的算法都是基于面对不确定性(OFU)[24]时的乐观主义,其中代理通过包含探索奖励而贪婪地采取行动值,这些行动值是乐观的。然后,代理要么体验到高奖励并且动作确实是最优的,要么代理体验到低奖励并且得知动作不是最优的。访问状态-动作对后,探索奖励减少。这种方法优于幼稚的方法,因为它避免了可能出现低价值和低信息增益的行为。一般来说,在代理可以无限次访问每个状态-动作对的假设下,高估会减少,并获得几乎最优的行为。由于探索奖励引入的偏差,无法获得最佳行为。大多数算法在状态、动作或水平长度的数量上达到多项式的最优。文献提供了这些算法的许多变体,这些算法使用具有不同功效或不同简化假设的边界,例如[3,6,9,19,20,22].

界限通常在一个称为可能近似正确的框架中表示(磷一种C)学习。形式上,PAC 界限由置信度参数表示d和一个精度参数εwrt 算法被证明是ε概率最优1−d在多项式时间步后1σ,1ε以及一些取决于手头的 MDP 的因素。

机器学习代写|强化学习project代写reinforence learning代考|Intrinsic Rewards

大量工作通过内在动机处理有效探索。这从心理学文献 [45] 中获得灵感,将人类动机分为外在和内在。外在动机描述了为了获得奖励或避免惩罚而进行的活动,而内在奖励描述了为了好奇或进行活动本身而进行的活动。类似地,我们可以定义环境奖励信号和吨在时间步长吨是外在的,并用内在的奖励信号来增强它一世吨. 然后代理尝试最大化r吨=和吨+一世吨. 在稀疏奖励问题的背景下,内在奖励可以填补稀疏外在奖励之间的空白,可能在每个时间步为代理提供质量反馈。但是,在非表格 MDP 中没有提供理论保证,因此没有就最佳内在奖励的最佳定义达成一致。直观地说,内在奖励应该引导智能体走向最佳行为。

内在奖励方法的一个优点是它们的直接实施和应用。内在奖励可以与任何 RL 算法结合使用,只需将修改后的奖励信号提供给学习算法[4,7,57]. 当内在奖励的计算和学习算法本身都扩展到高维状态和动作时,得到的组合也适用于大的状态-动作空间。但是,不能保证提高性能 [4]。在接下来的部分中,我们将介绍不同的内在奖励公式。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。