计算机代写|数据库作业代写SQL代考|Binning

如果你也在 怎样代写数据库SQL这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

结构化查询语言(SQL)是一种标准化的编程语言,用于管理关系型数据库并对其中的数据进行各种操作。

statistics-lab™ 为您的留学生涯保驾护航 在代写数据库SQL方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写数据库SQL代写方面经验极为丰富,各种代写数据库SQL相关的作业也就用不着说。

我们提供的数据库SQL及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

计算机代写|数据库作业代写SQL代考|Binning

Binning is useful when working with continuous values. Rather than the number of observations or records for each value being counted, ranges of values are grouped together, and these groups are called bins or buckets. The number of records that fall into each interval is then counted. Bins can be variable in size or have a fixed size, depending on whether your goal is to group the data into bins that have particular meaning for the organization, are roughly equal width, or contain roughly equal numbers of records. Bins can be created with CASE statements, rounding, and logarithms.

A CASE statement allows for conditional logic to be evaluated. These statements are very flexible, and we will come back to them throughout the book, applying them to data profiling, cleaning, text analysis, and more. The basic structure of a CASE statement is:

case when condition1 then return_value_1

when condition2 then return_value_2

else return_value_default

end

The WHEN condition can be an equality, inequality, or other logical condition. The THEN return value can be a constant, an expression, or a field in the table. Any number of conditions can be included, but the statement will stop executing and return the result the first time a condition evaluates to TRUE. ELSE tells the database what to use as a default value if no matches are found and can also be a constant or field. ELSE is optional, and if it is not included, any nonmatches will return null. CASE statements can also be nested so that the return value is another CASE statement.

计算机代写|数据库作业代写SQL代考|n-Tiles

You’re probably familiar with the median, or middle value, of a data set. This is the 50th percentile value. Half of the values are larger than the median, and the other half are smaller. With quartiles, we fill in the 25 th and 75 th percentile values. A quarter of the values are smaller and three quarters are larger for the 25 th percentile; three quarters are smaller and one quarter are larger at the 75 th percentile. Deciles break the data set into 10 equal parts. Making this concept generic, $n$-tiles allow us to calculate any percentile of the data set: 27 th percentile, $50.5$ th percentile, and so on.

Many databases have a median function built in but rely on more generic n-tile functions for the rest. These functions are window functions, computing across a range of rows to return a value for a single row. They take an argument that specifies the number of bins to split the data into and, optionally, a PARTITION BY and/or an ORDER BY clause:

ntile(num_bins) over (partition by… order by…)

As an example, imagine we had 12 transactions with order_amounts of $\$ 19.99, \$ 9.99$, $\$ 59.99, \$ 11.99, \$ 23.49, \$ 55.98, \$ 12.99, \$ 99.99, \$ 14.99, \$ 34.99, \$ 4.99$, and $\$ 89.99$. Performing an ntile calculation with 10 bins sorts each order_amount and assigns a bin from 1 to 10 :

This can be used to bin records in practice by first calculating the ntile of each row in a subquery and then wrapping it in an outer query that uses min and max to find the upper and lower boundaries of the value range:

SELECT ntile

,min(order_amount) as lower_bound

, max(order_amount) as upper_bound

, count(order_id) as orders

FROM

SELECT customer_id, order_id, order_amount

SELECT ntile

, min(order_amount) as lower_bound

, max(order_amount) as upper_bound

, count(order_id) as orders

FROM

( SELECT customer_id, order_id, order_amount

,ntile(10) over_(order by order_amount) as ntile

FROM orders a

GROUP BY 1

;

, ntile(10) over (order by order_amount) as ntile

FROM orders

) $a$

GROUP BY 1

;

A related function is percent_rank. Instead of returning the bins that the data falls into, percent_rank returns the percentile. It takes no argument but requires parentheses and optionally takes a PARTITIONBY and/or an ORDER BY clause:

percent_rank() over (partition by… order by…)

计算机代写|数据库作业代写SQL代考|Profiling: Data Quality

Data quality is absolutely critical when it comes to creating good analysis. Although this may seem obvious, it has been one of the hardest lessons I’ve learned in my years of working with data. It’s easy to get overly focused on the mechanics of processing

the data, finding clever query techniques and just the right visualization, only to have stakeholders ignore all of that and point out the one data inconsistency. Ensuring data quality can be one of the hardest and most frustrating parts of analysis. The saying “garbage in, garbage out” captures only part of the problem. Good ingredients in plus incorrect assumptions can also lead to garbage out.

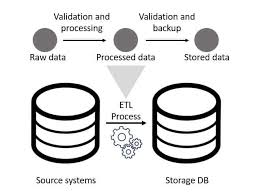

Comparing data against ground truth, or what is otherwise known to be true, is ideal though not always possible. For example, if you are working with a replica of a production database, you could compare the row counts in each system to verify that all rows arrived in the replica database. In other cases, you might know the dollar value and count of sales in a particular month and thus can query for this information in the database to make sure the sum of sales and count of records match. Often the difference between your query results and the expected value comes down to whether you applied the correct filters, such as excluding cancelled orders or test accounts; how you handled nulls and spelling anomalies; and whether you set up correct JOIN conditions between tables.

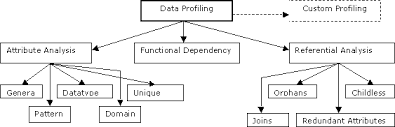

Profiling is a way to uncover data quality issues early on, before they negatively impact results and conclusions drawn from the data. Profiling reveals nulls, categorical codings that need to be deciphered, fields with multiple values that need to be parsed, and unusual datetime formats. Profiling can also uncover gaps and step changes in the data that have resulted from tracking changes or outages. Data is rarely perfect, and it’s often only through its use in analysis that data quality issues are uncuvered.

SQL代考

计算机代写|数据库作业代写SQL代考|Binning

在处理连续值时,分箱很有用。不是计算每个值的观察数或记录数,而是将值的范围分组在一起,这些组称为箱或桶。然后计算落入每个间隔的记录数。bin 的大小可以是可变的,也可以是固定大小的,具体取决于您的目标是将数据分组到对组织具有特定意义、宽度大致相等还是包含大致相等数量的记录的 bin 中。可以使用 CASE 语句、舍入和对数创建 bin。

CASE 语句允许评估条件逻辑。这些语句非常灵活,我们将在本书中反复讨论它们,将它们应用于数据分析、清理、文本分析等。CASE 语句的基本结构是:

case when condition1 then return_value_1

when condition2 then return_value_2

else return_value_default

end

WHEN 条件可以是等式、不等式或其他逻辑条件。THEN 返回值可以是常量、表达式或表中的字段。可以包含任意数量的条件,但语句将停止执行并在条件第一次评估为 TRUE 时返回结果。如果没有找到匹配项,ELSE 告诉数据库使用什么作为默认值,也可以是常量或字段。ELSE 是可选的,如果不包括在内,任何不匹配项都将返回 null。CASE 语句也可以嵌套,以便返回值是另一个 CASE 语句。

计算机代写|数据库作业代写SQL代考|n-Tiles

您可能熟悉数据集的中值或中间值。这是第 50 个百分位值。一半的值大于中位数,另一半小于中位数。使用四分位数,我们填写第 25 和第 75 个百分位值。对于第 25 个百分位数,四分之一的值较小,四分之三的值较大;在第 75 个百分位处,四分之三较小,四分之一较大。十分位数将数据集分成 10 个相等的部分。使这个概念通用,n-tiles 允许我们计算数据集的任何百分位数:第 27 个百分位数,50.5th 百分位数,以此类推。

许多数据库都内置了一个中值函数,但其余部分依赖于更通用的 n-tile 函数。这些函数是窗口函数,计算一系列行以返回单行的值。他们接受一个参数来指定将数据拆分成的 bin 数量,以及可选的 PARTITION BY 和/或 ORDER BY 子句:

ntile(num_bins) over (partition by… order by…)

例如,假设我们有12 笔 order_amounts 的交易$19.99,$9.99, $59.99,$11.99,$23.49,$55.98,$12.99,$99.99,$14.99,$34.99,$4.99, 和$89.99. 使用 10 个 bin 执行 ntile 计算对每个 order_amount 进行排序并分配一个从 1 到 10 的 bin:

这可以用于在实践中通过首先计算子查询中每一行的 ntile,然后将其包装在使用 min 和 max 来查找值范围的上限和下限的外部查询中来对记录进行分类:

SELECT ntile

,min( order_amount) as lower_bound

, max(order_amount) as upper_bound

, count(order_id) as orders

FROM

SELECT customer_id, order_id, order_amount

SELECT ntile

, min(order_amount) as lower_bound

, max(order_amount) as upper_bound

, count(order_id) as orders

FROM

( SELECT customer_id, order_id, order_amount

,ntile(10) over_(order by order_amount) as ntile

FROM orders a

GROUP BY 1

;

, ntile(10) over (order by order_amount) as ntile

FROM orders

)一个

按 1 分组

;

一个相关的函数是 percent_rank。percent_rank 不返回数据所属的 bin,而是返回百分位数。它不需要参数,但需要括号,并且可以选择使用 PARTITIONBY 和/或 ORDER BY 子句:

percent_rank() over (partition by… order by…)

计算机代写|数据库作业代写SQL代考|Profiling: Data Quality

在创建良好的分析时,数据质量绝对是至关重要的。尽管这看起来很明显,但它是我多年来处理数据中学到的最难的一课。很容易过度关注处理机制

数据,找到巧妙的查询技术和恰到好处的可视化,只是让利益相关者忽略所有这些并指出一个数据不一致。确保数据质量可能是分析中最困难和最令人沮丧的部分之一。“垃圾进,垃圾出”这句话只抓住了问题的一部分。好的成分加上不正确的假设也可能导致垃圾输出。

将数据与基本事实或其他已知真实的数据进行比较是理想的,但并非总是可能的。例如,如果您正在使用生产数据库的副本,您可以比较每个系统中的行数,以验证所有行是否都到达了副本数据库。在其他情况下,您可能知道特定月份的美元价值和销售额,因此可以在数据库中查询此信息以确保销售额总和与记录数匹配。您的查询结果与预期值之间的差异通常归结为您是否应用了正确的过滤器,例如排除已取消的订单或测试帐户;您如何处理空值和拼写异常;以及是否在表之间设置了正确的 JOIN 条件。

剖析是一种在数据质量问题对从数据得出的结果和结论产生负面影响之前及早发现的方法。分析揭示了空值、需要破译的分类编码、需要解析的具有多个值的字段以及不寻常的日期时间格式。分析还可以发现由于跟踪更改或中断而导致的数据中的差距和阶跃变化。数据很少是完美的,而且通常只有通过在分析中使用才能发现数据质量问题。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。