如果你也在 怎样代写凸优化Convex optimization 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。凸优化Convex optimization凸优化是数学优化的一个子领域,研究的是凸集上凸函数最小化的问题。许多类凸优化问题允许采用多项式时间算法,而数学优化一般来说是NP-hard。

凸优化Convex optimization是数学优化的一个子领域,研究的是凸集上凸函数最小化的问题。许多类别的凸优化问题允许采用多项式时间算法,而数学优化一般来说是NP困难的。凸优化在许多学科中都有应用,如自动控制系统、估计和信号处理、通信和网络、电子电路设计、数据分析和建模、金融、统计(最佳实验设计)、和结构优化,其中近似概念被证明是有效的。

statistics-lab™ 为您的留学生涯保驾护航 在代写凸优化Convex Optimization方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写凸优化Convex Optimization代写方面经验极为丰富,各种代写凸优化Convex Optimization相关的作业也就用不着说。

数学代写|凸优化作业代写Convex Optimization代考|Stochastic Subgradient Methods

Incremental subgradient methods are related to methods that aim to minimize an expected value

$$

f(x)=E{F(x, w)}

$$

where $w$ is a random variable, and $F(\cdot, w): \Re^n \mapsto \Re$ is a convex function for each possible value of $w$. The stochastic subgradient method for minimizing $f$ over a closed convex set $X$ is given by

$$

x_{k+1}=P_X\left(x_k-\alpha_k g\left(x_k, w_k\right)\right)

$$

where $w_k$ is a sample of $w$ and $g\left(x_k, w_k\right)$ is a subgradient of $F\left(\cdot, w_k\right)$ at $x_k$. This method has a rich theory and a long history, particularly for the case where $F(\cdot, w)$ is differentiable for each value of $w$ (for representative references, see [PoT73], [Lju77], [KuC78], [TBA86], [Pol87], [BeT89a], [BeT96], [Pf196], [LBB98], [BeT00], [KuY03], [Bot05], [BeL07], [Mey07], [Bor08], [BBG09], [Ben09], [NJL09], [Bot10], [BaM11], [DHS11], [ShZ12], [FrG13], [NSW14]). It is strongly related to the classical algorithmic field of stochastic approximation; see the books [KuC78], [BeT96], [KuY03], $[$ Spa03], [Mey07], [Bor08], [BPP13].

If we view the expected value cost $E{F(x, w)}$ as a weighted sum of cost function components, we see that the stochastic subgradient method (2.40) is related to the incremental subgradient method

$$

x_{k+1}=P_X\left(x_k-\alpha_k g_{i, k}\right)

$$

for minimizing a finite sum $\sum_{i=1}^m f_i$, when randomization is used for component selection [cf. Eq. (2.31)]. An important difference is that the former method involves sequential sampling of cost components $F(x, w)$ from an infinite population under some statistical assumptions, while in the latter the set of cost components $f_i$ is predetermined and finite. However, it is possible to view the incremental subgradient method $(2.41)$, with uniform randomized selection of the component function $f_i$ (i.e., with $i_k$ chosen to be any one of the indexes $1, \ldots, m$, with equal probability $1 / m$, and independently of preceding choices), as a stochastic subgradient method.

数学代写|凸优化作业代写Convex Optimization代考|Incremental Newton Methods

We will now consider an incremental version of Newton’s method for unconstrained minimization of an additive cost function of the form

$$

f(x)=\sum_{i=1}^m f_i(x)

$$

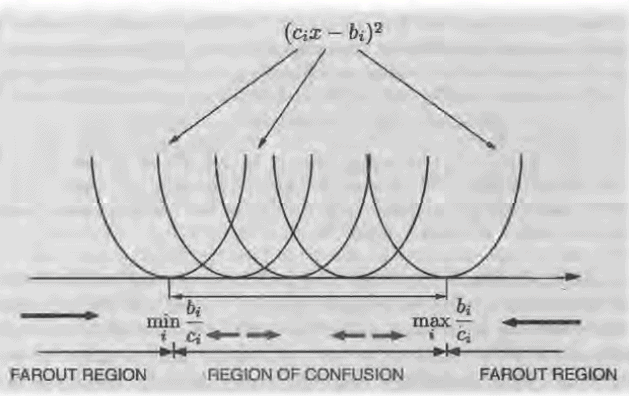

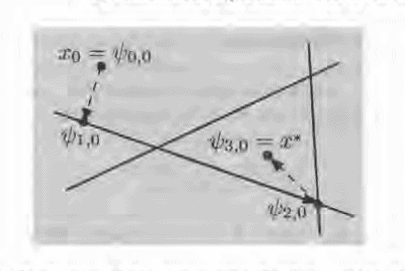

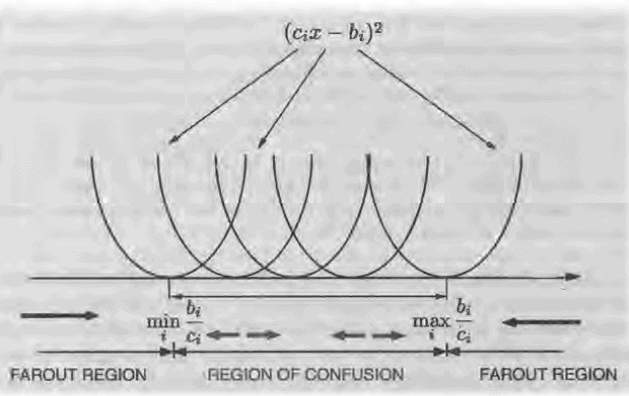

where the functions $f_i: \Re^n \mapsto \Re$ are convex and twice continuously differentiable. Consider the quadratic approximation $\tilde{f}i$ of a function $f_i$ at a vector $\psi \in \Re^n$, i.e., the second order Taylor expansion of $f_i$ at $\psi$ : $$ \tilde{f}_i(x ; \psi)=\nabla f_i(\psi)^{\prime}(x-\psi)+\frac{1}{2}(x-\psi)^{\prime} \nabla^2 f_i(\psi)(x-\psi), \quad \forall x, \psi \in \Re^n . $$ Similar to Newton’s method, which minimizes a quadratic approximation at the current point of the cost function [cf. Eq. (2.14)], the incremental form of Newton’s method minimizes a sum of quadratic approximations of components. Similar to the incremental gradient method, we view an iteration as a cycle of $m$ subiterations, each involving a single additional component $f_i$, and its gradient and Hessian at the current point within the cycle. In particular, if $x_k$ is the vector obtained after $k$ cycles, the vector $x{k+1}$ obtained after one more cycle is

$$

x_{k+1}=\psi_{m, k}

$$

where starting with $\psi_{0, k}=x_k$, we obtain $\psi_{m, k}$ after the $m$ steps

$$

\psi_{i, k} \in \arg \min {x \in \Re^n} \sum{\ell=1}^i \tilde{f}{\ell}\left(x ; \psi{\ell-1, k}\right), \quad i=1, \ldots, m

$$

凸优化代写

数学代写|凸优化作业代写Convex Optimization代考|Stochastic Subgradient Methods

增量亚梯度方法与旨在使期望值最小化的方法有关

$$

f(x)=E{F(x, w)}

$$

其中$w$为随机变量,$F(\cdot, w): \Re^n \mapsto \Re$为$w$的每个可能值的凸函数。在封闭凸集$X$上最小化$f$的随机次梯度方法由

$$

x_{k+1}=P_X\left(x_k-\alpha_k g\left(x_k, w_k\right)\right)

$$

其中$w_k$是$w$的一个样本,$g\left(x_k, w_k\right)$是$F\left(\cdot, w_k\right)$在$x_k$的一个亚梯度。该方法具有丰富的理论和悠久的历史,特别是对于$F(\cdot, w)$对于$w$的每个值都是可微的情况(代表性参考文献:[PoT73], [Lju77], [KuC78], [TBA86], [Pol87], [BeT89a], [BeT96], [Pf196], [LBB98], [BeT00], [KuY03], [Bot05], [BeL07], [Mey07], [Bor08], [BBG09], [Ben09], [NJL09], [Bot10], [BaM11], [DHS11], [ShZ12], [FrG13], [NSW14])。它与经典的随机逼近算法领域密切相关;参见[KuC78], [BeT96], [KuY03], $[$ Spa03], [Mey07], [Bor08], [BPP13]。

如果我们将期望值成本$E{F(x, w)}$视为成本函数组件的加权和,我们可以看到随机亚梯度方法(2.40)与增量亚梯度方法相关

$$

x_{k+1}=P_X\left(x_k-\alpha_k g_{i, k}\right)

$$

对于最小化有限和$\sum_{i=1}^m f_i$,当随机化用于组件选择时[参见式(2.31)]。一个重要的区别是,前一种方法涉及在一些统计假设下从无限人口中顺序抽样成本成分$F(x, w)$,而在后一种方法中,成本成分集$f_i$是预先确定的和有限的。但是,增量亚梯度方法$(2.41)$可以看作是随机的亚梯度方法,它对分量函数$f_i$进行均匀的随机选择(即,$i_k$被选为任意一个指标$1, \ldots, m$,具有相同的概率$1 / m$,并且独立于前面的选择)。

数学代写|凸优化作业代写Convex Optimization代考|Incremental Newton Methods

我们现在将考虑牛顿方法的增量版本,用于无约束最小化形式的附加成本函数

$$

f(x)=\sum_{i=1}^m f_i(x)

$$

这里的函数$f_i: \Re^n \mapsto \Re$是凸的两次连续可微的。考虑一个函数$f_i$在矢量$\psi \in \Re^n$处的二次逼近$\tilde{f}i$,即$f_i$在$\psi$: $$ \tilde{f}i(x ; \psi)=\nabla f_i(\psi)^{\prime}(x-\psi)+\frac{1}{2}(x-\psi)^{\prime} \nabla^2 f_i(\psi)(x-\psi), \quad \forall x, \psi \in \Re^n . $$处的二阶泰勒展开。类似于牛顿方法,它最小化了成本函数当前点的二次逼近[参见公式(2.14)],牛顿方法的增量形式最小化了分量的二次逼近之和。与增量梯度方法类似,我们将迭代视为$m$子迭代的循环,每个子迭代都涉及一个单独的附加组件$f_i$,以及它在循环内当前点的梯度和Hessian。其中,如果$x_k$为$k$次循环后得到的向量,则再经过一次循环后得到的向量$x{k+1}$为 $$ x{k+1}=\psi_{m, k}

$$

从$\psi_{0, k}=x_k$开始,我们在$m$步骤之后得到$\psi_{m, k}$

$$

\psi_{i, k} \in \arg \min {x \in \Re^n} \sum{\ell=1}^i \tilde{f}{\ell}\left(x ; \psi{\ell-1, k}\right), \quad i=1, \ldots, m

$$

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。