统计代写|统计推断作业代写statistics interference代考| Exponential family

如果你也在 怎样代写统计推断statistics interference这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

统计推断是利用数据分析来推断概率基础分布的属性的过程。 推断性统计分析推断人口的属性,例如通过测试假设和得出估计值。

statistics-lab™ 为您的留学生涯保驾护航 在代写统计推断statistics interference方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写统计推断statistics interference方面经验极为丰富,各种代写统计推断statistics interference相关的作业也就用不着说。

我们提供的属性统计推断statistics interference及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|统计推断作业代写statistics interference代考|Exponential family

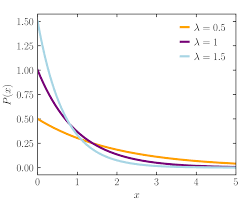

We now consider a family of models that are important both because they have relatively simple properties and because they capture in one discussion many,

although by no means all, of the inferential properties connected with important standard distributions, the binomial, Poisson and geometric distributions and the normal and gamma distributions, and others too.

Suppose that $\theta$ takes values in a well-behaved region in $R^{d}$, and not of lower dimension, and that we can find a $(d \times 1)$-dimensional statistic $s$ and a parameterization $\phi$, i.e., a $(1,1)$ transformation of $\theta$, such that the model has the form

$$

m(y) \exp \left{s^{T} \phi-k(\phi)\right}

$$

where $s=s(y)$ is a function of the data. Then $S$ is sufficient; subject to some important regularity conditions this is called a regular or full $(d, d)$ exponential family of distributions. The statistic $S$ is called the canonical statistic and $\phi$ the canonical parameter. The parameter $\eta=E(S ; \phi)$ is called the mean parameter. Because the stated function defines a distribution, it follows that

$$

\begin{aligned}

&\int m(y) \exp \left{s^{T} \phi-k(\phi)\right} d y=1 \

&\int m(y) \exp \left{s^{T}(\phi+p)-k(\phi+p)\right} d y=1 .

\end{aligned}

$$

Hence, noting that $s^{T} p=p^{T} s$, we have from (2.11) that the moment generating function of $S$ is

$$

E\left{\exp \left(p^{T} S\right)\right}=\exp {k(\phi+p)-k(\phi)}

$$

Therefore the cumulant generating function of $S$, defined as the log of the moment generating function, is

$$

k(\phi+p)-k(\phi),

$$

providing a fairly direct interpretation of the function $k$ (.). Because the mean is given by the first derivatives of that generating function, we have that $\eta=$ $\nabla k(\phi)$, where $\nabla$ is the gradient operator $\left(\partial / \partial \phi_{1}, \ldots, \partial / \partial \phi_{d}\right)^{T}$. See Note $2.3$ for a brief account of both cumulant generating functions and the $\nabla$ notation.

Example 2.5. Binomial distribution. If $R$ denotes the number of successes in $n$ independent binary trials each with probability of success $\pi$, its density can be written

$$

n ! /{r !(n-r) !}^{\pi r}(1-\pi)^{n-r}=m(r) \exp \left{r \phi-n \log \left(1+e^{\phi}\right)\right},

$$

say, where $\phi=\log {\pi /(1-\pi)}$, often called the $\log$ odds, is the canonical parameter and $r$ the canonical statistic. Note that the mean parameter is $E(R)=$ $n \pi$ and can be recovered also by differentiating $k(\phi)$.

统计代写|统计推断作业代写statistics interference代考|Choice of priors for exponential family problems

While in Bayesian theory choice of prior is in principle not an issue of achieving mathematical simplicity, nevertheless there are gains in using reasonably simple and flexible forms. In particular, if the likelihood has the full exponential family form

$$

m(y) \exp \left{s^{T} \phi-k(\phi)\right}

$$

a prior for $\phi$ proportional to

$$

\exp \left{s_{0}^{T} \phi-a_{0} k(\phi)\right}

$$

leads to a posterior proportional to

$$

\exp \left{\left(s+s_{0}\right)^{T} \phi-\left(1+a_{0}\right) k(\phi)\right}

$$

Such a prior is called conjugate to the likelihood, or sometimes closed under sampling. The posterior distribution has the same form as the prior with $s_{0}$ replaced by $s+s_{0}$ and $a_{0}$ replaced by $1+a_{0}$.

Example 2.8. Binomial distribution (ctd). This continues the discussion of Example 2.5. If the prior for $\pi$ is proportional to

$$

\pi^{r_{0}}(1-\pi)^{n_{0}-r_{0}}

$$

i.e., is a beta distribution, then the posterior is another beta distribution corresponding to $r+r_{0}$ successes in $n+n_{0}$ trials. Thus both prior and posterior are beta distributions. It may help to think of $\left(r_{0}, n_{0}\right)$ as fictitious data! If the prior information corresponds to fairly small values of $n_{0}$ its effect on the conclusions will be small if the amount of real data is appreciable.

统计代写|统计推断作业代写statistics interference代考|Simple frequentist discussion

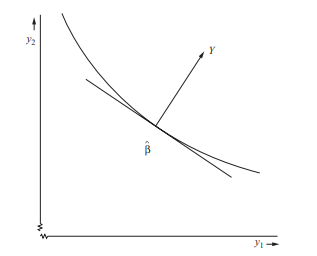

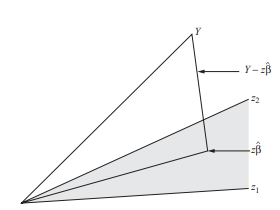

In Bayesian approaches sufficiency arises as a convenient simplification of the likelihood; whatever the prior the posterior is formed from the likelihood and hence depends on the data only via the sufficient statistic.

In frequentist approaches the issue is more complicated. Faced with a new model as the basis for analysis, we look for a Fisherian reduction, defined as follows:

- find the likelihood function;

- reduce to a sufficient statistic $S$ of the same dimension as $\theta$;

- find a function of $S$ that has a distribution depending only on $\psi$;

- invert that distribution to obtain limits for $\psi$ at an arbitrary set of probability levels;

- use the conditional distribution of the data given $S=s$ informally or formally to assess the adequacy of the formulation.

Immediate application is largely confined to regular exponential family models. While most of our discussion will centre on inference about the parameter of interest, $\psi$, the complementary role of sufficiency of providing an explicit base for model checking is in principle very important. It recognizes that our formulations are always to some extent provisional, and usually capable to some extent of empirical check; the universe of discussion is not closed. In general there is no specification of what to do if the initial formulation is inadequate but, while that might sometimes be clear in broad outline, it seems both in practice and in principle unwise to expect such a specification to be set out in detail in each application.

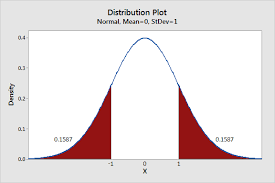

The next phase of the analysis is to determine how to use $s$ to answer more focused questions, for example about the parameter of interest $\psi$. The simplest possibility is that there are no nuisance parameters, just a single parameter $\psi$ of interest, and reduction to a single component $s$ occurs. We then have one observation on a known density $f_{S}(s ; \psi)$ and distribution function $F_{S}(s ; \psi)$. Subject to some monotonicity conditions which, in applications, are typically satisfied, the probability statement

$$

P\left(S \leq a_{c}(\psi)\right)=F_{S}\left(a_{c}(\psi) ; \psi\right)=1-c

$$

can be inverted for continuous random variables into

$$

P\left{\psi \leq b_{c}(S)\right}=1-c

$$

Thus the statement on the basis of data $y$, yielding sufficient statistic $s$, that

$$

\psi \leq b_{c}(s)

$$provides an upper bound for $\psi$, that is a single member of a hypothetical long run of statements a proportion $1-c$ of which are true, generating a set of statements in principle at all values of $c$ in $(0,1)$.

属性数据分析

统计代写|统计推断作业代写statistics interference代考|Exponential family

我们现在考虑一系列重要的模型,因为它们具有相对简单的属性,并且因为它们在一次讨论中捕获了许多,

尽管绝不是所有与重要标准分布、二项式分布、泊松分布和几何分布以及正态分布和伽马分布等相关的推理性质。

假设θ在行为良好的区域中取值Rd,而不是低维,我们可以找到一个(d×1)维统计s和参数化φ,即一个(1,1)的转变θ,使得模型具有形式

m(y) \exp \left{s^{T} \phi-k(\phi)\right}m(y) \exp \left{s^{T} \phi-k(\phi)\right}

在哪里s=s(是)是数据的函数。然后小号足够了; 根据一些重要的规律性条件,这被称为规律性或完全性(d,d)指数分布族。统计数据小号称为典型统计量,并且φ规范参数。参数这=和(小号;φ)称为均值参数。因为所述函数定义了一个分布,所以它遵循

\begin{对齐} &\int m(y) \exp \left{s^{T} \phi-k(\phi)\right} d y=1 \ &\int m(y) \exp \left{s ^{T}(\phi+p)-k(\phi+p)\right} d y=1 。\end{对齐}\begin{对齐} &\int m(y) \exp \left{s^{T} \phi-k(\phi)\right} d y=1 \ &\int m(y) \exp \left{s ^{T}(\phi+p)-k(\phi+p)\right} d y=1 。\end{对齐}

因此,注意到s吨p=p吨s, 我们从 (2.11) 得到矩生成函数小号是

E\left{\exp \left(p^{T} S\right)\right}=\exp {k(\phi+p)-k(\phi)}E\left{\exp \left(p^{T} S\right)\right}=\exp {k(\phi+p)-k(\phi)}

因此,累积生成函数小号,定义为矩生成函数的对数,是

到(φ+p)−到(φ),

提供对功能的相当直接的解释到(.)。因为均值是由该生成函数的一阶导数给出的,所以我们有这= ∇到(φ), 在哪里∇是梯度算子(∂/∂φ1,…,∂/∂φd)吨. 见说明2.3简要说明累积量生成函数和∇符号。

例 2.5。二项分布。如果R表示成功的次数n独立的二元试验,每个试验都有成功的概率圆周率, 它的密度可以写成

!/{r !(nr) !}^{\pi r}(1-\pi)^{nr}=m(r) \exp \left{r \phi-n \log \left(1+e^{ \phi}\right)\right},!/{r !(nr) !}^{\pi r}(1-\pi)^{nr}=m(r) \exp \left{r \phi-n \log \left(1+e^{ \phi}\right)\right},

说,在哪里φ=日志圆周率/(1−圆周率),通常称为日志几率,是规范参数,并且r典型统计量。请注意,平均参数是和(R)= n圆周率也可以通过微分恢复到(φ).

统计代写|统计推断作业代写statistics interference代考|Choice of priors for exponential family problems

虽然在贝叶斯理论中,先验的选择原则上不是实现数学简单性的问题,但是使用相当简单和灵活的形式是有好处的。特别是,如果可能性具有完整的指数族形式

m(y) \exp \left{s^{T} \phi-k(\phi)\right}m(y) \exp \left{s^{T} \phi-k(\phi)\right}

先验φ成正比

\exp \left{s_{0}^{T} \phi-a_{0} k(\phi)\right}\exp \left{s_{0}^{T} \phi-a_{0} k(\phi)\right}

导致后验比例

\exp \left{\left(s+s_{0}\right)^{T} \phi-\left(1+a_{0}\right) k(\phi)\right}\exp \left{\left(s+s_{0}\right)^{T} \phi-\left(1+a_{0}\right) k(\phi)\right}

这样的先验被称为可能性的共轭,或者有时在采样下关闭。后验分布具有与先验相同的形式s0取而代之s+s0和一种0取而代之1+一种0.

例 2.8。二项分布 (ctd)。这将继续对示例 2.5 的讨论。如果先于圆周率正比于

圆周率r0(1−圆周率)n0−r0

即,是一个β分布,那么后验是另一个β分布对应于r+r0成功n+n0试验。因此,先验和后验都是 beta 分布。想一想可能会有所帮助(r0,n0)作为虚构数据!如果先验信息对应于相当小的值n0如果实际数据量可观,它对结论的影响将很小。

统计代写|统计推断作业代写statistics interference代考|Simple frequentist discussion

在贝叶斯方法中,充分性作为可能性的方便简化而出现;无论先验后验是由可能性形成的,因此仅通过足够的统计量依赖于数据。

在频率论方法中,这个问题更加复杂。面对一个新模型作为分析的基础,我们寻找Fisherian约简,定义如下:

- 找到似然函数;

- 减少到足够的统计量小号尺寸相同θ;

- 找到一个函数小号它的分布仅取决于ψ;

- 反转该分布以获得限制ψ在任意一组概率水平上;

- 使用给定数据的条件分布小号=s非正式或正式地评估配方的充分性。

即时应用主要限于常规指数族模型。虽然我们的大部分讨论将集中在对感兴趣参数的推断上,ψ,为模型检查提供明确基础的充分性的补充作用原则上非常重要。它承认我们的公式在某种程度上总是临时的,并且通常能够在某种程度上进行经验检查;讨论的范围不是封闭的。一般来说,如果最初的表述不充分,没有具体说明该怎么做,虽然有时可能很清楚,但在实践和原则上,期望这样的说明在每篇文章中都详细列出似乎是不明智的。应用。

分析的下一阶段是确定如何使用s回答更有针对性的问题,例如关于感兴趣的参数ψ. 最简单的可能是没有讨厌的参数,只有一个参数ψ感兴趣,并减少到单个组件s发生。然后我们对已知密度进行一次观察F小号(s;ψ)和分布函数F小号(s;ψ). 受限于在应用中通常满足的一些单调性条件,概率陈述

磷(小号≤一种C(ψ))=F小号(一种C(ψ);ψ)=1−C

可以将连续随机变量反转为

P\left{\psi \leq b_{c}(S)\right}=1-cP\left{\psi \leq b_{c}(S)\right}=1-c

因此,基于数据的声明是, 产生足够的统计量s, 那

ψ≤bC(s)提供了一个上限ψ, 那是假设的长期陈述的单个成员 a 比例1−C其中是正确的,原则上在所有值下生成一组陈述C在(0,1).

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。统计代写|python代写代考

随机过程代考

在概率论概念中,随机过程是随机变量的集合。 若一随机系统的样本点是随机函数,则称此函数为样本函数,这一随机系统全部样本函数的集合是一个随机过程。 实际应用中,样本函数的一般定义在时间域或者空间域。 随机过程的实例如股票和汇率的波动、语音信号、视频信号、体温的变化,随机运动如布朗运动、随机徘徊等等。

贝叶斯方法代考

贝叶斯统计概念及数据分析表示使用概率陈述回答有关未知参数的研究问题以及统计范式。后验分布包括关于参数的先验分布,和基于观测数据提供关于参数的信息似然模型。根据选择的先验分布和似然模型,后验分布可以解析或近似,例如,马尔科夫链蒙特卡罗 (MCMC) 方法之一。贝叶斯统计概念及数据分析使用后验分布来形成模型参数的各种摘要,包括点估计,如后验平均值、中位数、百分位数和称为可信区间的区间估计。此外,所有关于模型参数的统计检验都可以表示为基于估计后验分布的概率报表。

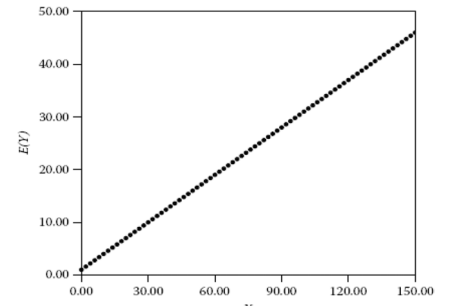

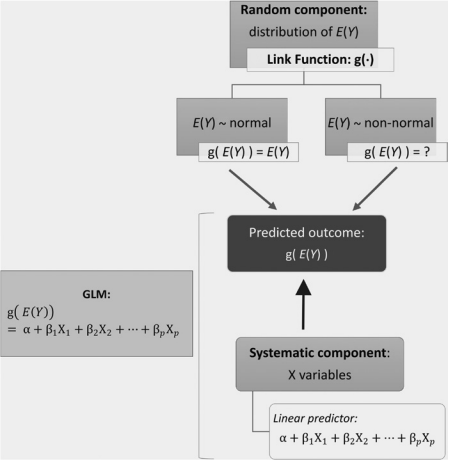

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

statistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

机器学习代写

随着AI的大潮到来,Machine Learning逐渐成为一个新的学习热点。同时与传统CS相比,Machine Learning在其他领域也有着广泛的应用,因此这门学科成为不仅折磨CS专业同学的“小恶魔”,也是折磨生物、化学、统计等其他学科留学生的“大魔王”。学习Machine learning的一大绊脚石在于使用语言众多,跨学科范围广,所以学习起来尤其困难。但是不管你在学习Machine Learning时遇到任何难题,StudyGate专业导师团队都能为你轻松解决。

多元统计分析代考

基础数据: $N$ 个样本, $P$ 个变量数的单样本,组成的横列的数据表

变量定性: 分类和顺序;变量定量:数值

数学公式的角度分为: 因变量与自变量

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。