如果你也在 怎样代写应用统计applied statistics这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

应用统计学包括计划收集数据,管理数据,分析、解释和从数据中得出结论,以及利用分析结果确定问题、解决方案和机会。本专业培养学生在数据分析和实证研究方面的批判性思维和解决问题的能力。

statistics-lab™ 为您的留学生涯保驾护航 在代写应用统计applied statistics方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写应用统计applied statistics代写方面经验极为丰富,各种代写应用统计applied statistics相关的作业也就用不着说。

我们提供的应用统计applied statistics及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|应用统计代写applied statistics代考|Basic Statistical Analyses using R

The purpose of this chapter is to introduce you to some basic statistical analyses using $R$. This chapter assumes you are using the RxP.clean dataset that was created in the Chapter 3 .

We will cover the following topics:

- Assessing data normality

- Some basic non-parametric statistics

- Student’s t-test

- One-way Analysis of Variance (ANOVA)

- We have now seen how to use a function like qplot() to look at your data in various ways. For example, you can plot a histogram of your response variable and see how it is distributed. However, as you move beyond the initial steps of data exploration and start to think about data analysis, there are several questions you should ask yourself. The most important of which is just what kind of data do you have?

This might seem like a simple question at first, but it is paramount for determining the analyses you will conduct. When we talk about data, are we talking about your response or your predictor variables? The answer is both of course. Knowing the shape of your response and predictor variables will determine what sort of analysis you do. In addition to simply knowing if the data are normal or not, you should be mindful of if you have one predictor or multiple predictors, and if your predictors are continuous (a bunch of numbers) or discrete (different categories). For this chapter and the next, we will just concern ourselves with analyzing data where the response variable is normally distributed.

统计代写|应用统计代写applied statistics代考|AVOIDING PSEUDOREPLICATION

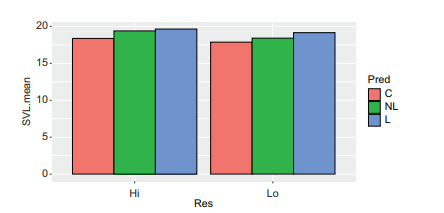

Although we have data on nearly 2500 individual metamorphs, those data are not all independent from one another. This is because groups of tadpoles were raised in common environments (the mesocosms, aka tanks) and variation between tanks may make certain individuals more similar than others. If we treat all individuals as independent, we are committing pseudoreplication, which is when you artificially inflate your sample size of independent observations. This was first mentioned in Chapter 2 , but for more details, see the classic article Hurlbert, S.H. 1984. “Pseudoreplication and the design of ecological field experiments.” Ecological Monographs $54(2): 187-211$. It’s a little long, but it’s a great read!

One easy way to avoid pseudoreplication is to utilize the mean value for each tank instead of that of individuals. We can summarize our entire dataset with relative ease using the summarize() function that was introduced in Chapter 3. We will have to get rid of column 1 on Individual ID and column 3 which shows the tank within each block because those would not be meaningful to average at the tank level. Recall that in order to use summarize() we first: 1) define our dataset, then 2) define the different variables we want to group our data by with the group_by() function, and lastly 3) use summarize() to create the variables that are the mean values from the raw dataset. At each of the three steps you pipe your data from one line to the next. You could also use the aggregate() function by defining the 7 columns to summarize (our response variables) and binding them together in a single object using the function cbind(), which binds two or more columns together, then give it the various predictor variables we want to use to summarize the data. Here, we will use summarize(), which just makes more sense. Recall that these functions are found in the dplyr package.

One other thing to notice in the following code is that there are more variables than necessary in the group_by() function. All we need to uniquely identify each tank is the variable “Tank.Unique” or the three treatments in combination. Including all of them, as well as the “Block” variable, we will merely carry more columns through to our new summarized dataset. Lastly, notice that we are storing the output of this set of code as a new object called “RxP.byTank.”

统计代写|应用统计代写applied statistics代考|Looking at the data

The first and easiest thing to do if you want to see if your data are normal or not is to plot the histogram of values. You could use either the hist() function or the $q$ plot() function found in the ggplot2 package. Either way, a histogram should give you a general sense of what your data look like. Remember that data which are normally distributed will have a relatively even spread of values above and below the mean, like that shown in Figure 5.1. Let’s look at the variables “Age.FromEmergence” and “SVL.final” and plot them using qplot() from the ggplot2 package. Remember, you have to load the package first using the library() function. Notice in the following code that we can use the “bins=” argument to specify how fine we want the histogram to break up the data. Also notice I’ve loaded the package cowplot which contains the function plot_grid() which allows us to plot multiple different figures together in a single window.

Looking at these two histograms (Figure $5.2$ ) is quite informative. The SVL data appear almost normal, although the data have a slight tail to the right. The Age data are, however, very skewed; most individuals emerged very early in the period of metamorphosis, but the tail is very long with individuals still emerging from tanks more than 100 days after the first metamorphs. Many biological patterns can be made normal with logtransformation, so a good first step is to see what effect that has on our data. Data that can be made normal upon log-transformation are referred to as “lognormal.” As we explored in Chapter 3, plotting data as a density plot can also be useful, and so both will now be shown in Figure 5.3.

应用统计代写

统计代写|应用统计代写applied statistics代考|Basic Statistical Analyses using R

本章的目的是向您介绍一些基本的统计分析,使用R. 本章假设您使用的是在第 3 章中创建的 RxP.clean 数据集。

我们将涵盖以下主题:

- 评估数据正态性

- 一些基本的非参数统计

- 学生 t 检验

- 单因素方差分析 (ANOVA)

- 我们现在已经了解了如何使用 qplot() 之类的函数以各种方式查看数据。例如,您可以绘制响应变量的直方图并查看其分布情况。但是,当您超越数据探索的初始步骤并开始考虑数据分析时,您应该问自己几个问题。其中最重要的是您拥有什么样的数据?

乍一看,这似乎是一个简单的问题,但它对于确定您将进行的分析至关重要。当我们谈论数据时,我们是在谈论您的反应还是您的预测变量?答案当然是两者。了解响应变量和预测变量的形状将决定您进行何种分析。除了简单地知道数据是否正常之外,您还应该注意您是否有一个或多个预测变量,以及您的预测变量是连续的(一堆数字)还是离散的(不同的类别)。对于本章和下一章,我们将只关注分析响应变量正态分布的数据。

统计代写|应用统计代写applied statistics代考|AVOIDING PSEUDOREPLICATION

尽管我们拥有近 2500 个单独变质的数据,但这些数据并非都相互独立。这是因为蝌蚪群是在普通环境(中宇宙,又名坦克)中饲养的,而坦克之间的差异可能会使某些个体比其他个体更相似。如果我们将所有个体视为独立个体,我们就是在进行伪复制,即人为地夸大独立观察的样本量。这在第 2 章中首次提到,但更多详细信息,请参阅经典文章 Hurlbert, SH 1984。“Pseudoreplication and the design of eco field Experiments”。生态专着54(2):187−211. 有点长,但是读起来很不错!

避免伪复制的一种简单方法是利用每个坦克的平均值而不是个体的平均值。我们可以使用第 3 章中介绍的 summarise() 函数相对轻松地总结我们的整个数据集。我们将不得不去掉关于个人 ID 的第 1 列和显示每个块内的坦克的第 3 列,因为这些没有意义平均在油箱液位。回想一下,为了使用 summarise(),我们首先:1) 定义我们的数据集,然后 2) 使用 group_by() 函数定义我们想要分组数据的不同变量,最后 3) 使用 summarise() 创建来自原始数据集的平均值的变量。在这三个步骤中的每一个步骤中,您都将数据从一行传输到下一行。您还可以通过定义 7 列来汇总(我们的响应变量)并使用函数 cbind() 将它们绑定到单个对象中来使用 aggregate() 函数,该函数将两个或更多列绑定在一起,然后给它各种预测器我们想用来总结数据的变量。在这里,我们将使用 summarise(),这更有意义。回想一下,这些函数可以在 dplyr 包中找到。

在下面的代码中要注意的另一件事是 group_by() 函数中的变量多于必要的变量。我们需要唯一标识每个坦克的是变量“Tank.Unique”或三种处理的组合。包括所有这些,以及“块”变量,我们只会将更多列带到我们的新汇总数据集中。最后,请注意我们将这组代码的输出存储为一个名为“RxP.byTank”的新对象。

统计代写|应用统计代写applied statistics代考|Looking at the data

如果您想查看您的数据是否正常,首先也是最简单的事情是绘制值的直方图。您可以使用 hist() 函数或qggplot2 包中的 plot() 函数。无论哪种方式,直方图都应该让您大致了解数据的外观。请记住,正态分布的数据在平均值上方和下方的值分布相对均匀,如图 5.1 所示。让我们看一下变量“Age.FromEmergence”和“SVL.final”,并使用 ggplot2 包中的 qplot() 绘制它们。请记住,您必须首先使用 library() 函数加载包。请注意,在下面的代码中,我们可以使用“bins=”参数来指定我们希望直方图分解数据的精细程度。还要注意我已经加载了包含函数 plot_grid() 的包cowplot,它允许我们在一个窗口中一起绘制多个不同的图形。

查看这两个直方图(图5.2) 信息量很大。SVL 数据看起来几乎正常,尽管数据向右有轻微的尾部。然而,年龄数据非常倾斜;大多数个体在变态期很早就出现了,但尾巴很长,在第一次变态后 100 多天后个体仍然从坦克中出现。许多生物模式可以通过对数转换变得正常,所以第一步是看看它对我们的数据有什么影响。在对数转换后可以正常化的数据称为“对数正态”。正如我们在第 3 章中所探讨的,将数据绘制为密度图也很有用,因此现在两者都将显示在图 5.3 中。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。