如果你也在 怎样代写回归分析Regression Analysis 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。回归分析Regression Analysis回归中的概率观点具体体现在给定X数据的特定固定值的Y数据的可变性模型中。这种可变性是用条件分布建模的;因此,副标题是:“条件分布方法”。回归的整个主题都是用条件分布来表达的;这种观点统一了不同的方法,如经典回归、方差分析、泊松回归、逻辑回归、异方差回归、分位数回归、名义Y数据模型、因果模型、神经网络回归和树回归。所有这些都可以方便地用给定特定X值的Y条件分布模型来看待。

回归分析Regression Analysis条件分布是回归数据的正确模型。它们告诉你,对于变量X的给定值,可能存在可观察到的变量Y的分布。如果你碰巧知道这个分布,那么你就知道了你可能知道的关于响应变量Y的所有信息,因为它与预测变量X的给定值有关。与基于R^2统计量的典型回归方法不同,该模型解释了100%的潜在可观察到的Y数据,后者只解释了Y数据的一小部分,而且在假设几乎总是被违反的情况下也是不正确的。

statistics-lab™ 为您的留学生涯保驾护航 在代写回归分析Regression Analysis方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写回归分析Regression Analysis代写方面经验极为丰富,各种代写回归分析Regression Analysis相关的作业也就用不着说。

统计代写|回归分析作业代写Regression Analysis代考|The Adjusted R-Squared Statistic

Recall that, in the classical model, $\Omega^2=1-\sigma^2 / \sigma_Y^2$, and that the standard $R^2$ statistic replaces the two variances with their maximum likelihood estimates. Recall also that maximum likelihood estimates of variance are biased. With a larger number of predictor variables (i.e., larger $k$ ), the estimate $\hat{\sigma}^2=$ SSE $/ n$ becomes increasingly biased downward, implying in turn that the ordinary $R^2$ becomes increasingly biased upward.

Replacing the two variances with their unbiased estimates gives the adjusted $R^2$ statistic:

$$

R_a^2=1-{\mathrm{SSE} /(n-k-1)} /{\mathrm{SST} /(n-1)}

$$

The adjusted $R^2$ statistic is still biased as an estimator of $\Omega^2=1-\sigma^2 / \sigma_Y^2$ because of Jensen’s inequality, but it is less biased than the ordinary $R^2$ statistic. You can interpret the adjusted $R^2$ statistic in the same way as the ordinary one.

Which estimate is best, adjusted $R^2$ or ordinary $R^2$ ? You guessed it: Use simulation to find out. Despite its reduced bias, the adjusted $R^2$ is not necessarily closer to the true $\Omega^2$, as simulations will show. In addition, the adjusted $R^2$ statistic can be less than 0.0 , which is clearly undesirable. The ordinary $R^2$, like the estimand $\Omega^2$, always lies between 0 and 1 (inclusive).

The following $R$ code locates these $R^2$ statistics in the $1 \mathrm{~m}$ output, and computes them “by hand” as well, using the model where Car Sales is predicted using a quadratic function of Interest Rate.

统计代写|回归分析作业代写Regression Analysis代考|The $F$ Test

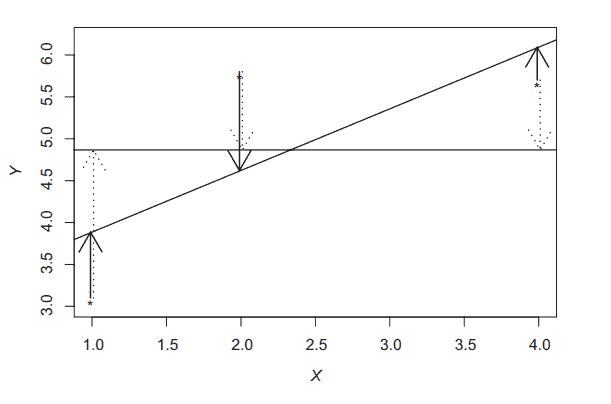

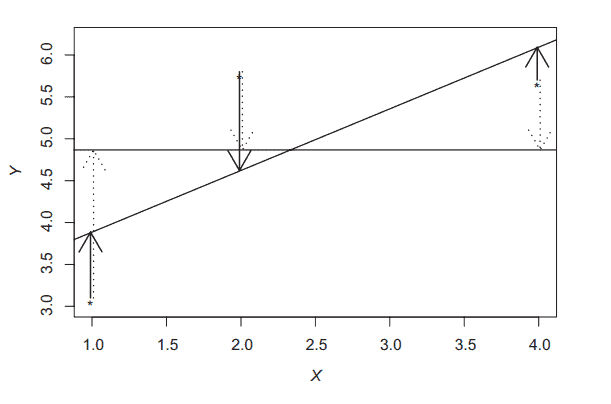

See the $\mathrm{R}$ output a few lines above: Underneath the $R^2$ statistic is the $F$-statistic. This statistic is related to the $R^2$ statistic in that it is also a function of SST and SSE (review Figure 8.2). It is given by

$$

F={(\mathrm{SST}-\mathrm{SSE}) / k} /{\mathrm{SSE} /(n-k-1)}

$$

If you add the line ((SST-SSE)/2)/(SSE/(n-3)) to the $\mathrm{R}$ code above, you will get the reported $F$-statistic, although with more decimals: 62.21945.

With a little algebra, you can relate the $F$-statistic directly to the $R^2$ statistic, showing that for fixed $k$ and $n$, larger $R^2$ corresponds to larger $F$ :

$$

F={(n-k-1) / k} \times R^2 /\left(1-R^2\right)

$$

Self-study question: Why is the equation relating $F$ to $R^2$ true?

The $F$-statistic is used to test the global null hypothesis $\mathrm{H}0: \beta_1=\beta_2=\ldots=\beta_k=0$, which states that none of the regression variables $X_1, X_2, \ldots$, or $X_k$ is related to $Y$. Under the classical model where $\mathrm{H}_0: \beta_1=\beta_2=\ldots=\beta_k=0$ is true, the $F$-statistic has a precise and well-known distribution. Distribution of the $F$-statistic under the classical model where $\beta_1=\beta_2=\ldots=\beta_k=0$ $$ F \sim F{k, n-k-1}

$$

where $F_{k, n-k-1}$ is the $F$ distribution with $k$ numerator degrees of freedom and $n-k-1$ denominator degrees of freedom.

回归分析代写

统计代写|回归分析作业代写Regression Analysis代考|The Adjusted R-Squared Statistic

回想一下,在经典模型$\Omega^2=1-\sigma^2 / \sigma_Y^2$中,标准$R^2$统计量用它们的最大似然估计替换了两个方差。还记得方差的最大似然估计是有偏的。随着预测变量数量的增加(即$k$的增大),估计的$\hat{\sigma}^2=$ SSE $/ n$越来越偏向于向下,这反过来意味着普通的$R^2$越来越偏向于向上。

用它们的无偏估计值替换这两个方差,得到调整后的$R^2$统计量:

$$

R_a^2=1-{\mathrm{SSE} /(n-k-1)} /{\mathrm{SST} /(n-1)}

$$

由于Jensen不等式,调整后的$R^2$统计量作为$\Omega^2=1-\sigma^2 / \sigma_Y^2$的估计量仍然有偏倚,但它比普通的$R^2$统计量偏倚小。您可以用与普通统计数据相同的方式解释调整后的$R^2$统计数据。

哪一个估计是最好的,调整$R^2$还是普通$R^2$ ?你猜对了:用模拟来找出答案。尽管偏差减少了,但调整后的$R^2$并不一定更接近真实的$\Omega^2$,正如模拟将显示的那样。此外,调整后的$R^2$统计值可能小于0.0,这显然是不希望看到的。普通的$R^2$和估计的$\Omega^2$一样,总是在0和1之间(含0和1)。

下面的$R$代码在$1 \mathrm{~m}$输出中找到这些$R^2$统计数据,并使用使用利率的二次函数预测汽车销售的模型“手工”计算它们。

统计代写|回归分析作业代写Regression Analysis代考|The $F$ Test

请参阅上面几行$\mathrm{R}$输出:$R^2$统计数据下面是$F$ -统计数据。该统计量与$R^2$统计量相关,因为它也是SST和SSE的函数(参见图8.2)。它是由

$$

F={(\mathrm{SST}-\mathrm{SSE}) / k} /{\mathrm{SSE} /(n-k-1)}

$$

如果在上面的$\mathrm{R}$代码中添加((SST-SSE)/2)/(SSE/(n-3))行,您将得到报告的$F$ -统计数据,尽管有更多的小数:62.21945。

使用一点代数,您可以将$F$ -统计直接与$R^2$统计关联起来,表明对于固定的$k$和$n$,较大的$R^2$对应较大的$F$:

$$

F={(n-k-1) / k} \times R^2 /\left(1-R^2\right)

$$

自习题:为什么$F$和$R^2$的等式是正确的?

$F$ -统计量用于检验全局零假设$\mathrm{H}0: \beta_1=\beta_2=\ldots=\beta_k=0$,它表明回归变量$X_1, X_2, \ldots$或$X_k$都与$Y$无关。在$\mathrm{H}0: \beta_1=\beta_2=\ldots=\beta_k=0$为真的经典模型下,$F$ -统计量具有精确且众所周知的分布。经典模型下$F$ -统计量的分布,其中$\beta_1=\beta_2=\ldots=\beta_k=0$$$ F \sim F{k, n-k-1} $$ 其中$F{k, n-k-1}$为分子自由度为$k$,分母自由度为$n-k-1$的$F$分布。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。