统计代写|回归分析作业代写Regression Analysis代考|Visualizing map patterns with eigenvectors

如果你也在 怎样代写回归分析Regression Analysis这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

回归分析是一种强大的统计方法,允许你检查两个或多个感兴趣的变量之间的关系。虽然有许多类型的回归分析,但它们的核心都是考察一个或多个自变量对因变量的影响。

statistics-lab™ 为您的留学生涯保驾护航 在代写回归分析Regression Analysis方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写回归分析Regression Analysis代写方面经验极为丰富,各种代写回归分析Regression Analysis相关的作业也就用不着说。

我们提供的回归分析Regression Analysis及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|回归分析作业代写Regression Analysis代考|Visualizing map patterns with eigenvectors

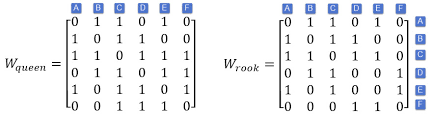

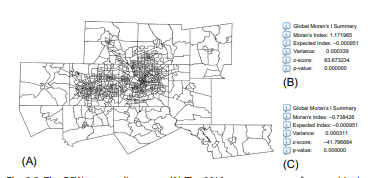

By convention, a SWM’s rows and columns are ordered with the same sequence of areal units. The eigenvectors of a SWM are n-by-1 vectors, with each of their rows linking to the corresponding areal unit identifier (ID) for the same row in their parent SWM. This one-to-one correspondence

enables mapping the eigenvectors of a SWM. The individual eigenvector elements simply have to be joined to their corresponding polygons in a shapefile file for visualization by ArcMap, for example.

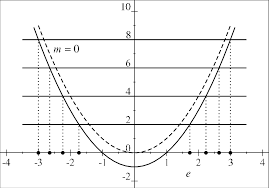

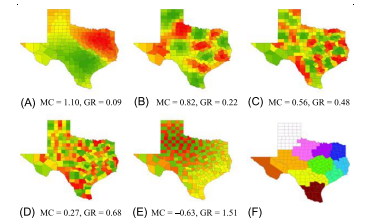

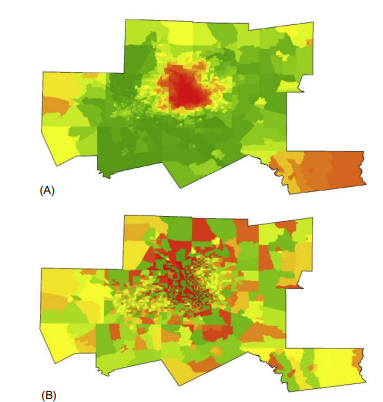

Fig. $2.4$ portrays the extreme eigenvectors for matrix $\left(I-11^{\mathrm{T}} / \mathrm{n}\right) \times$ $\mathbf{C}(\mathbf{I}-\mathbf{1 1} / \mathrm{n})$ representing the 2010 DFW metroplex census tracts. Fig. 2.4A portrays the principal eigenvector map pattern, the maximum PSA case, which depicts a hill/valley (this would change from a hill to a valley, or vice versa, by multiplying the eigenvector by $-1$ ) roughly in the center of the region, surrounded by a trough/hill, with intermediate plateaus in the western and southeastern parts of the region. This hill map pattern is one of the common global geographic trends portrayed by eigenvectors. Another typical map pattern is an east-west gradient trend, adapting to the somewhat rectangular shape of the DFW metroplex. Fig. $2.3 \mathrm{~A}$ reveals that the hill/valley subregion in Fig. 2.4A coincides with a concentration of numerous smaller census tracts located mostly in Dallas and Tarrant Counties. In contrast, Fig. 2.4B portrays a map pattern with considerable neighboring contrasts (e.g., dark red in juxtaposition with dark green), an alternating trend that exemplifies NSA. This map pattern has its intermediate values in its periphery, encircling the stark contrasts created by the alternating trend. A comparison of Fig. 2.4A and B reveals that PSA exhibits more smoothness in its map pattern, and NSA exhibits more fragmentation in its map pattern. These tendencies are less conspicuous in visualizations of the less extreme MC values.

统计代写|回归分析作业代写Regression Analysis代考|The spectral analysis of one-dimensional data

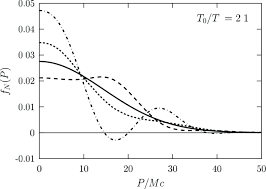

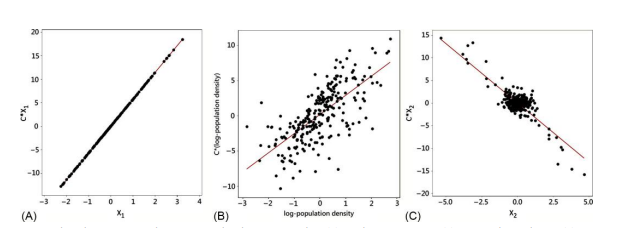

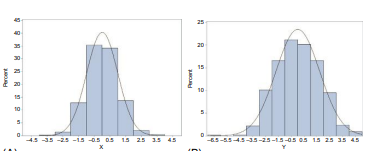

A simple one-dimensional geographic landscape (e.g., Fug. $2.5 \mathrm{~A}$ ) illustrates the connection between the spatial frequency and spatial spectral domains, furnishing the basis of the spectral density function equations presented in this section. SA indicates how rapidly a map pattern changes across a geographic landscape, using randomness as its yardstick. SA contains information about the expected frequency content mentioned earlier in this chapter. Meanwhile, the spectral density function furnishes one

mathematical link between $\mathrm{SA}$ and eigenfunctions in the spectral domain (Section 2.1; Bartlett, 1975). For a one-dimensional geographic landscape (e.g., Fig. $2.5 \mathrm{~A}$ ), given a stationary process $\left{\mathrm{X}{v}, \mathrm{t}=1,2, \ldots, \mathrm{T}\right}$ for a unidirectional dependency structure (this situation parallels a time series data structure) of the same form as the simultaneous autoregressive (SAR) model specification, $$ \mathrm{X}{\mathrm{t}}=\rho \mathrm{X}{\mathrm{t}-1}+\xi{\mathrm{t}},

$$

where $\rho$ is the autocorrelation parameter, $|\rho|<1$, t indexes location in the linear landscape, and $\xi_{t}$ is an independent and identically distributed (IID) random error term. Autocovariance functions, $\gamma(\tau), \tau=0,1, \ldots$, where $\tau$ denotes the number of lags, are established by repeatedly substituting the right-hand expression of an autoregressive equation like the preceding one into it and then applying the calculus of expectations to resulting infinite series forms of covariations. These infinite series are functions of linear combinations of $\xi_{t}^{2}$ together with powers of the SA parameter $\rho$, and hence yield $\sigma^{2}$ as well as a denominator term containing $\rho$. The corresponding atocovariance (i.e., covariation in an autocorrelated mathematical space) function is defined as follows:

$$

\gamma_{\mathrm{x}}(\tau)=\frac{\rho^{\tau} \sigma^{2}}{1-\rho^{2}}

$$

with $\tau$ being the number of lags (Griffith, 1988 , p- 111).

This preceding autocovariance function can be represented in the fretrency domain with the Fontrier transform

$$

f(\theta)=\frac{1}{2 \pi} \sum_{\tau=-\infty}^{\infty} e^{-i \pi \theta_{1}} \gamma_{X}(\tau)

$$

统计代写|回归分析作业代写Regression Analysis代考|This representation of the autocovariance

This representation of the autocovariance function in the frequency domain is referred to as the spectral density function or the spectrum of the random variable (RV) $\left{X_{t}\right}$. The sum ${ }^{6}$ of the spectrum over all frequencies gives the variance of $\left{X_{t}\right}$,

$$

\operatorname{VAR}\left(X_{t}\right)=\int_{0}^{\pi} \frac{\sigma^{2}}{2 \pi\left[1+\rho^{2}-2 \rho \operatorname{COS}(\theta)\right]} d \theta=\frac{\sigma^{2}}{2\left(1-\rho^{2}\right)},|\rho|<1,

$$

whereas the covariance at $\operatorname{lng} \tau$ is given by

$$

\operatorname{COV}\left(X_{t} X_{t-1}\right)=\int_{0}^{\pi} \frac{\sigma^{2} \operatorname{COS}(\tau \theta)}{2 \pi\left[1+\rho^{2}-2 \rho \operatorname{COS}(\theta)\right]} d \theta=\frac{\rho^{\tau} \sigma^{2}}{2\left(1-\rho^{2}\right)},|\rho|<1 .

$$

$\tau=0$ yields Eq. (2.6). In other words, representing the autocovariance function in the frequency domain allows a decomposition of the variance into frequency components that reveals their relative importance. The common effect of variance inflation routinely mentioned as a primary result of SA is apparent here: its arithmetic source is the term $-\rho^{2}$ appearing in the denominator of this expression. When no $S A$ is present, $\rho=0$ and $f(\theta)=\sigma^{2} / 2 \pi$, which is the spectral density for white noise. Accordingly, the variance in this independent observations case reduces to:

$$

\operatorname{VAR}\left(X_{\tau}\right)=\int_{0}^{\pi} \frac{\sigma^{2}}{2 \pi} \mathrm{d} \theta=\frac{\sigma^{2}}{2},

$$

which is consistent with results from the classical central limit theorem of statistics.

Furnishing asymptotic detaik for Eqs. (2.5) and (2.6), as shown by Berman and Plemmons (1994), the eigenvalues of a binary SWM for linear lattices can be defined as

$$

\lambda_{\mathrm{i}}=2 \operatorname{COS}\left(\frac{i \pi}{n+1}\right) .

$$

For the spectral density function defined by Eq. (2.5),

$$

\begin{gathered}

\lim {n \rightarrow \infty} \frac{i}{n+1}=\theta, \ \lambda{\mathrm{i}}=2 \operatorname{COS}(\theta), \text { and } \

f(\theta)=\frac{\sigma^{2}}{2 \pi\left(1+\rho^{2}-\rho \lambda\right)} .

\end{gathered}

$$

In other words, the spectral density function contains the eigenvalues of its corresponding SWM, which reveals that the autocovariance function for the RV $\left{X_{t}\right}$ is a function of the eigenvalues of the SWM.

To illustrate the relationship between the lagged spatial correlations with the second-order spatial covariance structure matrix $(\mathbf{I}-\rho \mathbf{C})^{-2}$ the SAR model specification-consider the bidirectional and one-dimensional geographic landscape with a symmetric dependency structure; that is,

$$

\mathrm{X}{\mathrm{i}}=\rho\left(\mathrm{X}{\mathrm{i}-1}+\mathrm{X}{\mathrm{i}+1}\right)+\xi{\mathrm{i}},|\rho|<\frac{1}{2}

$$

Here the autovariances at lags 0 and $\tau$ are

$$

\gamma(0)=\mathrm{E}\left(\mathrm{X}{\mathrm{i}} \mathrm{X}{\mathrm{i}}\right)=\frac{\sigma^{2}}{\left(1-4 \rho^{2}\right)^{3 / 2}}, \text { and }

$$

$\gamma(\tau)=\mathrm{E}\left(\mathrm{X}{\mathrm{i}} \mathrm{X}{\mathrm{i}-\tau}\right)$

$=\sigma^{2} \frac{\operatorname{SIN}[\tau \pi] \text { Hypergeometric PFQ }\left[\left{\frac{1}{2}, 1,2\right},{1-\tau, 1+\tau} 1-\tau, \frac{4 p}{1+2 p}\right]}{\pi \tau(1+2 p)^{2}}$ $0<\rho<1 / 2$

回归分析代写

统计代写|回归分析作业代写Regression Analysis代考|Visualizing map patterns with eigenvectors

按照惯例,SWM 的行和列按相同的面积单位顺序排列。SWM 的特征向量是 n×1 向量,它们的每一行都链接到其父 SWM 中同一行的相应区域单位标识符 (ID)。这种一一对应

能够映射 SWM 的特征向量。例如,为了通过 ArcMap 进行可视化,单个特征向量元素只需连接到 shapefile 文件中的相应多边形即可。

如图。2.4描绘矩阵的极端特征向量(一世−11吨/n)× C(一世−11/n)代表 2010 年 DFW 大都会人口普查区。图 2.4A 描绘了主要的特征向量图模式,即最大 PSA 情况,它描绘了一座山/谷(这会从一座山变为一座山谷,反之亦然,通过将特征向量乘以−1) 大致位于该地区的中心,被一个低谷/山丘包围,在该地区的西部和东南部有中间高原。这种山图模式是特征向量描绘的常见全球地理趋势之一。另一个典型的地图模式是东西向的渐变趋势,适应了 DFW 大都会的矩形形状。如图。2.3 一种揭示了图 2.4A 中的丘陵/山谷次区域与主要位于达拉斯和塔兰特县的众多较小人口普查区的集中相吻合。相比之下,图 2.4B 描绘了具有相当大的相邻对比度的地图图案(例如,深红色与深绿色并列),这是 NSA 的一种交替趋势。该地图模式在其外围具有中间值,围绕着由交替趋势产生的鲜明对比。图 2.4A 和 B 的比较表明,PSA 在其图谱中表现出更多的平滑度,而 NSA 在其图谱中表现出更多的碎片化。这些趋势在不太极端的 MC 值的可视化中不太明显。

统计代写|回归分析作业代写Regression Analysis代考|The spectral analysis of one-dimensional data

一个简单的一维地理景观(例如,Fug.2.5 一种) 说明了空间频率域和空间谱域之间的联系,为本节介绍的谱密度函数方程提供了基础。SA 表示地图模式在地理景观中的变化速度,使用随机性作为衡量标准。SA 包含有关本章前面提到的预期频率内容的信息。同时,谱密度函数提供了一个

之间的数学联系小号一种和谱域中的特征函数(第 2.1 节;Bartlett,1975)。对于一维地理景观(例如,图 1)。2.5 一种),给定一个平稳过程\left{\mathrm{X}{v}, \mathrm{t}=1,2, \ldots, \mathrm{T}\right}\left{\mathrm{X}{v}, \mathrm{t}=1,2, \ldots, \mathrm{T}\right}对于与同步自回归 (SAR) 模型规范相同形式的单向依赖结构(这种情况与时间序列数据结构平行),X吨=ρX吨−1+X吨,

在哪里ρ是自相关参数,|ρ|<1, t 索引线性景观中的位置,以及X吨是独立同分布 (IID) 随机误差项。自协方差函数,C(τ),τ=0,1,…, 在哪里τ表示滞后数,通过反复代入与前一个类似的自回归方程的右手表达式,然后将期望计算应用于所得的无限级数形式的协变来建立。这些无穷级数是线性组合的函数X吨2连同 SA 参数的幂ρ,因此产量σ2以及包含的分母项ρ. 相应的原子协方差(即自相关数学空间中的协变)函数定义如下:

CX(τ)=ρτσ21−ρ2

和τ是滞后的数量(Griffith,1988,p-111)。

前面的自协方差函数可以用 Fontrier 变换在频域中表示

F(θ)=12圆周率∑τ=−∞∞和−一世圆周率θ1CX(τ)

统计代写|回归分析作业代写Regression Analysis代考|This representation of the autocovariance

这种自协方差函数在频域中的表示称为谱密度函数或随机变量 (RV) 的谱\left{X_{t}\right}\left{X_{t}\right}. 总和6在所有频率上的频谱给出方差\left{X_{t}\right}\left{X_{t}\right},

曾是(X吨)=∫0圆周率σ22圆周率[1+ρ2−2ρCOS(θ)]dθ=σ22(1−ρ2),|ρ|<1,

而协方差在液化天然气τ是(谁)给的

冠状病毒(X吨X吨−1)=∫0圆周率σ2COS(τθ)2圆周率[1+ρ2−2ρCOS(θ)]dθ=ρτσ22(1−ρ2),|ρ|<1.

τ=0产生方程。(2.6)。换句话说,在频域中表示自协方差函数允许将方差分解为频率分量,从而揭示它们的相对重要性。作为 SA 的主要结果,经常提到的方差膨胀的共同影响在这里很明显:它的算术来源是术语−ρ2出现在这个表达式的分母中。没有时小号一种存在,ρ=0和F(θ)=σ2/2圆周率,这是白噪声的频谱密度。因此,这种独立观察情况下的方差减少到:曾是(Xτ)=∫0圆周率σ22圆周率dθ=σ22,

这与统计的经典中心极限定理的结果一致。

为 Eqs 提供渐近细节。(2.5) 和 (2.6),如 Berman 和 Plemmons (1994) 所示,线性格的二进制 SWM 的特征值可以定义为

λ一世=2COS(一世圆周率n+1).

对于方程定义的谱密度函数。(2.5),

$$

\begin{gathered}

\lim {n \rightarrow \infty} \frac{i}{n+1}=\theta, \ \lambda {\mathrm{i}}=2 \operatorname{COS }(\theta), \text { 和 } \

f(\theta)=\frac{\sigma^{2}}{2 \pi\left(1+\rho^{2}-\rho \lambda\right )} 。

\end{gathered}

$$

换句话说,谱密度函数包含其对应 SWM 的特征值,这表明 RV 的自协方差函数\left{X_{t}\right}\left{X_{t}\right}是 SWM 特征值的函数。

为了说明滞后空间相关性与二阶空间协方差结构矩阵之间的关系(一世−ρC)−2SAR模型规范——考虑具有对称依赖结构的双向一维地理景观;那是,

X一世=ρ(X一世−1+X一世+1)+X一世,|ρ|<12

这里的自方差滞后 0 和τ是

C(0)=和(X一世X一世)=σ2(1−4ρ2)3/2, 和

C(τ)=和(X一世X一世−τ)

=\sigma^{2} \frac{\operatorname{SIN}[\tau \pi] \text { 超几何 PFQ }\left[\left{\frac{1}{2}, 1,2\right},{ 1-\tau, 1+\tau} 1-\tau, \frac{4 p}{1+2 p}\right]}{\pi \tau(1+2 p)^{2}}=\sigma^{2} \frac{\operatorname{SIN}[\tau \pi] \text { 超几何 PFQ }\left[\left{\frac{1}{2}, 1,2\right},{ 1-\tau, 1+\tau} 1-\tau, \frac{4 p}{1+2 p}\right]}{\pi \tau(1+2 p)^{2}} 0<ρ<1/2

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

随机过程代考

在概率论概念中,随机过程是随机变量的集合。 若一随机系统的样本点是随机函数,则称此函数为样本函数,这一随机系统全部样本函数的集合是一个随机过程。 实际应用中,样本函数的一般定义在时间域或者空间域。 随机过程的实例如股票和汇率的波动、语音信号、视频信号、体温的变化,随机运动如布朗运动、随机徘徊等等。

贝叶斯方法代考

贝叶斯统计概念及数据分析表示使用概率陈述回答有关未知参数的研究问题以及统计范式。后验分布包括关于参数的先验分布,和基于观测数据提供关于参数的信息似然模型。根据选择的先验分布和似然模型,后验分布可以解析或近似,例如,马尔科夫链蒙特卡罗 (MCMC) 方法之一。贝叶斯统计概念及数据分析使用后验分布来形成模型参数的各种摘要,包括点估计,如后验平均值、中位数、百分位数和称为可信区间的区间估计。此外,所有关于模型参数的统计检验都可以表示为基于估计后验分布的概率报表。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

statistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

机器学习代写

随着AI的大潮到来,Machine Learning逐渐成为一个新的学习热点。同时与传统CS相比,Machine Learning在其他领域也有着广泛的应用,因此这门学科成为不仅折磨CS专业同学的“小恶魔”,也是折磨生物、化学、统计等其他学科留学生的“大魔王”。学习Machine learning的一大绊脚石在于使用语言众多,跨学科范围广,所以学习起来尤其困难。但是不管你在学习Machine Learning时遇到任何难题,StudyGate专业导师团队都能为你轻松解决。

多元统计分析代考

基础数据: $N$ 个样本, $P$ 个变量数的单样本,组成的横列的数据表

变量定性: 分类和顺序;变量定量:数值

数学公式的角度分为: 因变量与自变量

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。