如果你也在 怎样代写机器学习Machine Learning这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

机器学习是人工智能(AI)和计算机科学的一个分支,主要是利用数据和算法来模仿人类的学习方式,逐步提高其准确性。

机器学习是不断增长的数据科学领域的一个重要组成部分。通过使用统计方法,算法被训练来进行分类或预测,在数据挖掘项目中发现关键的洞察力。这些洞察力随后推动了应用程序和业务的决策,最好是影响关键的增长指标。随着大数据的不断扩大和增长,市场对数据科学家的需求将增加,需要他们协助确定最相关的业务问题,随后提供数据来回答这些问题。

statistics-lab™ 为您的留学生涯保驾护航 在代写机器学习Machine Learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写机器学习方面经验极为丰富,各种代写机器学习Machine Learning相关的作业也就用不着说。

我们提供的机器学习Machine Learning及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等楖率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|机器学习作业代写Machine Learning代考|Supervised learning

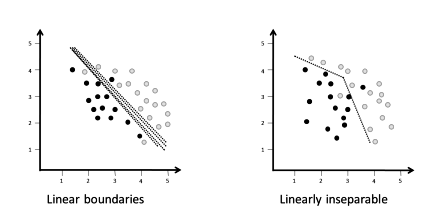

Supervised learning needs labeled data for training. A training example is called a data point or instance and consists of an input and output pair $(x, y) . y$ is the output or ground truth for input $x$. Contrary to supervised learning, in unsupervised learning, the data only provides inputs. A multiset of training examples forms the training data set. The training data set is also called gold standard data and is as close to the ground truth as possible. The training set is used to produce a predictor function $f$, also called decision function, that maps inputs $x$ to $y=f(x)$. The goal is to produce a predictor $f$ that works with examples other than the training examples. In other words, $f$ needs to generalize beyond the training data and provide accurate predictions on new, unseen data. $f$ provides an approximation on unseen data. The input $x$ is a feature vector or covariates, the output $y$ is the response. A feature vector $\phi(x)$ is a map of feature names to feature values, i.e., strings to doubles. A feature vector $\phi(x) \in \mathbb{R}$ is a real vector $\phi(x)=\left[\phi_{1}(x), \phi_{2}(x), \ldots \phi_{n}(x)\right]$, where each component $\phi_{i}(x)$ with $i=1, \ldots n$ represents a feature. The feature vector is computed by the feature extractor $\phi$ and can be thought of as a point in a high-dimensional feature space. A feature in a feature vector can be weighted, which means, not every feature necessarily contributes equally to a prediction. A weight is a real number that is multiplied with the feature value. The weights are represented in a separate weight vector because we want one single predictor that works on any input. Given a feature vector $\phi(x)$ and a weight vector $w$, we calculate the prediction score as the inner product of the vectors $w \cdot \phi(x)$. We do

not know the weights in vector $w$ beforehand, they are learned during training.

To predict, for instance, if a news article is about politics or sports, we need to find out what properties of input $x$ might be relevant to predict if the article belongs to the category “politics” or “sports”. This process is called feature extraction. There are machine learning techniques where no function is generated. For example, decision tree induction creates a decision tree, as the name suggests, usually represented as a dendrogram and not a function. To begin with, we will start with a function and explain other techniques in later chapters.

If we try to classify the data into categories, e.g., medical images into healthy or pathologic tissue, we have a classification problem. Classification has discrete outputs such as “true” or “false” or “0” or ” 1 “. If there are just two categories, it is a binary classification problem. Often, the outputs are probabilities, e.g., a mail is spam with 80 percent probability. In other words, the dichotomy of the output is not imperative.

If there are more categories, e.g., restaurant reviews using a Likert scale, as shown in Figure 2.2, it is a multiclass classification problem.

统计代写|机器学习作业代写Machine Learning代考|Perceptron

The perceptron is a simple neural network, proposed in 1958 by Rosenblatt, which became a landmark in early machine learning history [10]. It is one of the oldest machine learning algorithms. The perceptron consists of a single neuron and is a binary classifier that can linearly separate an input $x$, a real valued vector, into a single, binary output. It is an online learning algorithm. Online learning means it processes one input at a time. The data is presented in a sequential order and updates the predictor at each step using the best predictor. The perceptron is

modeled after a neuron in the brain and is the basic element of a neural network.

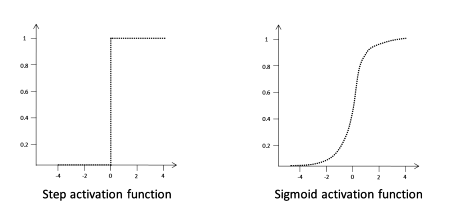

There are different types of perceptrons. They can have one or more input and output links. The input links correspond to the dendrites of a real neuron, the output links to the synapses. Also, there are different types of activation functions. The perceptron shown in Figure $2.3$ consists of three weighted input links, a sum function, a step activation function and one output link.

A perceptron performs three processing steps:

- Each input signal $x$ is multiplied by a weight $w: w_{i} x_{i}$

- All signals are summed up

- The summed up inputs are fed to an activation function

The output is calculated using the output function $f(x)$, as defined by equation 2.3.

$$

f(x)=\sum_{i=1} w_{i} x_{i}+b

$$

where

$$

\begin{aligned}

w &=\text { Weight } \

x &=\text { Input } \

b &=\text { Bias }

\end{aligned}

$$

统计代写|机器学习作业代写Machine Learning代考| Unsupervised learning

In supervised learning, we have input and output data. In unsupervised learning, we do not have labeled training data. In other words, we only

have input data, no output data, i.e., there is no $y$. Instead of predicting or approximating a variable, we try to group the data into different classes. For instance, we have a population of online shop users that we try to segment into different types of buyers. The types could be social shopper, lifestyle junkie and detached introvert. In this case, we have three clusters. If an observation point can only belong to one cluster, it is an exclusive cluster, if it is allowed to be part of more than one cluster, it is a non-exclusive cluster, in other words, the clusters can be overlapping.

Let $N$ be a set of unlabeled instances $D=x_{1}, x_{2}, \ldots, x_{N}$ in a $d$ dimensional feature space, in clustering $D$ is partitioned into a number of disjoint subsets $D_{j} \mathrm{~s}$ :

$$

D=\cup_{j=1}^{k} D_{j}

$$

where

$$

\begin{aligned}

&D_{i} \cap D_{j}=\emptyset \

&i \neq j

\end{aligned}

$$

The points in each subset $D_{j}$ are similar to each other according to a given criterion $\varnothing$. Similarity is usually expressed by some distance measure, such as the Euclidean distance or Manhattan distance.

Cluster analysis can be used for understanding the underlying structure of a dataset by grouping it into classes based on similarities. Grouping similar objects into conceptually meaningful classes has many reallife applications. For instance, biologists spent a considerable amount of time on grouping plants and animals into classes, such as rodents, canines, felines, ruminants, marsupials, etc. Clustering is also used for information retrieval, for instance, by grouping Web search results into categories, such as news, social media, blogs, forums, marketing, etc. Each category can then be divided into subcategories. For example, news is divided into politics, economics, sports, etc. This process is called hierarchical clustering. Humans, even young children, are skilled at grouping objects into their corresponding classes. This capability is important to humans for understanding and describing the world around us. This is crucial for our survival. We need to know which groups of animals are harmful or which traffic situations are potentially dangerous.

机器学习代写

统计代写|机器学习作业代写Machine Learning代考|Supervised learning

监督学习需要标记数据进行训练。训练示例称为数据点或实例,由输入和输出对组成(X,是).是是输入的输出或基本事实X. 与监督学习相反,在无监督学习中,数据仅提供输入。多组训练示例形成训练数据集。训练数据集也称为黄金标准数据,并且尽可能接近真实数据。训练集用于产生预测函数F,也称为决策函数,映射输入X到是=F(X). 目标是产生一个预测器F它适用于训练示例以外的示例。换句话说,F需要在训练数据之外进行泛化,并对新的、看不见的数据提供准确的预测。F提供对未见数据的近似值。输入X是特征向量或协变量,输出是是响应。一个特征向量φ(X)是特征名称到特征值的映射,即字符串到双精度。一个特征向量φ(X)∈R是一个实向量φ(X)=[φ1(X),φ2(X),…φn(X)], 其中每个分量φ一世(X)和一世=1,…n代表一个特征。特征向量由特征提取器计算φ并且可以被认为是高维特征空间中的一个点。可以对特征向量中的特征进行加权,这意味着并非每个特征都必须对预测做出同等贡献。权重是与特征值相乘的实数。权重在一个单独的权重向量中表示,因为我们想要一个适用于任何输入的单个预测器。给定一个特征向量φ(X)和一个权重向量在,我们将预测分数计算为向量的内积在⋅φ(X). 我们的确是

不知道向量中的权重在事先,它们是在培训期间学习的。

例如,要预测一篇新闻文章是否是关于政治或体育的,我们需要找出输入的哪些属性X可能与预测文章是否属于“政治”或“体育”类别相关。这个过程称为特征提取。有些机器学习技术不会生成任何函数。例如,决策树归纳创建决策树,顾名思义,通常表示为树状图而不是函数。首先,我们将从一个函数开始,并在后面的章节中解释其他技术。

如果我们试图将数据分类,例如将医学图像分类为健康或病理组织,我们就会遇到分类问题。分类具有离散输出,例如“真”或“假”或“0”或“1”。如果只有两个类别,这是一个二元分类问题。通常,输出是概率,例如,邮件是垃圾邮件,概率为 80%。换句话说,输出的二分法不是必须的。

如果有更多的类别,例如使用李克特量表的餐厅评论,如图 2.2 所示,这是一个多类分类问题。

统计代写|机器学习作业代写Machine Learning代考|Perceptron

感知器是一个简单的神经网络,由 Rosenblatt 于 1958 年提出,成为早期机器学习历史上的里程碑[10]。它是最古老的机器学习算法之一。感知器由单个神经元组成,是一个可以线性分离输入的二元分类器X,一个实值向量,转换为单个二进制输出。它是一种在线学习算法。在线学习意味着它一次处理一个输入。数据按顺序呈现,并在每一步使用最佳预测器更新预测器。感知器是

以大脑中的神经元为模型,是神经网络的基本元素。

有不同类型的感知器。它们可以有一个或多个输入和输出链接。输入链接对应于真实神经元的树突,输出链接对应于突触。此外,还有不同类型的激活函数。如图所示的感知器2.3由三个加权输入链接、一个求和函数、一个步进激活函数和一个输出链接组成。

感知器执行三个处理步骤:

- 每个输入信号X乘以权重在:在一世X一世

- 汇总所有信号

- 总和的输入被馈送到激活函数

使用输出函数计算输出F(X),如公式 2.3 所定义。

F(X)=∑一世=1在一世X一世+b

在哪里

在= 重量 X= 输入 b= 偏见

统计代写|机器学习作业代写Machine Learning代考| Unsupervised learning

在监督学习中,我们有输入和输出数据。在无监督学习中,我们没有标记的训练数据。换句话说,我们只

有输入数据,没有输出数据,即没有是. 我们不是预测或近似变量,而是尝试将数据分组到不同的类别中。例如,我们有一群在线商店用户,我们试图将这些用户细分为不同类型的买家。这些类型可能是社交购物者、生活方式迷和超然内向的人。在这种情况下,我们有三个集群。如果一个观察点只能属于一个簇,则为排他簇,如果允许属于多个簇,则为非排他簇,即簇可以重叠。

让ñ是一组未标记的实例D=X1,X2,…,Xñ在一个d维度特征空间,在聚类中D被分割成许多不相交的子集Dj s:

D=∪j=1到Dj

在哪里

D一世∩Dj=∅ 一世≠j

每个子集中的点Dj根据给定的标准彼此相似∅. 相似度通常用一些距离度量来表示,例如欧几里得距离或曼哈顿距离。

聚类分析可用于通过基于相似性将数据集分组为类来理解数据集的底层结构。将相似的对象分组到概念上有意义的类中具有许多实际应用。例如,生物学家花费大量时间将植物和动物分组,如啮齿动物、犬科动物、猫科动物、反刍动物、有袋动物等。聚类也用于信息检索,例如,通过将网络搜索结果分组,例如新闻、社交媒体、博客、论坛、营销等。然后每个类别都可以分为子类别。例如,新闻分为政治、经济、体育等,这个过程称为层次聚类。人类,甚至是年幼的孩子,都擅长将对象分组到相应的类别中。这种能力对于人类理解和描述我们周围的世界很重要。这对我们的生存至关重要。我们需要知道哪些动物群是有害的,或者哪些交通状况有潜在危险。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。统计代写|python代写代考

随机过程代考

在概率论概念中,随机过程是随机变量的集合。 若一随机系统的样本点是随机函数,则称此函数为样本函数,这一随机系统全部样本函数的集合是一个随机过程。 实际应用中,样本函数的一般定义在时间域或者空间域。 随机过程的实例如股票和汇率的波动、语音信号、视频信号、体温的变化,随机运动如布朗运动、随机徘徊等等。

贝叶斯方法代考

贝叶斯统计概念及数据分析表示使用概率陈述回答有关未知参数的研究问题以及统计范式。后验分布包括关于参数的先验分布,和基于观测数据提供关于参数的信息似然模型。根据选择的先验分布和似然模型,后验分布可以解析或近似,例如,马尔科夫链蒙特卡罗 (MCMC) 方法之一。贝叶斯统计概念及数据分析使用后验分布来形成模型参数的各种摘要,包括点估计,如后验平均值、中位数、百分位数和称为可信区间的区间估计。此外,所有关于模型参数的统计检验都可以表示为基于估计后验分布的概率报表。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

statistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

机器学习代写

随着AI的大潮到来,Machine Learning逐渐成为一个新的学习热点。同时与传统CS相比,Machine Learning在其他领域也有着广泛的应用,因此这门学科成为不仅折磨CS专业同学的“小恶魔”,也是折磨生物、化学、统计等其他学科留学生的“大魔王”。学习Machine learning的一大绊脚石在于使用语言众多,跨学科范围广,所以学习起来尤其困难。但是不管你在学习Machine Learning时遇到任何难题,StudyGate专业导师团队都能为你轻松解决。

多元统计分析代考

基础数据: $N$ 个样本, $P$ 个变量数的单样本,组成的横列的数据表

变量定性: 分类和顺序;变量定量:数值

数学公式的角度分为: 因变量与自变量

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。