统计代写|数据可视化代写Data visualization代考|STAT1100

如果你也在 怎样代写数据可视化Data visualization这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。

数据可视化是将信息转化为视觉背景的做法,如地图或图表,使数据更容易被人脑理解并从中获得洞察力。数据可视化的主要目标是使其更容易在大型数据集中识别模式、趋势和异常值。

statistics-lab™ 为您的留学生涯保驾护航 在代写数据可视化Data visualization方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写数据可视化Data visualization代写方面经验极为丰富,各种代写数据可视化Data visualization相关的作业也就用不着说。

我们提供的数据可视化Data visualization及其相关学科的代写,服务范围广, 其中包括但不限于:

- Statistical Inference 统计推断

- Statistical Computing 统计计算

- Advanced Probability Theory 高等概率论

- Advanced Mathematical Statistics 高等数理统计学

- (Generalized) Linear Models 广义线性模型

- Statistical Machine Learning 统计机器学习

- Longitudinal Data Analysis 纵向数据分析

- Foundations of Data Science 数据科学基础

统计代写|数据可视化代写Data visualization代考|Francis Galton and the Idea of Correlation

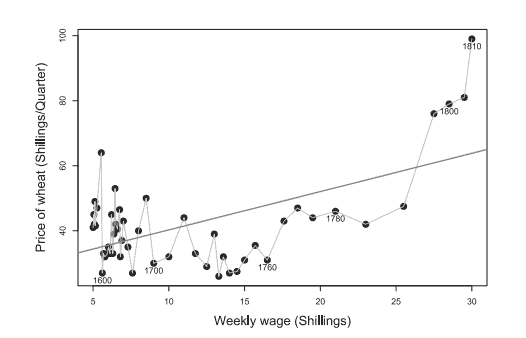

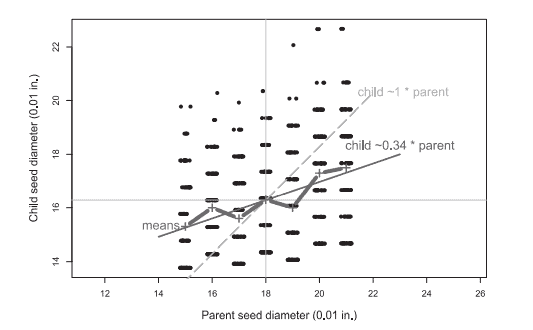

Francis Galton [1822-1911] was among the first to show a purely empirical bivariate relation in graphical form using actual data with his work on questions of heritability of traits. He began with plots showing the relationship between physical characteristics of people (head circumference and height) or between parents and their offspring, as a means to study the association and inheritance of traits: Do tall people have larger heads than average? Do tall parents have taller than average children?

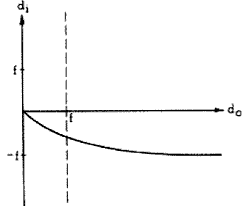

Inspecting and calculating from his graphs, he discovered a phenomenon he called “regression toward the mean,” and his work on these problems can be considered to be the foundation of modern statistical methods. His insight from these diagrams led to much more: the ideas of correlation and linear regression; the bivariate normal distribution; and eventually to nearly all of classical statistical linear models (analysis of variance, multiple regression, etc.).

The earliest known example is a chart of head circumference compared to stature from Galton’s notebook (circa 1874) “Special Peculiarities,” shown in Figure 6.11. ${ }^{16}$ In this hand-drawn chart, the intervals of height are shown horizontally against head circumference vertically. The entries in the body are the tallies in the pairs of class intervals. Galton included the total counts of height and head circumference in the right and bottom margins and drew smooth curves to represent their frequency distributions. The conceptual origin of this chart as a table rather than a graph can be seen in the fact that the smallest values of the two variables are shown at the top left (first row and first column), rather than in the bottom right, as would be more natural in a graph. One may argue that Galton’s graphic representations of bivariate relations were both less and more than true scatterplots of data, as these are used today. They are less because at first glance they look like little more than tables with some graphic annotations. They are more because he used these as devices to calculate and reason with. ${ }^{17} \mathrm{He}$ did this because the line of regression he sought was initially defined as the trace of the mean of the vertical variable $y$ as the horizontal variable $x$ varied $^{18}$ (what we now think of as the conditional mean function, $\mathcal{E}(y \mid x)$ ), and so required grouping at least the $x$ variable into class intervals. Galton’s displays of these data were essentially graphic transcriptions of these tables, using count-symbols $(/, / /, / / /, \ldots)$ or numbers to represent the frequency in each cell-what in 1972 the Princeton polymath John Tukey called “semi-graphic displays,” making them a visual chimera: part table, part plot.

统计代写|数据可视化代写Data visualization代考|Galton’s Elliptical Insight

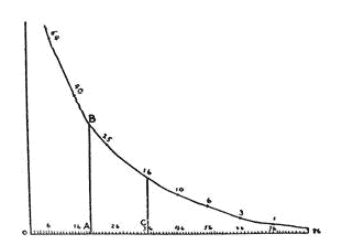

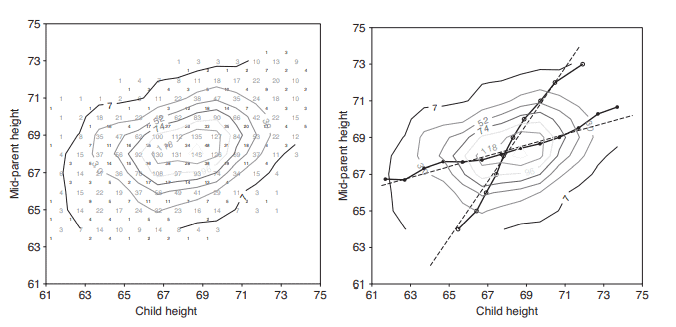

Galton’s next step on the problem of filial correlation and regression turned out to be one of the most important in the history of statistics. In 1886, he published a paper titled “Regression Towards Mediocrity in Hereditary Stature” containing the table shown in Figure 6.14. The table records the frequencies of the heights of 928 adult children born to 205 pairs of fathers and mothers, classified by the average height of their father and mother (“mid-parent” height).$^{22}$

If you look at this table, you may see only a table of numbers with larger values in the middle and some dashes (meaning 0 ) in the upper left, and bottom right corners. But for Galton, it was something he could compute with, both in his mind’s eye and on paper.

I found it hard at first to catch the full significance of the entries in the table, which had curious relations that were very interesting to investigate. They came out distinctly when I “smoothed” the entries by writing at each intersection of a horizontal column with a vertical one, the sum of the entries in the four adjacent squares, and using these to work upon. (Galton, 1886, p. 254)

Consequently, Galton first smoothed the numbers in this table, which he did by the simple step of summing (or averaging) each set of four adjacent cells. We can imagine that he wrote that average number larger in red ink, exactly at the intersection of these four cells. When he had completed this task, we can imagine him standing above the table with a different pen and trying to connect the dots-to draw curves, joining the points of approximately equal frequency. We tried to reproduce these steps in Figure 6.15, except that we did the last step mechanically, using a computer algorithm, whereas Galton probably did it by eye and brain, in the manner of Herschel, with the aim that the resulting curves should be gracefully smooth.

数据可视化代考

统计代写|数据可视化代写数据可视化代考|Francis Galton和相关性的思想

Francis Galton[1822-1911]是第一个使用实际数据以图形形式展示纯经验二元关系的人之一,他的工作涉及性状的遗传力问题。他从展示人的身体特征(头围和身高)之间的关系,或父母和他们的后代之间的关系的图表开始,作为一种研究特征的关联和遗传的手段:高个子的人的头比普通人大吗?个子高的父母生的孩子比一般人高吗?

从他的图表中检查和计算,他发现了一种被他称为“趋均数回归”的现象,他对这些问题的研究可以被认为是现代统计方法的基础。他从这些图表中得出的见解带来了更多:相关性和线性回归的思想;二元正态分布;并最终对几乎所有的经典线性统计模型(方差分析、多元回归等)进行了分析。已知最早的例子是高尔顿笔记本上的头围与身高对比图(约1874年)。“特殊特性”如图6.11所示。${ }^{16}$在这张手绘的图表中,身高的间隔水平地与头围垂直地对比。主体中的条目是类间隔对的计数。Galton将身高和头围的总数包括在右侧和底部的空白中,并画出光滑的曲线来表示它们的频率分布。这张图表的概念起源是表格而不是图形,这可以从两个变量的最小值显示在左上角(第一行和第一列),而不是显示在右下角(在图形中更自然)这一事实中看出。有人可能会说,高尔顿对二元关系的图形表示既不是真实的数据散点图,也不是真实的数据散点图,就像今天所使用的那样。它们之所以少,是因为乍一看,它们不过是一些带有图形注释的表格。更重要的是,他把这些作为计算和推理的工具。${ }^{17} \mathrm{He}$这样做是因为他所寻求的回归线最初被定义为垂直变量$y$的平均值的轨迹,而水平变量$x$的变化是$^{18}$(我们现在认为是条件均值函数$\mathcal{E}(y \mid x)$),因此至少需要将$x$变量分组到类间隔中。高尔顿对这些数据的显示,本质上是对这些表格的图形复制,使用计数符号$(/, / /, / / /, \ldots)$或数字来表示每个细胞的频率——1972年,普林斯顿大学的博学家约翰·杜克(John Tukey)将其称为“半图形显示”,使它们成为视觉上的嵌合体:部分是表格,部分是图表

统计代写|数据可视化代写数据可视化代考|高尔顿椭圆洞察

高尔顿在子相关和回归问题上的下一步被证明是统计史上最重要的一步。1886年,他发表了一篇题为《世袭身材向平庸的回归》的论文,其中包含了如图6.14所示的表格。该表格记录了205对父亲和母亲所生的928名成年子女的身高频率,并根据他们的父亲和母亲的平均身高(“中间父母”身高)进行了分类。$^{22}$

如果你看一下这个表格,你可能只会看到一个数字表,中间是较大的值,左上角和右下角有一些破折号(表示0)。但对高尔顿来说,这是他可以用脑子和纸来计算的东西

一开始我发现很难抓住表中条目的全部意义,它们之间有着非常有趣的关系,值得研究。当我在水平列和垂直列的每一个交叉点上写下四个相邻方格中条目的和,并使用这些条目来“平滑”条目时,它们明显地显现出来。(高尔顿,1886,p. 254)

因此,高尔顿首先平滑了该表中的数字,他通过简单的步骤,对每组相邻的四个单元格进行求和(或平均)。我们可以想象他用红墨水把平均数写大了,正好在这四个单元格的交点处。当他完成这项任务后,我们可以想象他站在桌子上方,拿着另一支笔,试图把点连接起来——画曲线,把频率大致相等的点连接起来。我们试着在图6.15中重现这些步骤,除了最后一步是机械地用计算机算法完成的,而高尔顿可能是用眼睛和大脑,以赫歇尔的方式完成的,目的是要得到优雅光滑的曲线

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。