计算机代写|机器学习代写machine learning代考|Can you put this into production? Would you want to maintain it?

如果你也在 怎样代写机器学习Machine Learning 这个学科遇到相关的难题,请随时右上角联系我们的24/7代写客服。机器学习Machine Learning是一个致力于理解和建立 “学习 “方法的研究领域,也就是说,利用数据来提高某些任务的性能的方法。机器学习算法基于样本数据(称为训练数据)建立模型,以便在没有明确编程的情况下做出预测或决定。机器学习算法被广泛用于各种应用,如医学、电子邮件过滤、语音识别和计算机视觉,在这些应用中,开发传统算法来执行所需任务是困难的或不可行的。

机器学习Machine Learning程序可以在没有明确编程的情况下执行任务。它涉及到计算机从提供的数据中学习,从而执行某些任务。对于分配给计算机的简单任务,有可能通过编程算法告诉机器如何执行解决手头问题所需的所有步骤;就计算机而言,不需要学习。对于更高级的任务,由人类手动创建所需的算法可能是一个挑战。在实践中,帮助机器开发自己的算法,而不是让人类程序员指定每一个需要的步骤,可能会变得更加有效 。

statistics-lab™ 为您的留学生涯保驾护航 在代写机器学习 machine learning方面已经树立了自己的口碑, 保证靠谱, 高质且原创的统计Statistics代写服务。我们的专家在代写机器学习 machine learning代写方面经验极为丰富,各种代写机器学习 machine learning相关的作业也就用不着说。

计算机代写|机器学习代写machine learning代考|Can you put this into production? Would you want to maintain it?

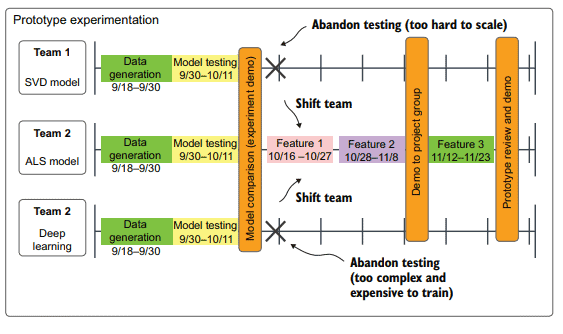

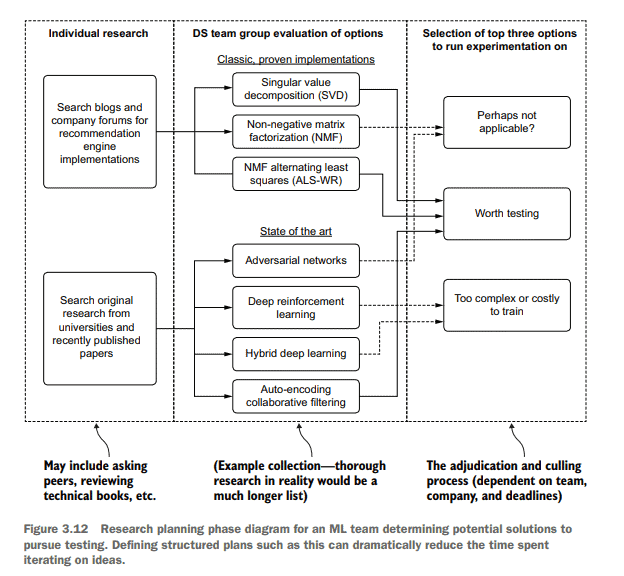

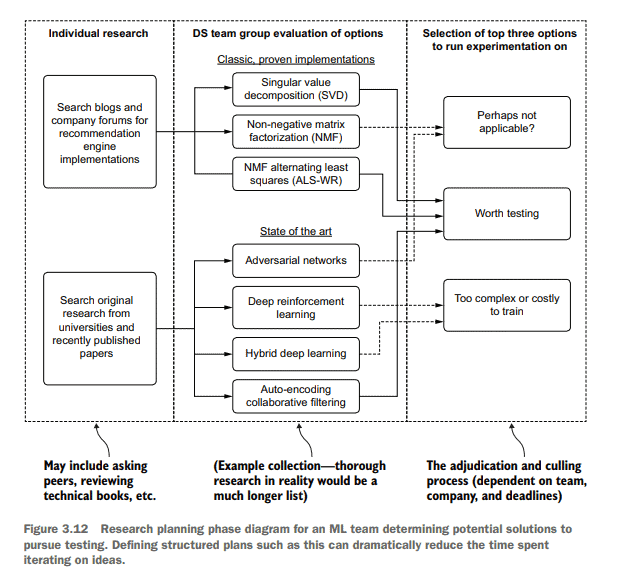

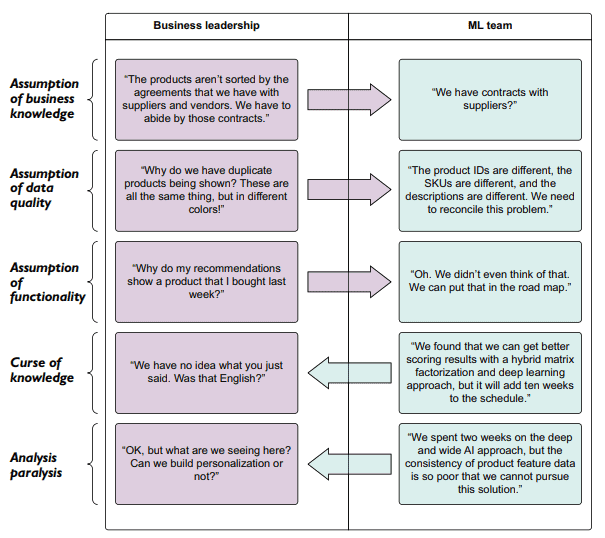

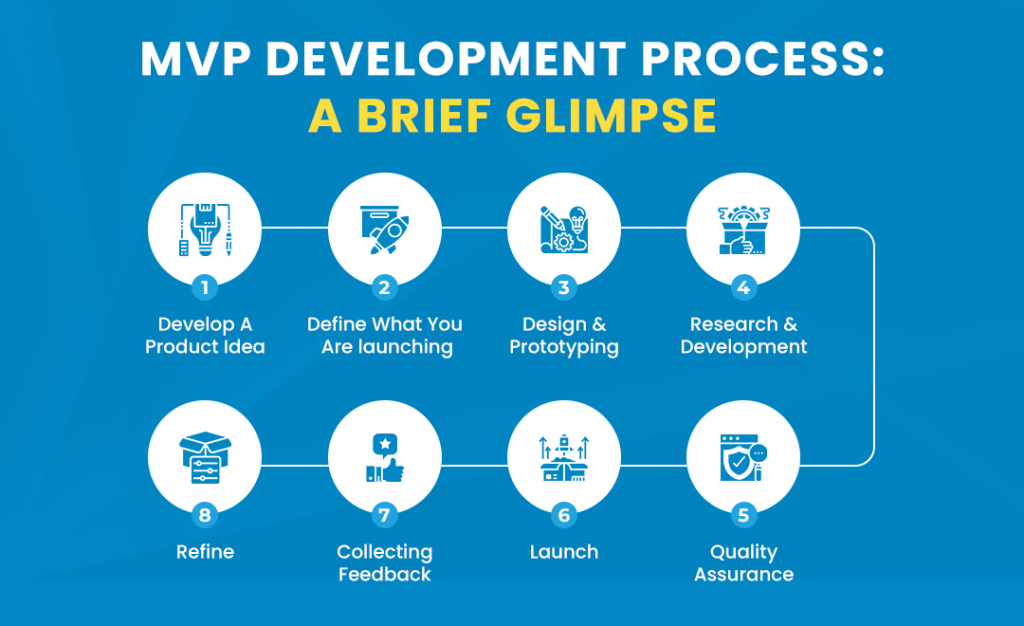

While the primary purpose of an experimentation phase, to the larger team, is to make a decision on the predictive capabilities of a model’s implementation, one of the chief purposes internally, among the DS team, is to determine whether the solution is tenable for the team. The DS team lead, architect, or senior DS person on the team should be taking a close look at what is going to be involved in this project, asking difficult questions, and producing honest answers. Some of the most important questions are as follows:

How long is this solution going to take to build?

How complex is this code base going to be?

How expensive is this going to be to train based on the schedule it needs to be retrained at?

Does my team have the skill required to maintain this solution? Does everyone know this algorithm/language/platform?

How quickly will we be able to modify this solution should something dramatically change with the data that it’s training or inferring on?

Has anyone else reported success with using this methodology/platform/language/API? Are we reinventing the wheel or are we building a square wheel?

How much additional work will the team have to do to make this solution work while meeting all of the other feature goals?

Is this going to be extensible? When the inevitable version 2.0 of this is requested, will we be able to enhance this solution easily?

Is this testable?

= Is this auditable?

Innumerable times in my career, I’ve been either the one building these prototypes or the one asking these questions while reviewing someone else’s prototype. Although an ML practitioner’s first reaction to seeing results is frequently, “Let’s go with the one that has the best results,” many times the “best” one ends up being either nighimpossible to fully implement or a nightmare to maintain.

计算机代写|机器学习代写machine learning代考|TDD vs. RDD vs. PDD vs. CDD for ML projects

We seem to have an infinite array of methodologies to choose from when developing software. From waterfall to the Agile revolution (and all of its myriad flavors), each has benefits and drawbacks.

We won’t discuss the finer points of which development approach might be best for particular projects or teams. Absolutely fantastic books have been published that explore these topics in depth, and I highly recommend reading them to improve the development processes for ML projects. Becoming Agile in an Imperfect World by Greg Smith and Ahmed Sidky (Manning, 2009) and Test Driven: TDD and Acceptance TDD for Java Developers by Lasse Koskela (Manning, 2007) are notable resources. Worth discussing here, however, are four general approaches to ML development (one being a successful methodology, the others being cautionary tales).

TEST-DRIVEN DEVELOPMENT OR FEATURE-DRIVEN DEVELOPMENT

Pure test-driven development $(T D D)$ is incredibly challenging to achieve for ML projects (and certainly unable to achieve the same test coverage in the end that traditional software development can), mostly due to the nondeterministic nature of models themselves. A pure feature-driven development (FDD) approach can cause significant rework during a project.

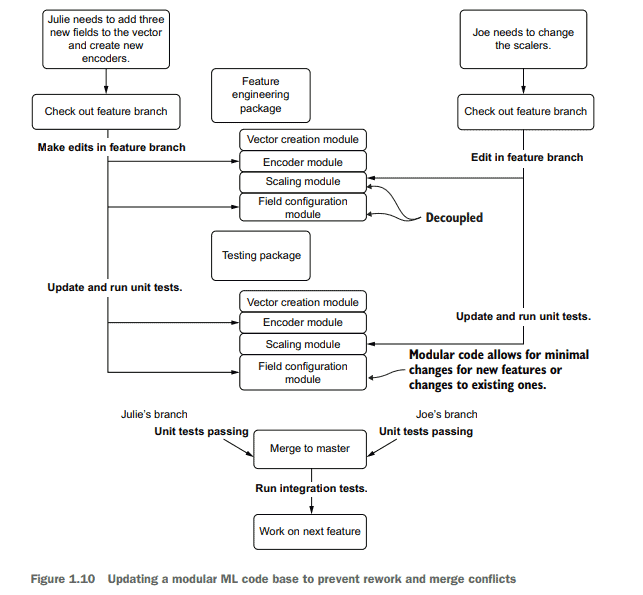

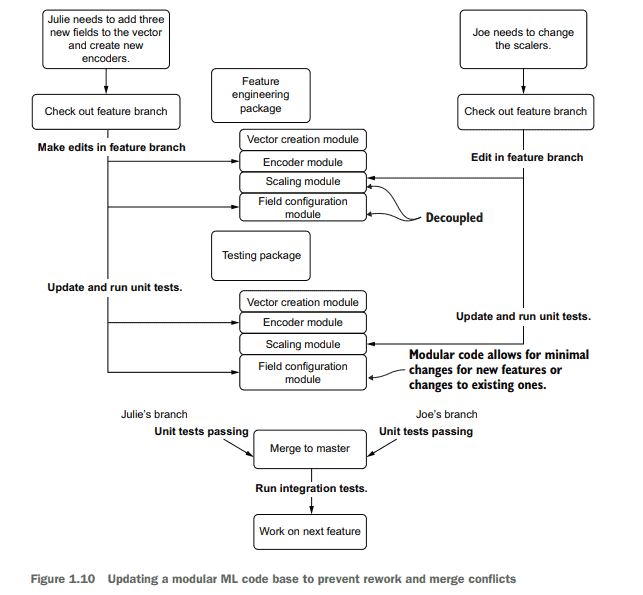

But most successful approaches to ML projects embrace aspects of both of these development styles. Keeping work incremental, adaptable to change, and focused on modular code that is not only testable but focused entirely on required features to meet the project guidelines is a proven approach that helps deliver the project on time while also creating a maintainable and extensible solution.

These Agile approaches will need to be borrowed from and adapted in order to create an effective development strategy that works not only for the development team, but also for an organization’s general software development practices. In addition, specific design needs can dictate slightly different approaches to implementing a particular project.

机器学习代考

计算机代写|机器学习代写machine learning代考|Can you put this into production? Would you want to maintain it?

对于较大的团队来说,实验阶段的主要目的是对模型实现的预测能力做出决定,而DS团队内部的主要目的之一是确定解决方案是否适合团队。DS团队领导、架构师或团队中的高级DS人员应该仔细研究这个项目将涉及到什么,提出困难的问题,并给出诚实的答案。以下是一些最重要的问题:

构建这个解决方案需要多长时间?

这个代码库会有多复杂?

根据需要再培训的时间安排,培训成本有多高?

我的团队是否具备维护该解决方案所需的技能?大家都知道这个算法/语言/平台吗?

如果训练或推断的数据发生了巨大的变化,我们能多快地修改这个解决方案?

有没有其他人报告使用这种方法/平台/语言/API取得了成功?我们是在重新发明轮子还是在建造一个方形的轮子?

团队需要做多少额外的工作才能使这个解决方案工作,同时满足所有其他功能目标?

这是可扩展的吗?当这个不可避免的2.0版本被要求时,我们能够轻松地增强这个解决方案吗?

这是可测试的吗?

这是可审计的吗?

在我的职业生涯中,有无数次,我要么是构建这些原型的人,要么是在审查别人的原型时提出这些问题的人。尽管ML实践者看到结果的第一反应通常是“让我们选择最好的结果”,但很多时候,“最好”的结果要么是几乎不可能完全实现,要么是一场噩梦。

计算机代写|机器学习代写machine learning代考|TDD vs. RDD vs. PDD vs. CDD for ML projects

在开发软件时,我们似乎有无数种方法可供选择。从瀑布到敏捷革命(以及它的各种风格),每一种都有优点和缺点。

我们不会讨论哪种开发方法对特定的项目或团队来说是最好的。已经出版了非常棒的书籍,深入探讨了这些主题,我强烈建议阅读它们来改进ML项目的开发过程。Greg Smith和Ahmed Sidky的《在不完美的世界中变得敏捷》(Manning, 2009)和Lasse Koskela的《测试驱动:Java开发人员的TDD和验收TDD》(Manning, 2007)都是值得注意的资源。然而,值得在这里讨论的是ML开发的四种一般方法(一种是成功的方法,另一种是警示故事)。

测试驱动开发或特性驱动开发

对于机器学习项目来说,纯粹的测试驱动开发(tdd)是难以置信的挑战(当然,最终无法实现与传统软件开发相同的测试覆盖率),主要是由于模型本身的不确定性。纯粹的功能驱动开发(FDD)方法会在项目期间导致大量的返工。

但是大多数成功的ML项目方法都包含了这两种开发风格。保持工作增量,适应变化,专注于模块化代码,不仅可测试,而且完全专注于满足项目指导方针所需的功能,这是一种经过验证的方法,可以帮助按时交付项目,同时创建可维护和可扩展的解决方案。

为了创建不仅适用于开发团队,而且适用于组织的一般软件开发实践的有效开发策略,需要借鉴和调整这些敏捷方法。此外,特定的设计需求可以指示实现特定项目的略微不同的方法。

统计代写请认准statistics-lab™. statistics-lab™为您的留学生涯保驾护航。

金融工程代写

金融工程是使用数学技术来解决金融问题。金融工程使用计算机科学、统计学、经济学和应用数学领域的工具和知识来解决当前的金融问题,以及设计新的和创新的金融产品。

非参数统计代写

非参数统计指的是一种统计方法,其中不假设数据来自于由少数参数决定的规定模型;这种模型的例子包括正态分布模型和线性回归模型。

广义线性模型代考

广义线性模型(GLM)归属统计学领域,是一种应用灵活的线性回归模型。该模型允许因变量的偏差分布有除了正态分布之外的其它分布。

术语 广义线性模型(GLM)通常是指给定连续和/或分类预测因素的连续响应变量的常规线性回归模型。它包括多元线性回归,以及方差分析和方差分析(仅含固定效应)。

有限元方法代写

有限元方法(FEM)是一种流行的方法,用于数值解决工程和数学建模中出现的微分方程。典型的问题领域包括结构分析、传热、流体流动、质量运输和电磁势等传统领域。

有限元是一种通用的数值方法,用于解决两个或三个空间变量的偏微分方程(即一些边界值问题)。为了解决一个问题,有限元将一个大系统细分为更小、更简单的部分,称为有限元。这是通过在空间维度上的特定空间离散化来实现的,它是通过构建对象的网格来实现的:用于求解的数值域,它有有限数量的点。边界值问题的有限元方法表述最终导致一个代数方程组。该方法在域上对未知函数进行逼近。[1] 然后将模拟这些有限元的简单方程组合成一个更大的方程系统,以模拟整个问题。然后,有限元通过变化微积分使相关的误差函数最小化来逼近一个解决方案。

tatistics-lab作为专业的留学生服务机构,多年来已为美国、英国、加拿大、澳洲等留学热门地的学生提供专业的学术服务,包括但不限于Essay代写,Assignment代写,Dissertation代写,Report代写,小组作业代写,Proposal代写,Paper代写,Presentation代写,计算机作业代写,论文修改和润色,网课代做,exam代考等等。写作范围涵盖高中,本科,研究生等海外留学全阶段,辐射金融,经济学,会计学,审计学,管理学等全球99%专业科目。写作团队既有专业英语母语作者,也有海外名校硕博留学生,每位写作老师都拥有过硬的语言能力,专业的学科背景和学术写作经验。我们承诺100%原创,100%专业,100%准时,100%满意。

随机分析代写

随机微积分是数学的一个分支,对随机过程进行操作。它允许为随机过程的积分定义一个关于随机过程的一致的积分理论。这个领域是由日本数学家伊藤清在第二次世界大战期间创建并开始的。

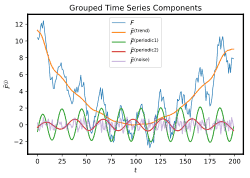

时间序列分析代写

随机过程,是依赖于参数的一组随机变量的全体,参数通常是时间。 随机变量是随机现象的数量表现,其时间序列是一组按照时间发生先后顺序进行排列的数据点序列。通常一组时间序列的时间间隔为一恒定值(如1秒,5分钟,12小时,7天,1年),因此时间序列可以作为离散时间数据进行分析处理。研究时间序列数据的意义在于现实中,往往需要研究某个事物其随时间发展变化的规律。这就需要通过研究该事物过去发展的历史记录,以得到其自身发展的规律。

回归分析代写

多元回归分析渐进(Multiple Regression Analysis Asymptotics)属于计量经济学领域,主要是一种数学上的统计分析方法,可以分析复杂情况下各影响因素的数学关系,在自然科学、社会和经济学等多个领域内应用广泛。

MATLAB代写

MATLAB 是一种用于技术计算的高性能语言。它将计算、可视化和编程集成在一个易于使用的环境中,其中问题和解决方案以熟悉的数学符号表示。典型用途包括:数学和计算算法开发建模、仿真和原型制作数据分析、探索和可视化科学和工程图形应用程序开发,包括图形用户界面构建MATLAB 是一个交互式系统,其基本数据元素是一个不需要维度的数组。这使您可以解决许多技术计算问题,尤其是那些具有矩阵和向量公式的问题,而只需用 C 或 Fortran 等标量非交互式语言编写程序所需的时间的一小部分。MATLAB 名称代表矩阵实验室。MATLAB 最初的编写目的是提供对由 LINPACK 和 EISPACK 项目开发的矩阵软件的轻松访问,这两个项目共同代表了矩阵计算软件的最新技术。MATLAB 经过多年的发展,得到了许多用户的投入。在大学环境中,它是数学、工程和科学入门和高级课程的标准教学工具。在工业领域,MATLAB 是高效研究、开发和分析的首选工具。MATLAB 具有一系列称为工具箱的特定于应用程序的解决方案。对于大多数 MATLAB 用户来说非常重要,工具箱允许您学习和应用专业技术。工具箱是 MATLAB 函数(M 文件)的综合集合,可扩展 MATLAB 环境以解决特定类别的问题。可用工具箱的领域包括信号处理、控制系统、神经网络、模糊逻辑、小波、仿真等。